20+移动端硬件,Int8极速推理,端侧推理引擎Paddle Lite 2.0 正式发布

机器之心发布

今年 8 月,飞桨(PaddlePaddle)对外发布面向终端和边缘设备的端侧推理引擎 Paddle Lite Beta 版。经过近两个多月的迭代和发展,2019 Wave Summit+ 深度学习开发者峰会上 Paddle Lite 2.0 正式版发布。

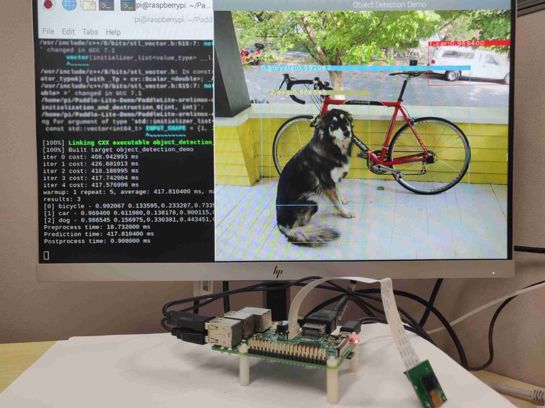

图 1 .典型端侧 AI 应用部署场景

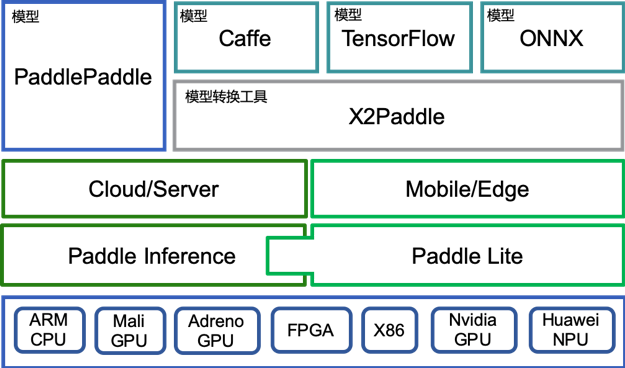

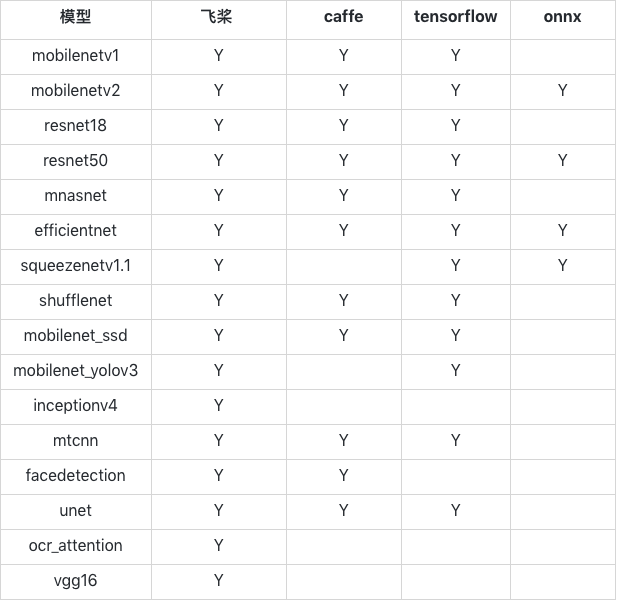

多框架支持:原生支持 PaddlePaddle 的模型,同时通过 X2Paddle 工具,提供对 TensorFlow,PyTorch 和 ONNX 模型格式的更充分的支持;

多硬件支持:除了 ARM CPU、移动端 GPU、华为 NPU,新增支持 Nvidia GPU 和 X86 CPU;

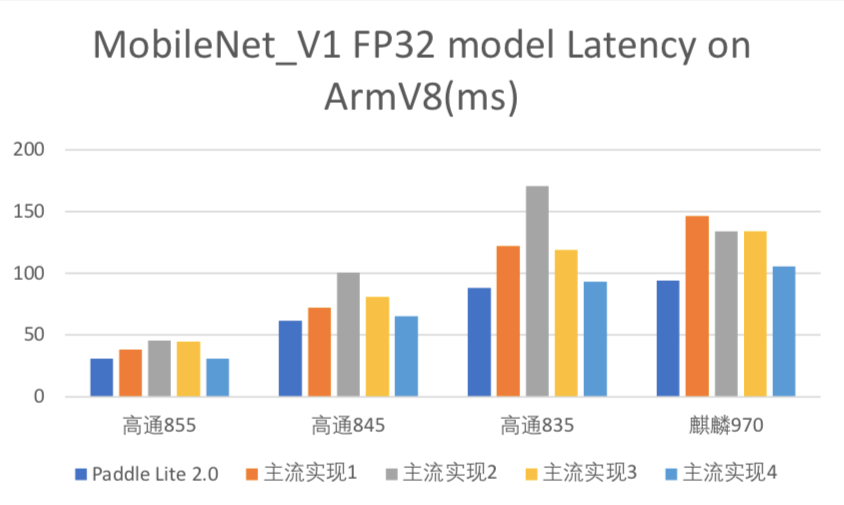

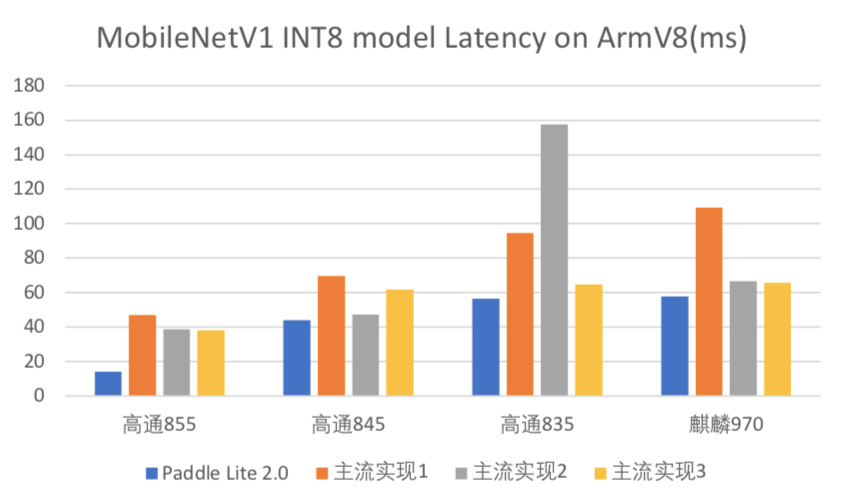

更好的性能:更新 benchmark,提升了在 ARM CPU 上尤其是 int8 的性能;

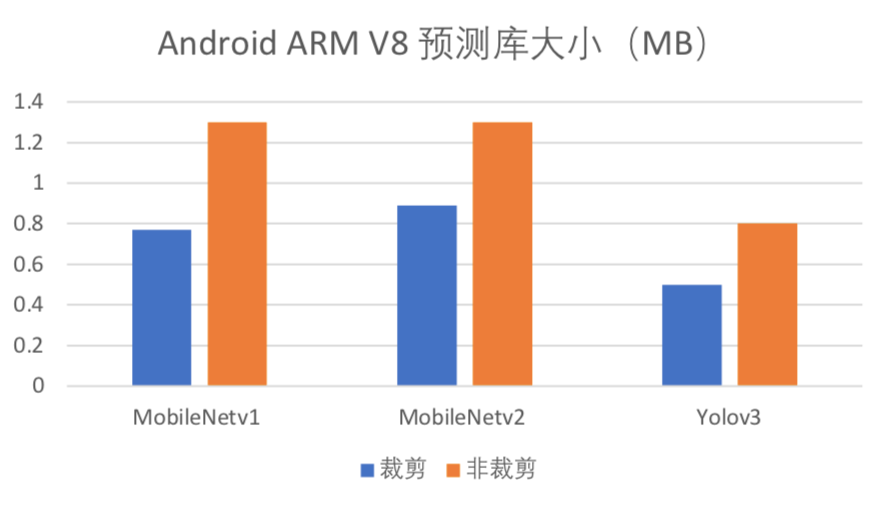

更加完备的功能:支持 python API,优化编译流程,新增预测库极致裁剪等功能;

更加完善的文档和 demo:提供完善的文档和多平台的 demo,包括安卓、iOS 和树莓派等。

多框架支持

-transformer

-facebox

-blazeface

-shufflenetv2

-mobilenet-ssd

-vgg16

-googlenet

-mobilenetv1

-mobilenetv2

-Resnet50

-Yolov3

-Alexnet

-Unet

图4

测试条件:batchsize=1,单线程

支持 python API

优化编译流程

tiny_publish:用于对部署体积有严格要求的平台,对应 MobileConfig 预测接口。

full_publish:用于对部署体积无要求的平台,使用简便,对应 CxxConfig 预测接口。

-android ARM CPU, GPU

-iOS

-X86

-NV GPU/CUDA

-Huawei NPU

-ARM Linux

预测库极致裁剪

增加支持硬件的列表,参考:

https://paddlepaddle.github.io/Paddle-Lite/v2.0.0/support_hardware/

增加根据模型裁剪算子的方法,参考:

https://paddlepaddle.github.io/Paddle-Lite/v2.0.0/library_tailoring/

更新最新 Benchmark,参考:

https://paddlepaddle.github.io/Paddle-Lite/v2.0.0/benchmark/

-Android ARM CPU

-Android Huawei NPU

-iOS ARM CPU

-ARM Linux 树莓派