AI安全周报|Deepfake技术将人脸变成动物、成人实时流媒体网站108.8亿条信息数据遭泄露

Deepfake技术将人脸变成动物,比利时研究员制作现实世界版Zootopia

近日,来自比利时的研究员Xander Steenbrugge制作了新的AI模型,该模型可以将人脸变成动物,反之亦然。与创建大多数Deepfake的方法相同,这一模型是采用对抗生成网络(GAN)创建的,该网络可以从大量数据中“学习”。

为了实现“人类-动物”之间面部的转换,Steenbrugge使用了15,000种高清动物图片,并通过生成模型StarGAN v2对图片进行了分析。

该实验是Steenbrugge神经通感项目的一部分,该项目使用机器学习算法和模型创建沉浸式视听项目。Steenbrugge表示:“我并没有完全创造出这些作品,而是与AI模型一起给他们赋予生命。”该模型诞生后,人们对其态度各异。有人表示,这简直就是“Zootopia”(动物乌托邦)的现实版,也有人表示这就是Steenbrugge“跨物种AI梦想的实现”。

仅需更改几个像素,当前的Deepfake检测器便会完全失效

上个月,比利时总理索菲·威尔梅斯在网络在线视频中告诉她的观众,“COVID-19大流行与‘人类对自然环境的开发和破坏’有关”的视频引发了比利时民众的热议。虽然事实是,该视频是由某气候变化活动家制作的Deepfake假视频。

当前,随着许多Deepfake检测的措施持续出现,人们能够识别出大量Deepfake图像与视频,许多人也因此感到一种“虚假的安全感”。然而,这种“安全感”可能与事实相距甚远。随着计算机功能越来越强大,算法越来越复杂,Deepfakes只会变得更容易生成,并且更难被检测到。有人曾表示,“Deepfake是机器学习的冠状病毒。”

近日,国外某高校(USC)电气和计算机工程专业硕士生Apurva Gandhi和Shomik Jain的论文中展示了一个案例:Deepfake图像即使经过最细微的修改,也可以欺骗最成熟的检测器。Google Brain的团队对他们的论文进行了引用,并对“如何修改Deepfake图像能够使检测器无法识别”进行了详细研究。

当今的Deepfake检测器往往基于卷积神经网络。这些模型最初看起来非常准确,但它们却存在重大缺陷。Gandhi和Jain表示,这些Deepfake检测器容易受到对抗性干扰的干扰——仅将图像中的几个像素值更改便可以使得检测器失效。

“如果Deepfake是一种病毒,而Deepfake检测器是一种疫苗,那么你可以将对抗性干扰视为一种突变。就像病毒的一个微小突变可能会使疫苗失去作用一样,图像的微小扰动也可以使最新的Deepfake检测器失去作用。”

他们的论文结果揭示了当前Deepfake带来的安全问题有多严重。在实验中,最初受过训练的神经网络能够识别出95%以上的正常Deepfake。但是当对图像进行干扰时,检测器却完全无法检测这是Deepfake图像。实际上,当前全球的Deepfake安全措施都是滞后的。尤其近日来,随着西方选举的来临,以及新冠病毒大流行的威胁,网络上流传着大量相关的Deepfake内容,这些虚假信息对网络社区安全的威胁后果绝对不容小觑。

成人实时流媒体网站CAM4 108.8亿条信息数据遭泄露,其中包括53万中国用户

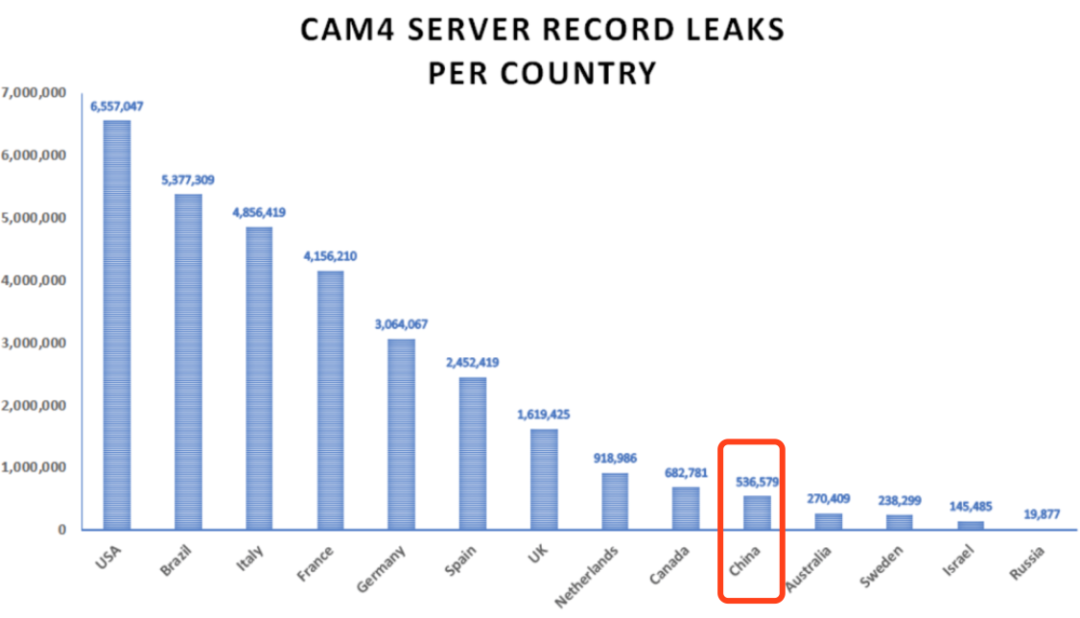

近日,据外媒报道,成人实时流媒体网站CAM4遭遇数据泄露,该数据共计超过7TB,包含用户的姓名,性取向,付款记录,电子邮件和聊天记录,总计108.8亿条记录,所涉及的信息风险则更高。

CAM4是一个实时流媒体网站,该网站提供实时网络摄像头表演,并按女性,男性,变性者或对主要业余表演者进行过滤。CAM4由Granity娱乐公司拥有,每年大约有20亿访客。

此次,暴露的信息是由Anurag Sen领导的SafetyDetectives研究小组发现的,他们发现后并迅速向 Granity网站报告了此问题。他们在报告时称:“被泄露的Elastic Search数据库包含大量的用户和公司信息,其中绝大部分电子邮件数据记录都涉及美国的用户。”

据了解,此次数据泄漏是由公司管理的Elastic search集群意外暴露造成的,记录可追溯到2020年3月16日。本次泄露事件危及大约660万美国CAM4用户、540万巴西用户、490万意大利用户、420万法国用户,以及53万以上的中国用户。

同时,安全团队还发现了超过2639万条带有密码散列的条目,其中一部分属于CAM4.com用户,而另一部分则是来自网站系统的资源。据研究人员表示,这些信息还包括用户全名、信用卡类型和支付金额等数据,攻击者可以利用这些信息进行复杂的网络钓鱼攻击和诈骗活动。

Clearview AI推出面部识别技术来追踪COVID-19,该技术引发众多质疑

Clearview AI是一家面部识别软件公司,该公司曾帮助全球超过2,200个政府和执法部门追踪可疑犯罪分子。今年1月份,该公司因使用其照片数据库来识别数百万人而遭到了来自各方的质疑。该公司在未经用户明确许可的前提下,从社交媒体帐户获取公民图像和数据,这一行为引发争议。

而现在,这家科技公司正与联邦和州当局进行谈判。起因是,该公司开发出了新的面部识别技术,以帮助追踪新型冠状病毒的传播。

事实上,苹果和谷歌在4月份已经宣布,他们正在开发疫情相关的应用程序,由于蓝牙更容易保密,相关应用将使用蓝牙感应功能对联系人进行追踪。

但是相对于苹果与谷歌,Clearview AI的首席执行官Ton-That表示,Clearview的技术可以实现更积极的联系人跟踪。该公司可以在诸如餐馆或商店等场所的监视视频中识别可能被冠状病毒检测呈阳性的人接触的人。从理论上讲,Clearview AI的技术能够识别出现在监视视频中的任何人。

Ton-That称,Clearview AI与州和联邦当局的讨论是初步的,公共和私人场所中现有的监视摄像头网络已经为Clearview AI提供了公司面部识别所需的东西。

Ton-That同时表示:“许多零售场所和体育馆都有监控摄像。而且在公共场所,人们不一定有对隐私的期望。现在我们可以将这些监控摄像用于跟踪感染病毒的人。”

该技术提出后,引发美国民众热议。目前尚不清楚Clearview AI的技术是否可以减缓冠状病毒的传播,但许多人仍怀疑,采用Clearview AI面部识别技术会对用户的隐私产生不可逆的损害。

美国卫生法政策,生物技术与生物伦理学中心主任格伦·科恩(Glenn Cohen)表示:“在世界许多地方,技术与强制性或准强制性的社会控制手段混杂在一起。” 事实上,Clearview AI的技术对西方多国崇尚的隐私安全提出了严峻挑战,该公司的政治倾向也使得民众对该公司并不信任。不仅是该公司的技术,Clearview AI使用该技术收集的数据,除了医疗方面,是否会用于其他用途也引发民众怀疑。

Google和Apple禁止在其联系人跟踪应用程序中进行位置追踪

苹果和谷歌已经宣布他们的新型冠状病毒追踪技术将禁止使用位置追踪功能。该公告可能会对某些计划使用这两家公司的系统的人带来一定烦恼。

接触者追踪是指追踪和联系可能接触传染病的人的过程。专家认为,对接触者追踪进行监控是新型冠状病毒大流行期间促使社会正常秩序恢复的重要程序。

然而对这一环节进行追踪需要很多人力,仅在美国,就有成千上万的人参与其中。苹果和谷歌新技术的诞生,能够很大程度补充这一环节人工劳力的不足。据预计,该应用程序完整的系统,将使用蓝牙信号来确定用户与确诊的covid-19患者的距离,预计该程序将于5月中旬发布。

除了禁止位置共享外,苹果和谷歌这两家硅谷巨头还向他们的开发人员公布了一系列其他要求。其中:只有政府卫生部门可以创建相应的应用程序;使用曝光通知API之前,所有应用都必须征得用户同意;与公共卫生当局共享阳性检测结果之前,必须先征得用户同意。最后,最重要的一点,必须最小化数据收集,并且仅将其用于新冠的健康响应。禁止将收集到的数据用于其他用途:比如说定向广告或警务方面。

往期回顾