自动驾驶车祸频发到底是谁的“锅”?

特斯拉又双叒撞了!

6月1日上午,台湾嘉义县水上乡高速路段上,一辆货车侧翻在地,后来车辆纷纷避让。唯独一辆Model 3,以110公里的时速,没有采取任何减速或转向避让的动作,笔直地撞向了侧翻货车。

曾在2016年发生首起撞人事故后,特斯拉称,作为一项新技术,自动驾驶功能还处在公共测试阶段。但如今,四年过去了,特斯拉的AutoPilot系统还是如此“令人智熄”...

当然,“搞事情”也并非特斯拉的专属,Uber、Waymo等自动驾驶汽车都发生过或大或小的事故。

只是,自动驾驶研发的一大重要初衷就是减少大量人为原因导致的交通事故,但接二连三发生事故却不得不让我们发问:自动驾驶距离“安全驾驶”到底还有多远?

车祸频发到底谁的锅:

硬件缺陷or算法不足?

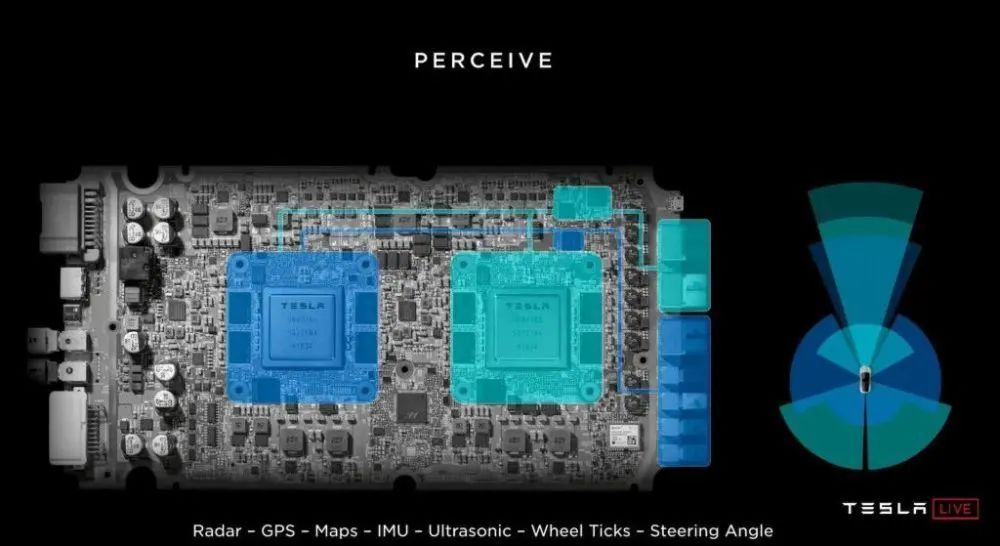

我们知道,自动驾驶的技术范式包含三大方面:感知、决策、执行,其中感知系统一直是特斯拉被“诟病”最多的地方。

这次特斯拉撞向侧翻货车的事故发生后,公众的讨论声也大多聚焦在AutoPilot的感知方案过度依赖性视觉系统,容易受到视觉欺骗,导致难以分辨出白色物体。

的确,相较于业界普遍采用“激光雷达为主、摄像头为辅”的传感器配置,马斯克一直执着于视觉路线,特斯拉采用的是“摄像头为主、毫米波雷达为辅” 多传感器融合的视觉方案。

虽然在抗环境干扰上,毫米波雷达显著优于激光雷达,但在探测精度和分辨率上有所局限,尤其对周边障碍物尤其是静态物体无法精准建模。在遇到道路前方的“障碍”时,毫米波雷达只能“看到”模糊的形状,然后由摄像头再进行识别判断。

所以,这次发生的车祸之所以发生,打个有趣的比方,就类似于:「毫米波看到前方有个东西,但不确定是什么,然后去问摄像头大哥:这是什么东西?结果摄像头说,我也没见过,不知道是啥。」最后只能眼睁睁地撞上去了...

换句话说,从传感器角度来看,Autopilot系统中的毫米波跟摄像头都“看到”了前方物体,但反馈到决策大脑(计算平台),大脑没有分辨出或没有及时分辨出前方物体是广告牌、天际线还是侧翻的白色货柜车。

这样看来,一味将责任追究于用来探测障碍物的雷达摄像头,似乎有些甩锅的意味,毕竟具体到Model 3该款车型上,该车配备了8个摄像头、12个超声波传感器与1个增强版毫米波雷达,单从感知能力来看,并不比人眼的观察能力弱。

但弱就弱在,决策大脑对感知数据的处理能力,对自动驾驶系统而言也就是核心的算法能力。

当然,或许有人会好奇,采用探测能力更胜一筹的激光雷达,不是一劳永逸吗?探测精度比毫米波高,遇到障碍物时可以直接生成3D图像,比摄像头还略胜一筹。

的确,在本次案例中,如果Model 3采用的是激光雷达,很大可能可以避免车祸,但并不意味激光雷达可以完全弥补决策算法的不足。

比如下面这个案例:

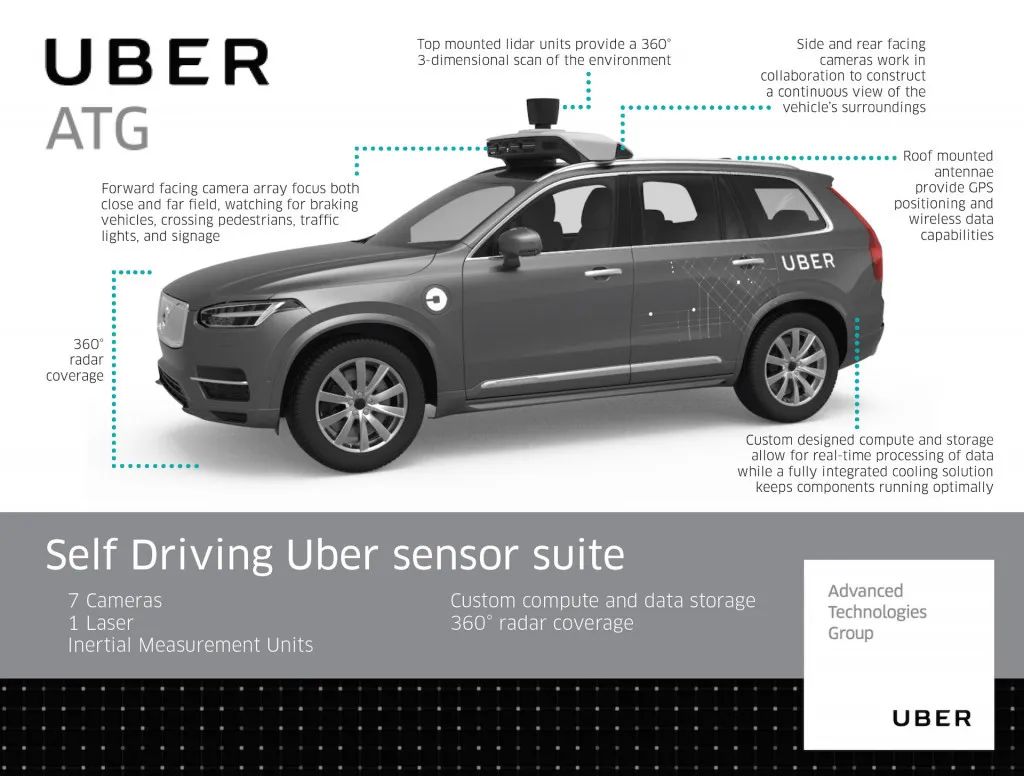

2018年3月19日晚上10点左右,一辆Uber自动驾驶汽车在亚利桑那州坦佩市的公共道路上与一名行人相撞,该行人在送往医院后不治身亡,据了解,Uber 涉事车辆在发生事故时处于自动驾驶模式。

根据公开资料显示,这辆Uber自动驾驶车辆的硬件配置包括1个64线激光雷达、7个摄像头(包括短距和长距)、两个前置雷达(毫米波)、多个超声波传感器。

就感知层面而言,这套方案已经比较成熟,事故发生当天也并非雨天等恶劣天气,虽然视频中来看,事故当晚路灯光线一般,行人穿着也是深色系衣服,但对于64线激光雷达而言,零识别的概率很低。按照这样推测,问题仍在出现在决策环节。

近年来伴随辅助驾驶系统的大量部署和长时间的技术开发,自动驾驶的传感器配置已经相当完备,前视多目摄像头、长短距雷达、环视摄像头、十个以上的超声波雷达,再配上几个低线束的激光雷达,类似多传感器融合的感知方案安全系数是足够有保障的。

由此可以看出,感知硬件的物理缺陷已经不是自动驾驶最主要的瓶颈,决策算法的不足才是。

“边缘情况”不是决策算法

面临的唯一难题

无论是「侧翻的白色货车」又或者「异形静态车辆」,自动驾驶很多时候“傻傻分不清”是因为遇到了“边缘情况”场景,这种场景也被称为“Corner Case”或“Edge Case”,即极端情况或极小概率事件,也就是自动驾驶系统遇到了在其算法中没有预期到的情况。

结合算法原理来看,目前自动驾驶的识别算法主要基于深度学习,为了教会识别模型判断道路情况,通常是依靠输入大量有的道路场景数据帮助其学习。

由于训练数据仅仅只能覆盖部分限定场景,所以在开放道路场景下,“侧翻的白色货车”“翻越栅栏的行人”等未知的场景数据在训练过程中没有遇到过的,模型没有学过,所以导致在真实运行过程中识别不出来。

除了道路环境复杂,“边缘情况”情况的出现还可能受制于多方面原因,比如:

强光或强地面反光时成像效果不好;

夜间光亮不够,摄像头成像不清晰;

受雨雪,雾霾等恶劣天气影响;

传感器受到视角、遮挡、污损等影响;

目标物被车辆或其他物体被遮挡...

自动驾驶汽车一旦遇上类似“边缘情况”,可能一时间难以进行分析从而作出危及生命的决策。

介于目前自动驾驶的决策算法对“边缘情况”场景做出无误的判断,仍有难度,所以也就倒逼自动驾驶厂商去升级感知系统,采用多感知设备融合的方案,希望用更精确、更全面的感知数据来弥补决策算法的短板。

短期来看,这的确能一定程度上提升识别效果的可靠性,但长期来看,硬件的长板效应存在天花板,补强算法短板依旧是重中之重。

另一方面,在使用多种类传感器之后,自动驾驶系统就必须要对传感器进行信息融合,这也意味着自动驾驶的计算平台要从算法上对摄像头、激光雷达、毫米波雷达探测的信息数据做好优先级排序和决策,从而保证自动驾驶系统决策的正确性。

这无疑又是算法需要解决跟优化的新难题。

“三枚小贴纸让汽车拐进反向车道”、“播放干扰画面让汽车误以为下雨打开雨刷器”、“用贴纸伪装路牌干扰汽车正确判断”...

这些“花式操纵”自动驾驶汽车的新闻近两年层出不穷,这背后其实就揭露了自动驾驶决策面临的新型威胁——对抗样本。

对抗样本原本是机器学习模型的一个有趣现象,在源数据上增加肉眼难以辨识到的细微改变,可以让型接受并做出错误的分类决定。

但作为一台智能物联网设备,这一漏洞的出现却可能让自动驾驶汽车面临攻击风险,成为一颗不定时“炸弹”。比如黑客恶意制造“致盲攻击”,通过在障碍物或其它车辆上安装“对抗样本补丁”,让被攻击的自动驾驶车辆无法正常识别眼前物体,故意导致车祸。

如果说“边缘情况”是客观存在的问题,那对抗样本则带来了主观人为操纵的风险,机动性强,一旦被成功利用,后果将更加不堪设想。

自动驾驶汽车要“独自上路”,

该如何变得更加安全?

现有决策算法面临的最大挑战,就是如何达到自动驾驶所需要的极高的安全性和可靠性。

我们知道,汹涌而至的深度学习热潮推动了自动驾驶的快速兴起,但自动驾驶要真正实现高度甚至完全智能化,必须具备高鲁棒性,识别准确性和精确性需要达到甚至超过人类的认知水平,以确保自动驾驶汽车即使遇到突发情况也能较好应对。

深度学习方法虽然有效,但显然距离这一目标还是有很大差距。

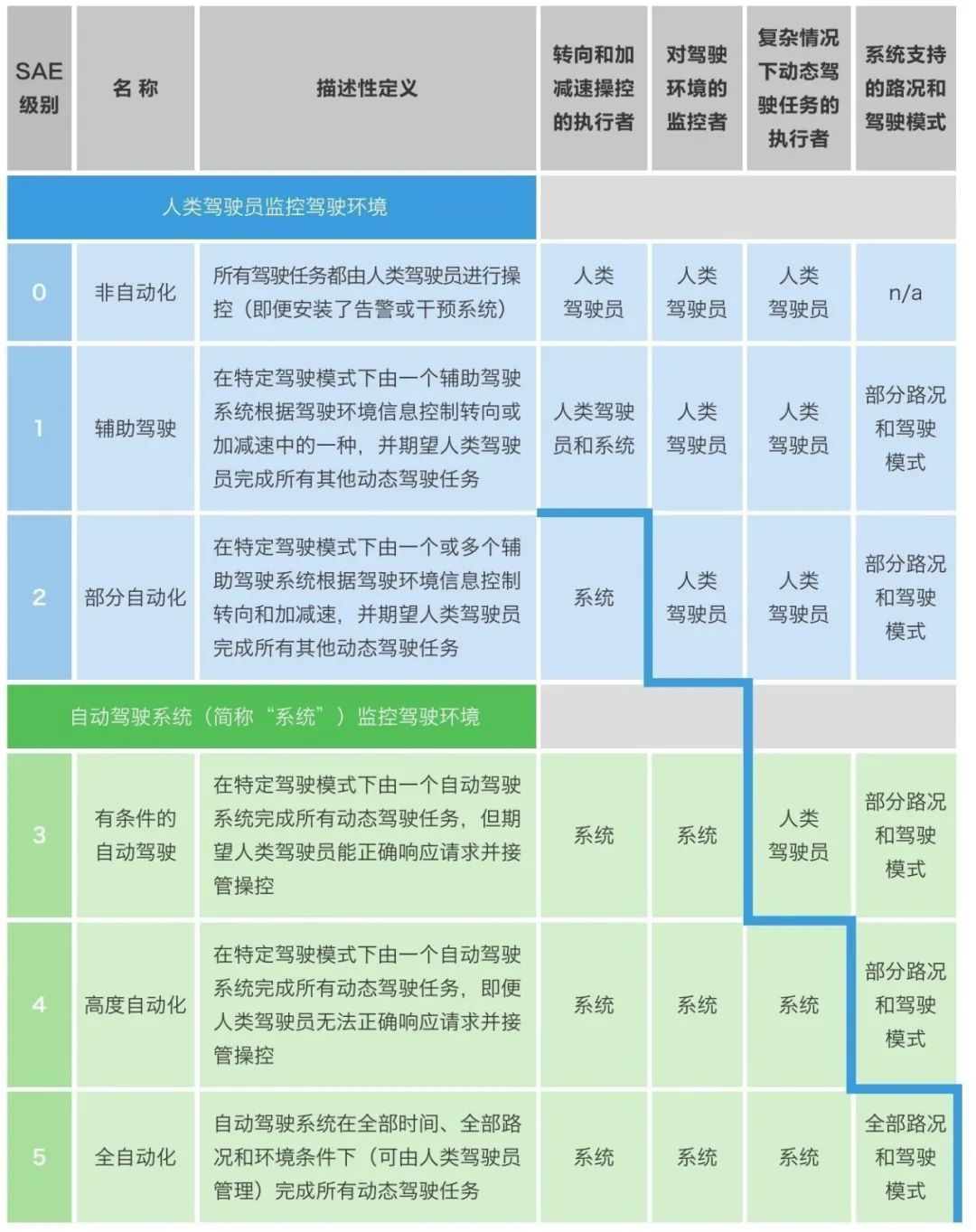

根据自动驾驶分级标准SAE表,目前已发布的量产自动驾驶车型主要分布在L2、L3,距离L4高度自动化还有大差距

直观来讲,深度学习算法较为依赖数据,推理能力是有限的,但人脑不需要看大量的样本就可以对事物进行准确区分。

而且很多创新公司都在使用深度学习加增强学习做端到端的训练,也就是说,自动驾驶系统中传感器的输入会直接导出控制器的输出,整个过程是个黑盒,无法进行分析,出了事不知道原因到底是什么,也没有办法预测下一次会出什么状况。

自动驾驶要更安全,首先得跨过“深度学习”这一关,引入新的决策机制,比如近年来的一个重大趋势,从概率推理到因果推理,给自动驾驶系统引入类似人类智能的理性决策,提升车辆的认知能力。

可以说,无论是特斯拉,还是Waymo,决策算法将会成为他们争夺自动驾驶高地的核心竞争力。包括近日据外媒透露,苹果也正研究更安全、更可靠的自动驾驶算法,可见其重要性。

当然了,自动驾驶汽车作为一辆多方面协同的智能设备,要达到“完全独自上路”的水平还有很长的路要走,融合感知算法、多传感器处理、信息安全防护等等都将是需要解决的难题。

对于自动驾驶行业而言,想要汽车独自、安全的上路,未来仍是一段漫长而又富有挑战的岁月。

【参考文章】:

《自动驾驶优化出更好的算法》.汽车工程师

《特斯拉再撞白色卡车,自动驾驶安全性该怎么保证?》.TechSugar

《决策算法成竞争焦点,呼吁新计算平台》.李星宇

《Uber自动驾驶致死事故难道是算法出了问题?》.网易汽车

《毫米波雷达:自动驾驶三件套的真“C位”?》.脑极体

往期回顾