MIT HAN Lab提出HAT,为不同硬件设计高效适配NLP模型

本文作者:MIT计算机科学在读博士生-王瀚锐

关于作者:

王瀚锐,麻省理工学院 (MIT) 计算机科学专业第二年博士生,导师为韩松教授。他的研究方向为计算机体系结构和高效机器学习。

主页 https://hanruiwang.me

文章:https://arxiv.org/abs/2005.14187

网站:https://hat.mit.edu

开源:https://github.com/mit-han-lab/hardware-aware-transformers

视频介绍:

https://www.bilibili.com/video/BV1mt4y197FL/

https://youtu.be/N_tH1jIbqCw

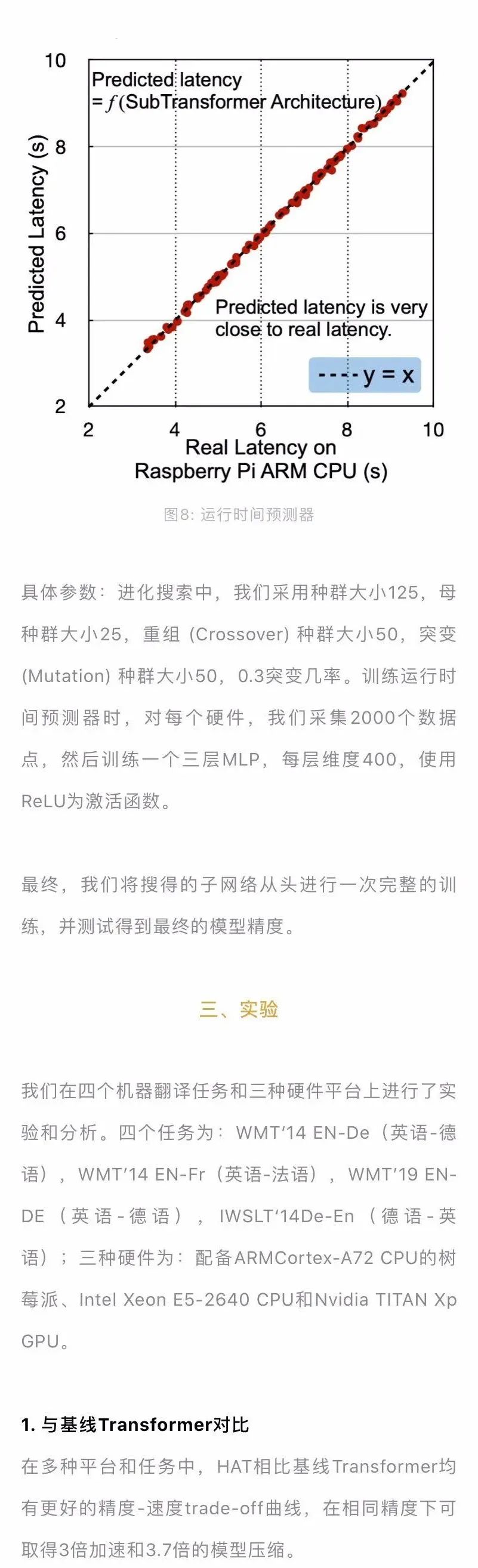

图9:HAT相比基线Transformer有更好的精度-速度trade-off

希望进一步了解该工作的朋友可以点击下方视频,查看作者详解~

扫码观看!

本周上新!

来扫我呀

关于我“门”

▼

将门是一家以专注于发掘、加速及投资技术驱动型创业公司的新型创投机构,旗下涵盖将门创新服务、将门技术社群以及将门创投基金。将门成立于2015年底,创始团队由微软创投在中国的创始团队原班人马构建而成,曾为微软优选和深度孵化了126家创新的技术型创业公司。

将门创新服务专注于使创新的技术落地于真正的应用场景,激活和实现全新的商业价值,服务于行业领先企业和技术创新型创业公司。

将门技术社群专注于帮助技术创新型的创业公司提供来自产、学、研、创领域的核心技术专家的技术分享和学习内容,使创新成为持续的核心竞争力。

将门创投基金专注于投资通过技术创新激活商业场景,实现商业价值的初创企业,关注技术领域包括机器智能、物联网、自然人机交互、企业计算。在近四年的时间里,将门创投基金已经投资了包括量化派、码隆科技、禾赛科技、宽拓科技、杉数科技、迪英加科技等数十家具有高成长潜力的技术型创业公司。

如果您是技术领域的初创企业,不仅想获得投资,还希望获得一系列持续性、有价值的投后服务,欢迎发送或者推荐项目给我“门”: bp@thejiangmen.com

将门创投

让创新获得认可!

微信:thejiangmen

bp@thejiangmen.com

点击“❀在看”,让更多朋友们看到吧~