7 Papers & Radios | NumPy论文登上Nature;高效Transformer综述

机器之心 & ArXiv Weekly Radiostation

本周的重要论文包括 登上 Nature 的 NumPy 论文,以及高效 Transformer 综述论文。

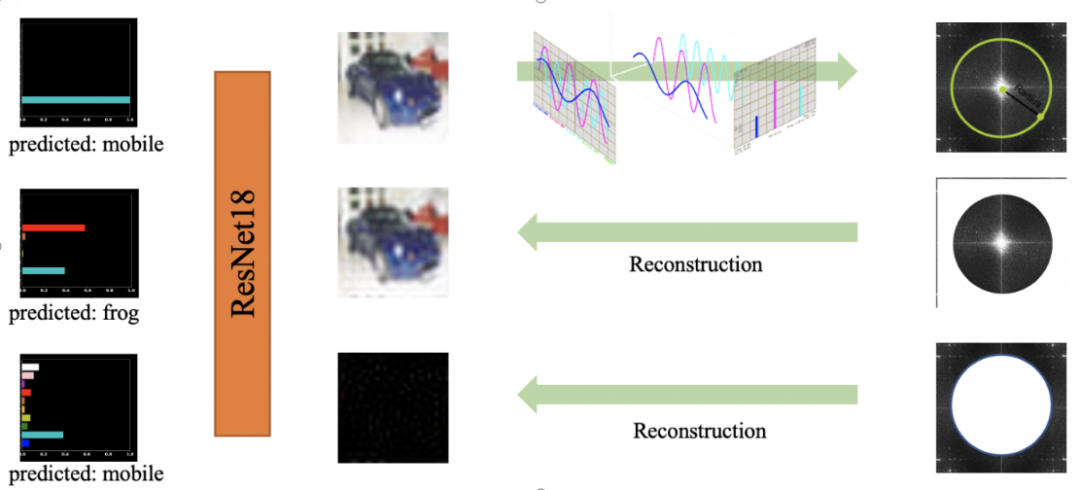

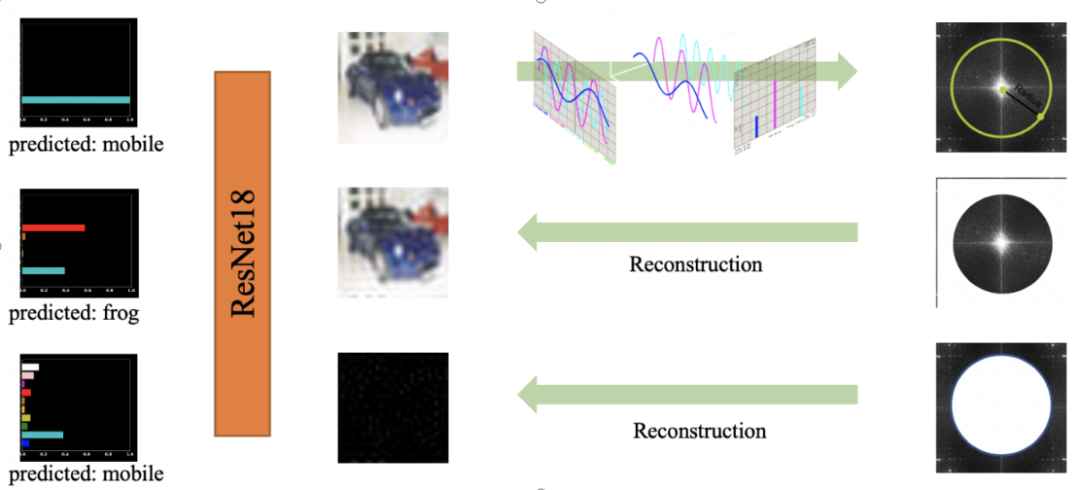

High-frequency Component Helps Explain the Generalization of Convolutional Neural Network

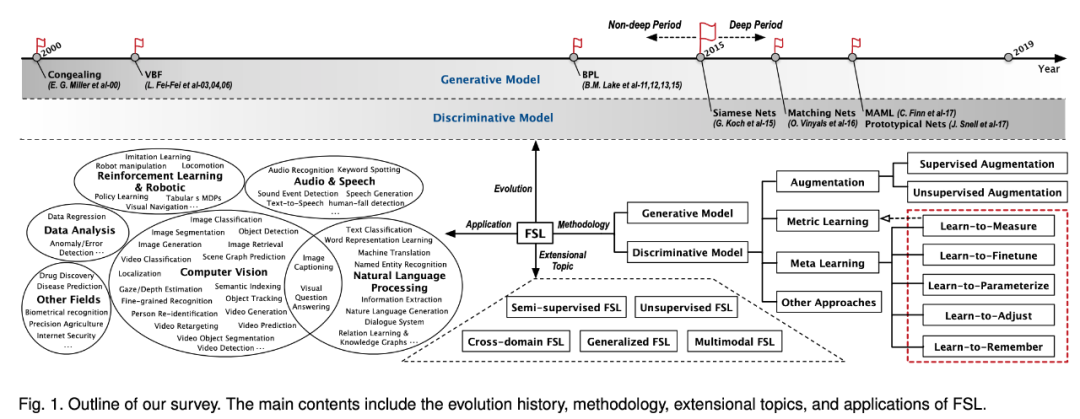

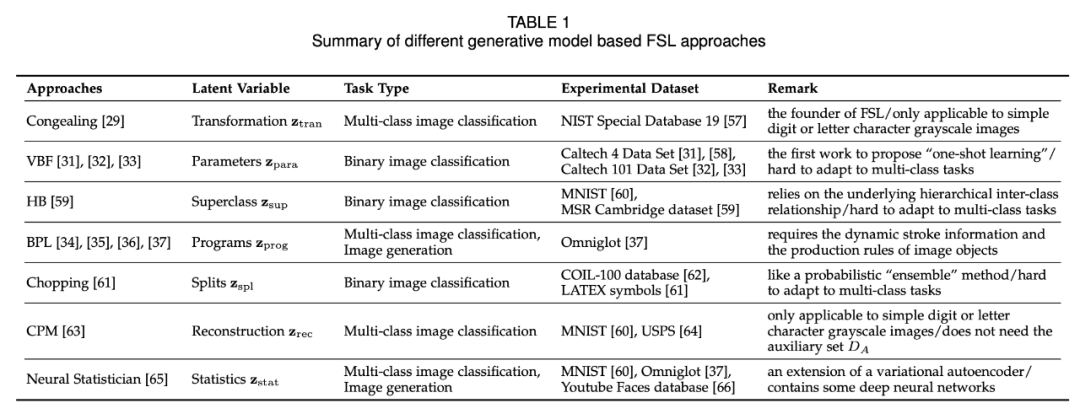

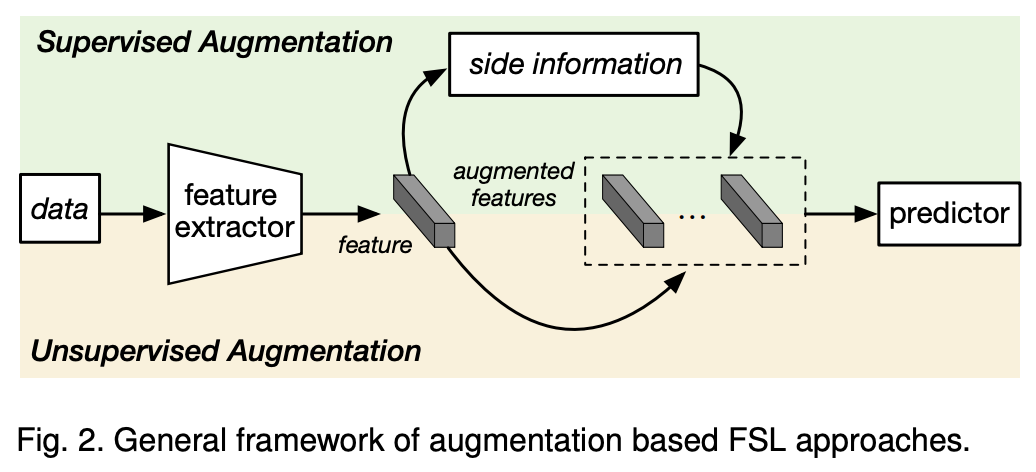

Learning from Very Few Samples: A Survey

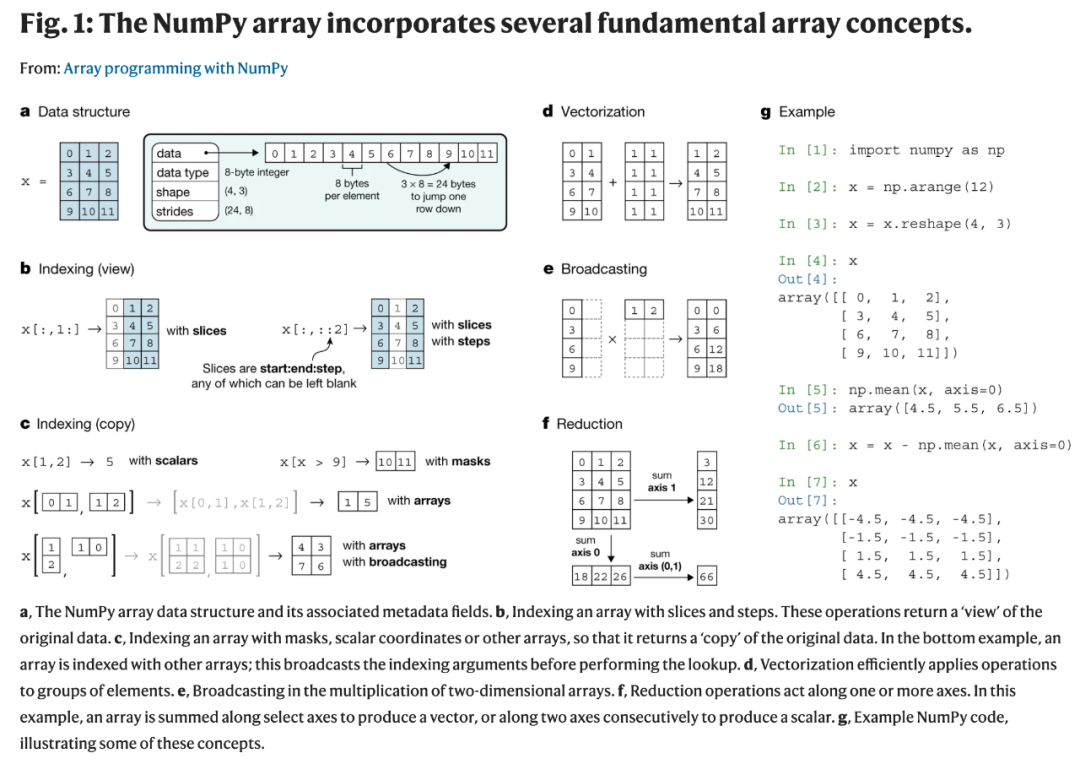

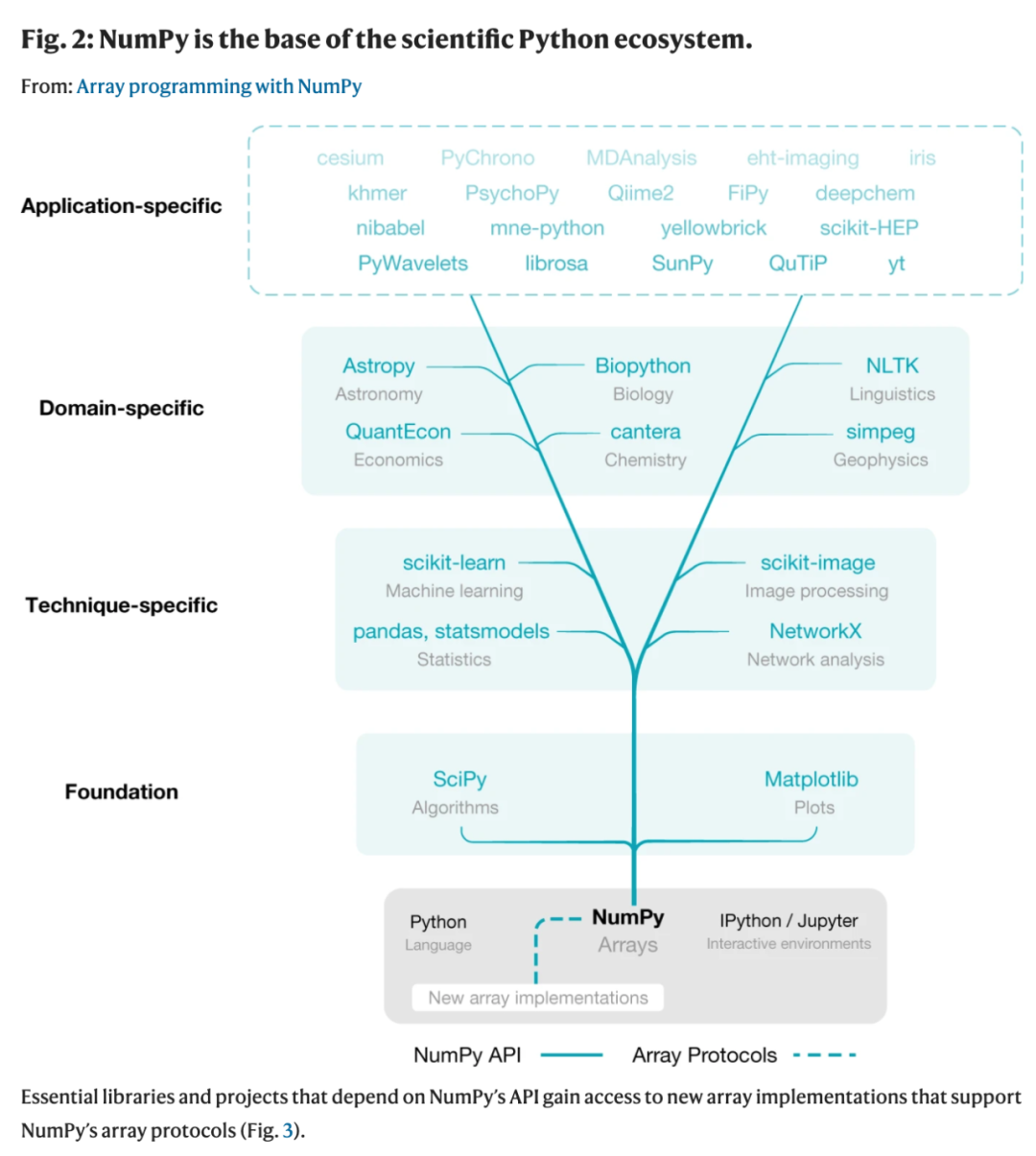

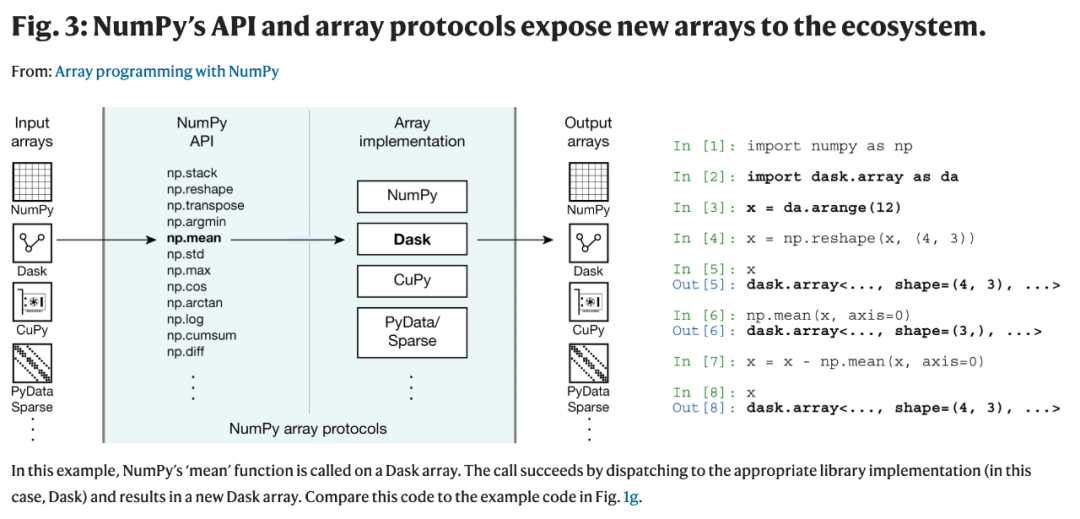

Array programming with NumPy

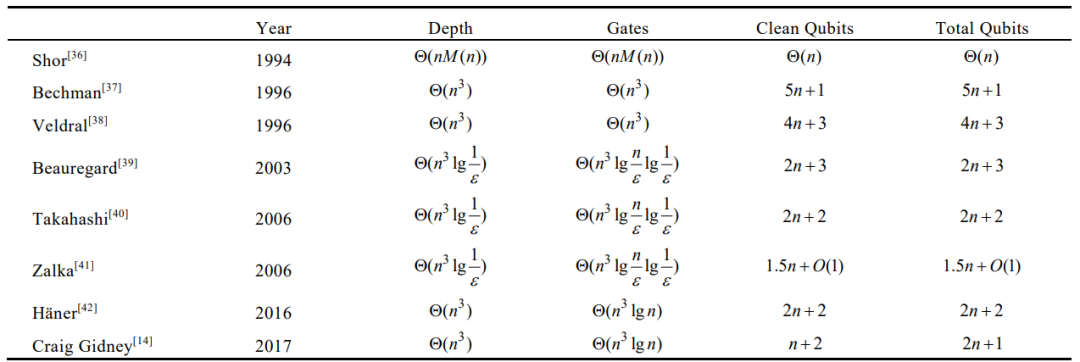

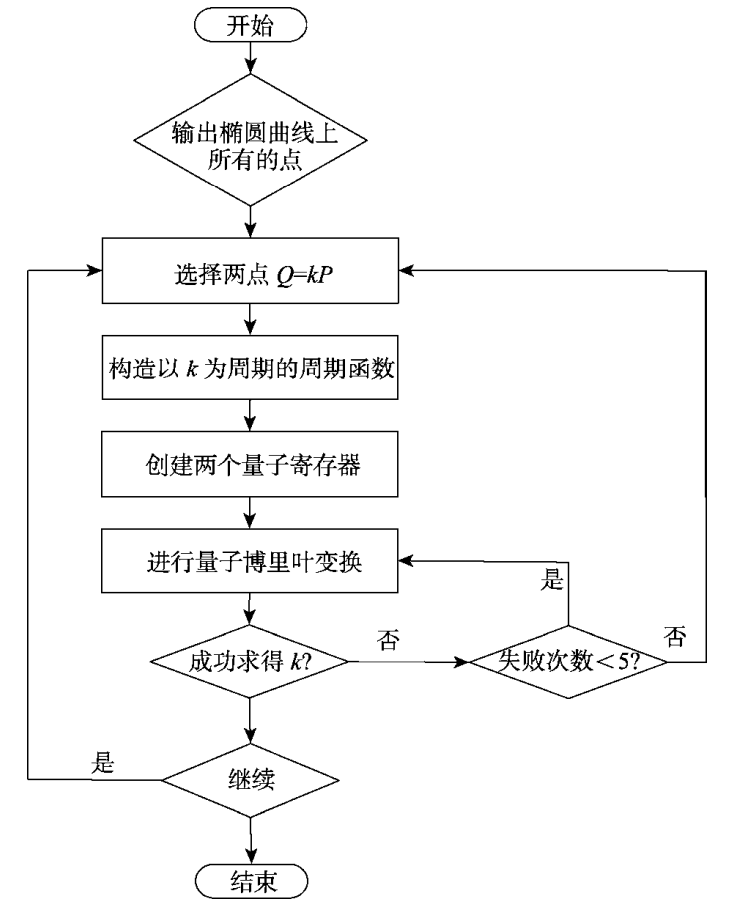

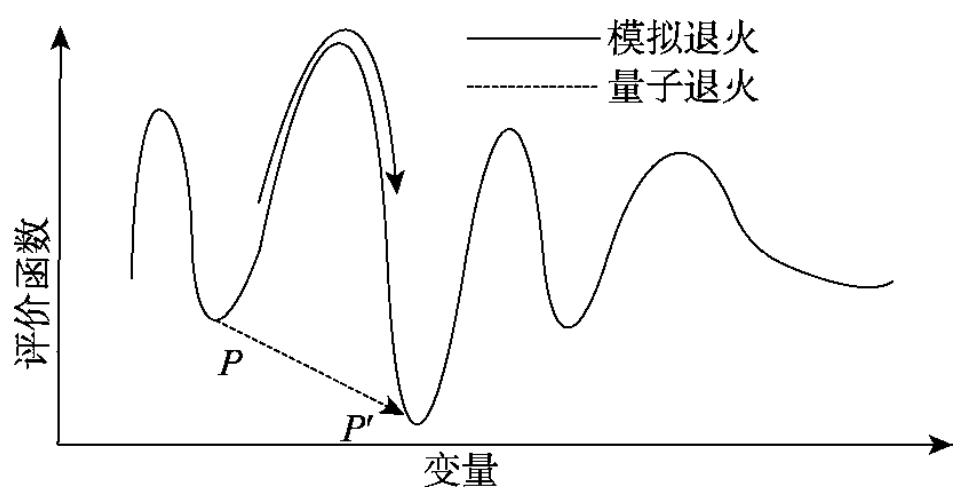

Progress in Quantum Computing Cryptography Attacks

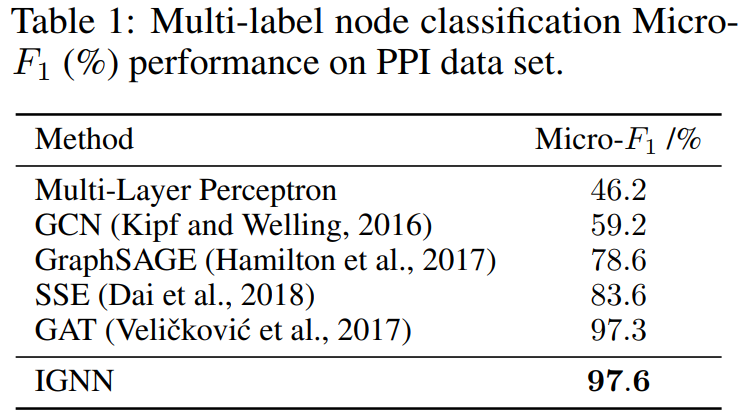

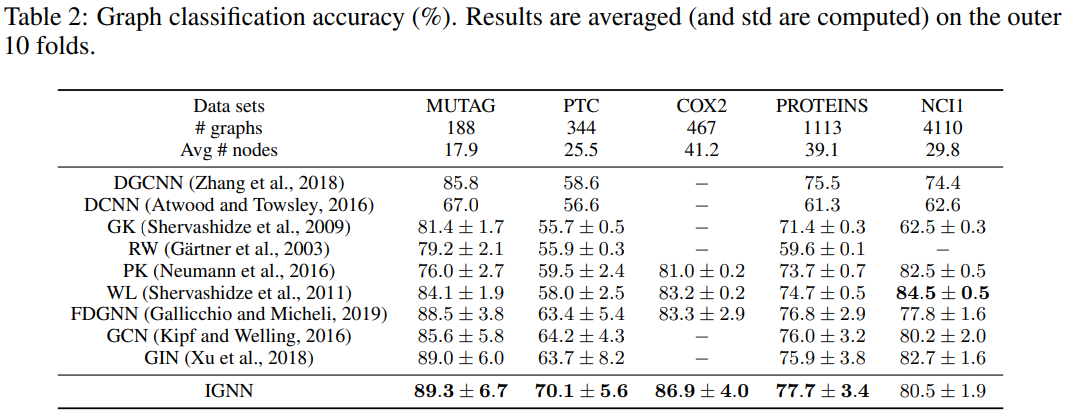

Implicit Graph Neural Networks

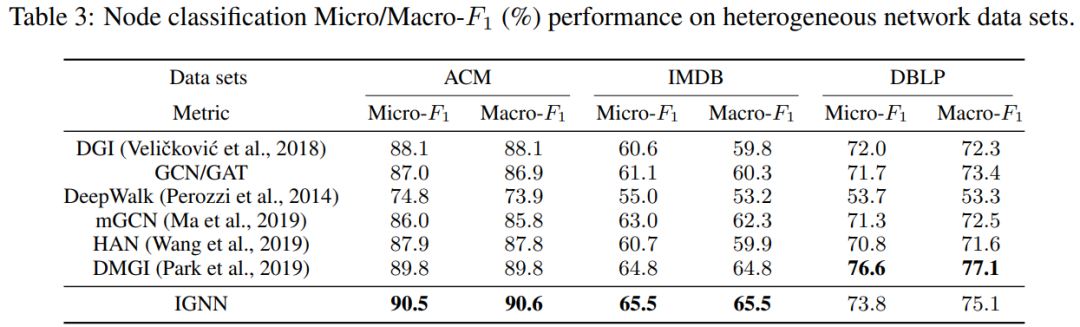

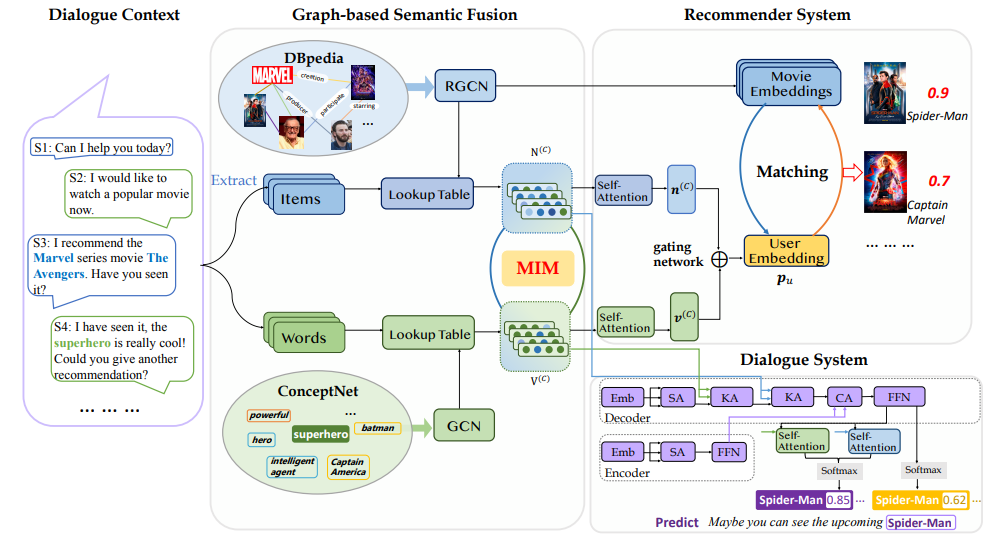

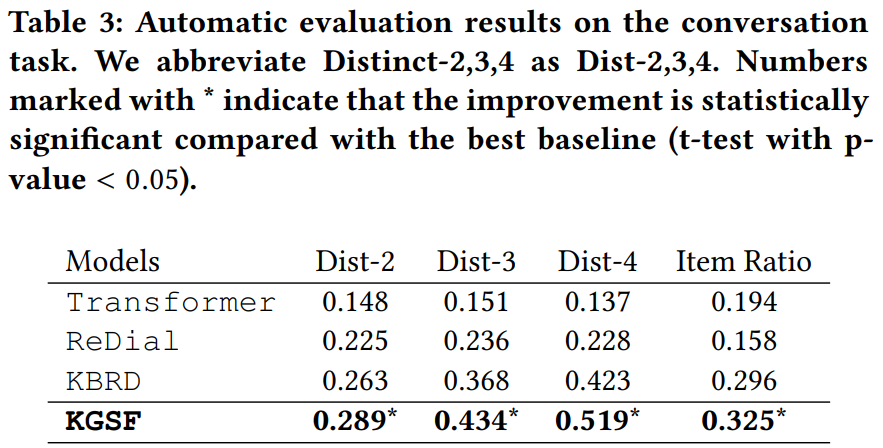

Improving Conversational Recommender Systems via Knowledge Graph based Semantic Fusion

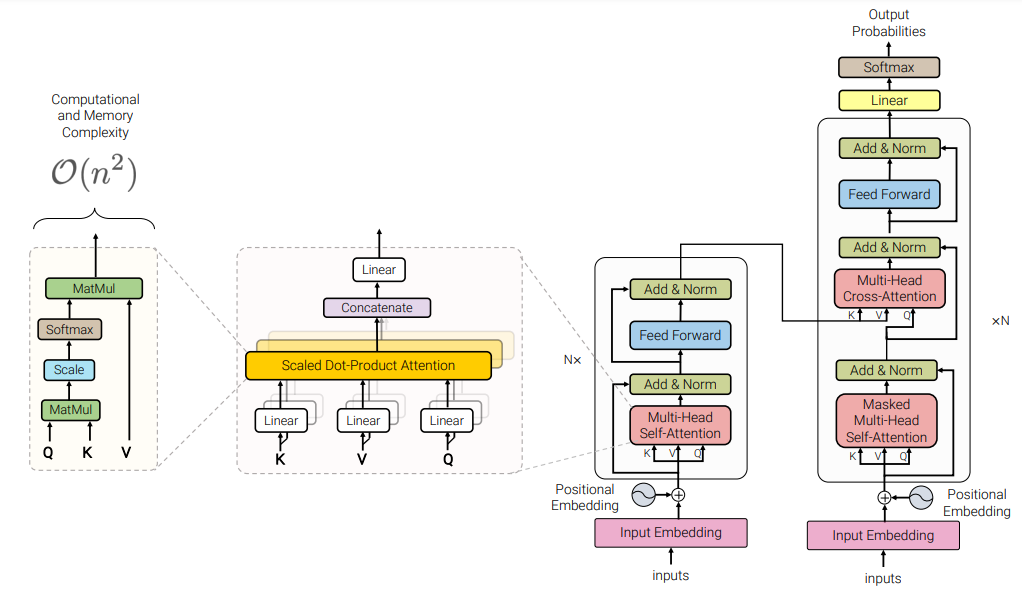

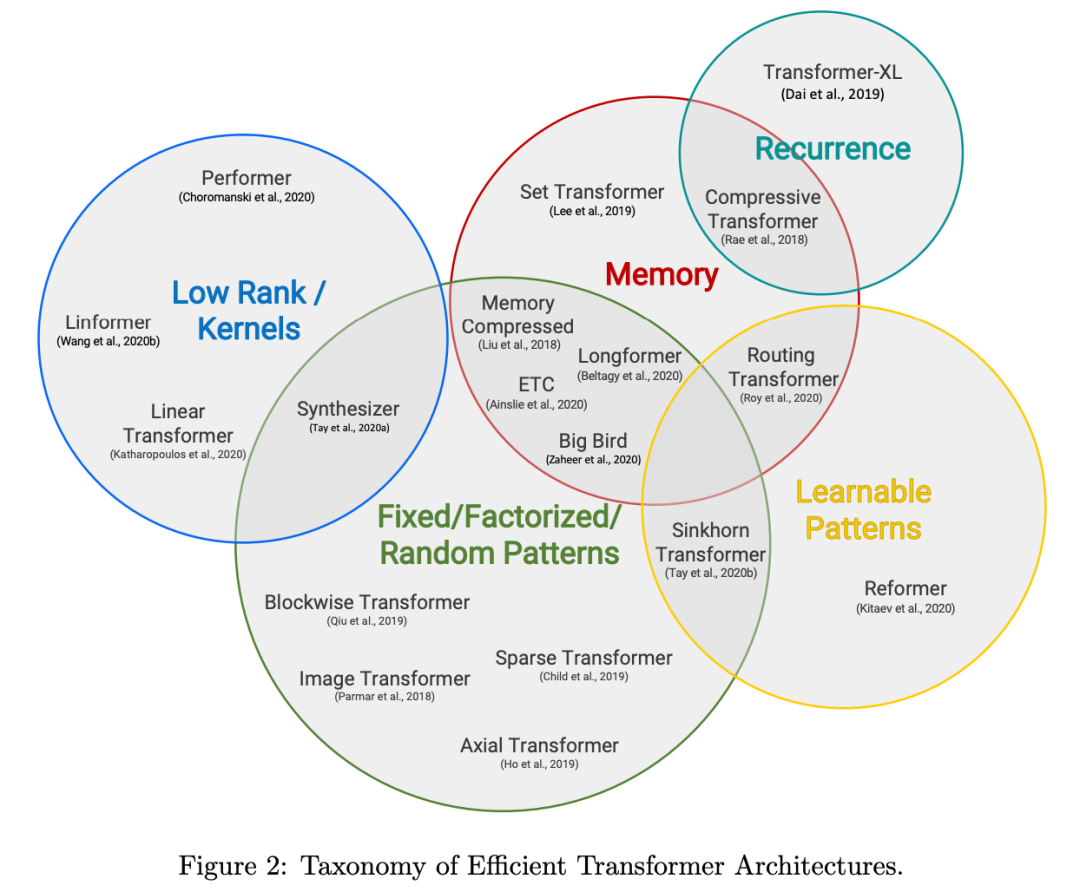

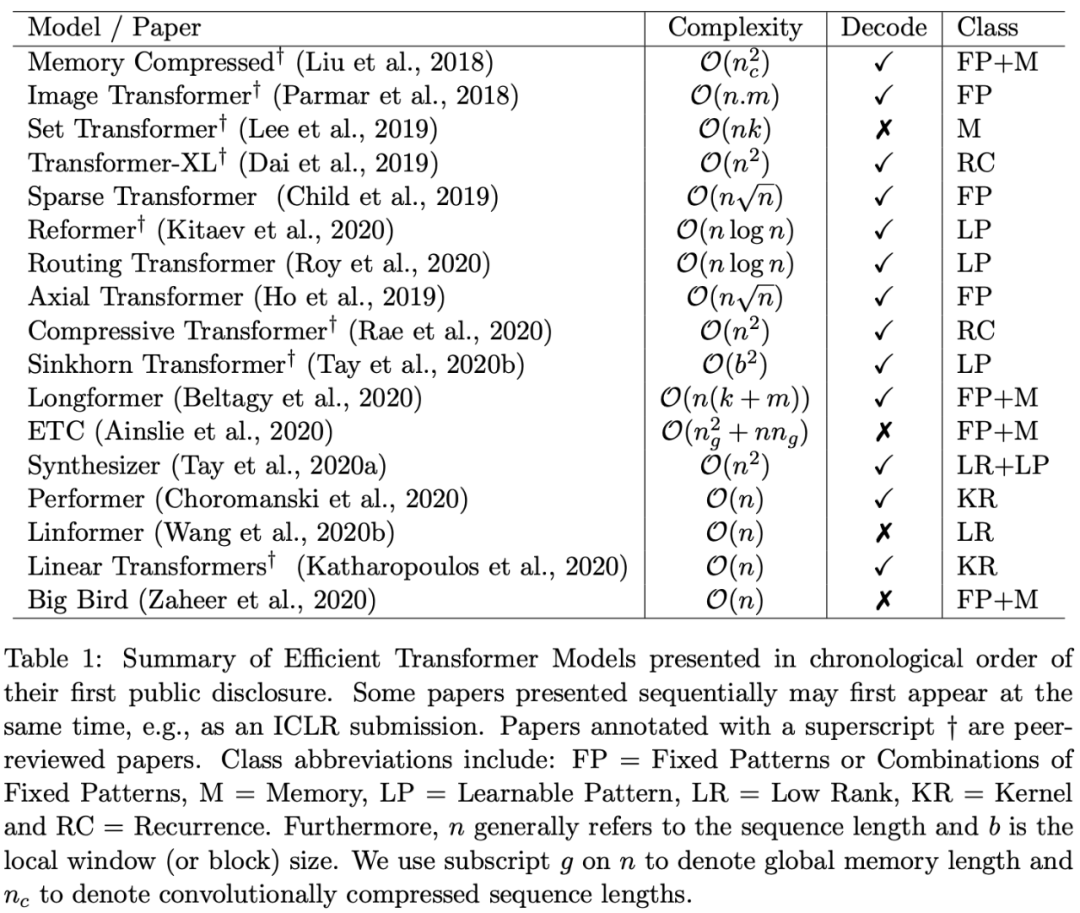

Efficient Transformers: A Survey

ArXiv Weekly Radiostation:NLP、CV、ML 更多精选论文(附音频)

作者:Haohan Wang、Xindi Wu、Zeyi Huang、Eric P. Xing

论文链接:https://arxiv.org/pdf/1905.13545.pdf

作者:Jiang Lu、Pinghua Gong、Jieping Ye、 Jianwei Zhang、Changshui Zhang

论文链接:https://arxiv.org/pdf/2009.02653.pdf

作者:Charles R. Harris、K. Jarrod Millman、Travis E. Oliphant 等

论文链接:https://www.nature.com/articles/s41586-020-2649-2

作者:WANG Chao、YAO Hao-Nan、WANG Bao-Nan、HU Feng、ZHANG Huan-Guo、JI Xiang-Min

论文链接:http://cjc.ict.ac.cn/online/onlinepaper/08150%20%E7%8E%8B%E6%BD%AE-202094103159.pdf

作者:Fangda Gu、Heng Chang、Wenwu Zhu、Somayeh Sojoudi、Laurent El Ghaoui

论文链接:https://arxiv.org/pdf/2009.06211.pdf

作者:Kun Zhou、Wayne Xin Zhao、Shuqing Bian、Yuanhang Zhou、Ji-Rong Wen、Jingsong Yu

论文链接:https://arxiv.org/pdf/2007.04032.pdf

作者:Yi Tay、Mostafa Dehghani 、Dara Bahri、Donald Metzler

论文链接:https://arxiv.org/pdf/2009.06732.pdf