科研成果 | 中心魏少军、尹首一团队获得ESWEEK 2020最佳论文奖

![]() 戳上面的蓝字关注我们哦!

戳上面的蓝字关注我们哦!

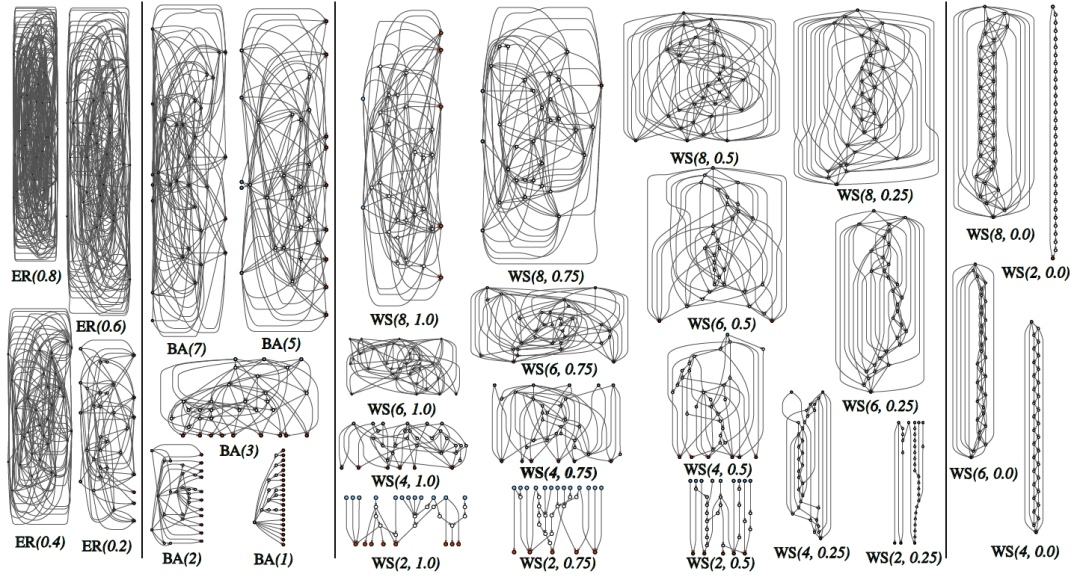

神经网络处理器面临挑战举例:随机连线网络

Xie, Saining, et al. "Exploring Randomly WiredNeural Networks for Image Recognition." arXiv: Computer Vision and Pattern Recognition (2019).

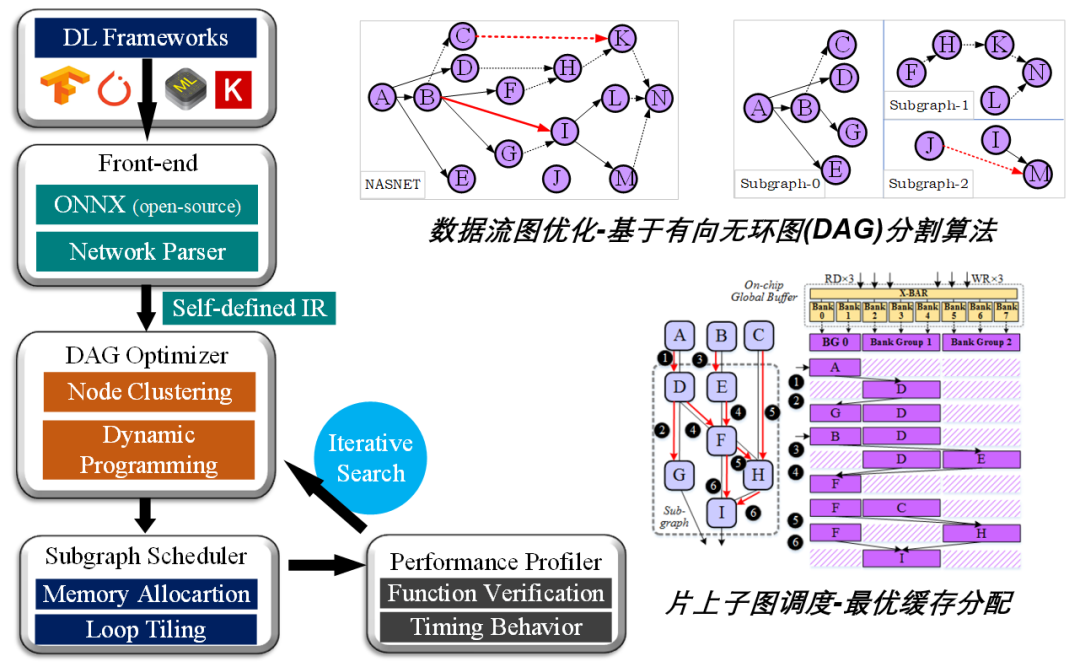

面向这一问题,魏少军、尹首一教授团队从网络结构特征出发,提出了一套新型深度学习编译优化方法,能够将具备任意拓扑形状的大规模神经网络高效地编译映射到神经网络处理器上,其主要技术贡献如下:(1)针对结构复杂的数据流图,提出了基于计算节点深度聚类的编译方法,对图结构进行复杂度降维和搜索路径生成,进而求解得到具备全局最优特性的图调度方案,其在硬件处理器上表现为多级存储系统间的数据传输开销与额外计算开销之间的最佳平衡,亦即推理计算性能达到最优;(2)针对非规则网络结构导致的解空间指数增长,提出了一种基于回溯搜索和参数匹配的启发式资源分配方法,对神经网络基本算子在时空域上的分布进行联合优化,从而实现硬件层面上处理器缓存资源利用率的最大化;(3)针对新型网络结构的循环优化问题,推导得出了最小循环变换粒度,并在编译框架中建立了最优阵列映射机制,使得嵌套循环的运算与计算资源达到最优匹配。整个编译优化过程是多层次迭代式进行的,从而避免了解空间的遗漏。这项工作通过系统性的研究填补了大规模、非规则神经网络编译映射这一技术空白,相比于同类的最佳编译优化方法实现了1.61-2.41倍的推理计算加速,并提供了从软件算法模型到硬件机器码的端到端自动编译优化工具,支持多种主流深度学习开发框架,适用于包括嵌入式系统在内的多种人工智应用部署场景。该研究成果已在北京清微智能公司的AI编译工具链中实现了产品化。

支持任意网络拓扑结构的端到端深度学习编译框架

长按下方二维码,关注官方微信。

未来芯片高精尖中心

微信号:THU-ICFC