持续学习是在保护先前获得的知识的同时,顺序学习新任务或知识的方式。然而,灾难性的遗忘给执行这种学习过程的神经网络带来了巨大的挑战。

受大脑中神经调节过程的启发,学者们提出了一种神经调节元学习算法(ANML)来对抗灾难性遗忘,来看看持续学习与ANML的潜力吧。再先进的AI系统也逃不过它的致命弱点——统计性。算法通常在数据集上训练一次后就结束了它的学习生涯,这使得它们在没有再训练的情况下无法学习新信息,也使得统计性成为了关键局限性。人类的大脑与之相反,人脑不断学习,随着时间的推移获得信息,建立新知识。尽管在弥合学习能力方面已经取得了进展,但解决“持续学习”问题仍然是人工智能领域的一大挑战。https://www.continualai.org/home/这一挑战促使一组人工智能和神经科学研究人员成立了ContinualAI。作为一个非营利性组织和一个开放社区,ContinualAI由持续学习和终身学习爱好者组成。它最近发布的Avalanche工具库就可以让持续学习研究变得更容易、更可重复的。Avalanche历时一年,由40多位贡献者编写而成。ContinualAI还举办会议式展示,赞助研讨会和AI竞赛,并维护教程、代码和指南库。比萨大学联合创始人总裁兼助理教授文森佐•洛莫纳科解释道,ContinualAI是认可人工智能对未来至关重要的最大的组织之一。他通过电子邮件告诉VentureBeat:“甚至在新冠肺炎之前,ContinualAI分布式、开放式合作理念的想法就得到了资助。我们提供了一个全面的平台来制作、讨论和分享人工智能方面的原创研究,而这项服务完全免费。” 机器学习的“阿喀琉斯之踵”

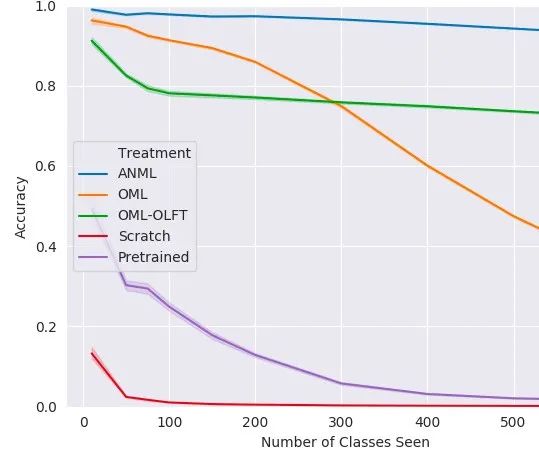

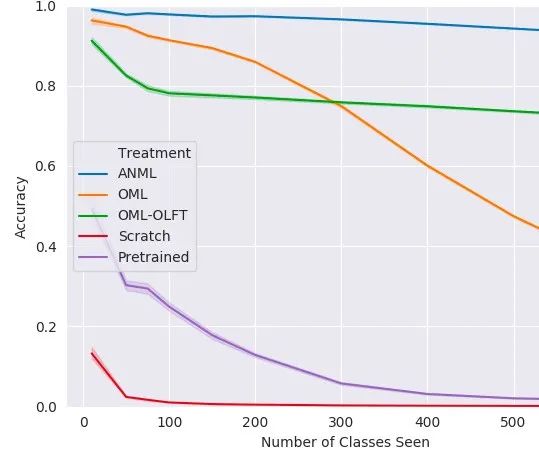

即使是非常精妙复杂的深度学习算法也会突发灾难性学习事故,导致的结果是深度网络无法回忆起它们从训练数据集中学到的东西。因此,网络必须不断被提醒他们已经获得的知识,否则就有可能被最近的记忆“卡住”。OpenAI研究科学家杰夫·克伦在2017年帮助联合创立了优步人工智能实验室(Uber AI Labs),他将灾难性遗忘称为机器学习的“阿喀琉斯之踵”,并相信解决这个问题是实现人工通用智能(AGI)的最快路径。持续的终身学习需要模型在先前知识的基础上学习许多顺序排列的任务,而不会灾难性地忘记它,但是实际上所有这些工作都涉及手动设计的解决方案。相反,上述学者提倡用元学习来作为灾难性遗忘的解决方案,从而使AI能够不断学习。神经调节是在人类大脑中发现的一个过程,其中神经元可以抑制或刺激大脑中的其他神经元,包括刺激它们学习。去年2月,克伦与人合著的论文中详细介绍了神经调节元学习ANML算法。它通过区分顺序学习和以元学习激活门控的功能,从而在深度神经网络中实现环境相关的选择性激活。具体而言,神经调节(NM)神经网络控制着另一个称为预测学习网络(PLN)的神经网络的前向通行。NM网络因此也间接控制了PLN的选择性可塑性(即反向传递)。ANML使持续学习成为可能而不会造成灾难性的大规模忘却,它产生了最先进的持续学习表现,连续学习了多达600个课程(超过9,000个SGD算法更新)。简言之,ANML通过对神经调制网络参数的元学习,获得了最先进的连续学习结果。通过ANML算法,“元学习”替代了手动工程解决方案,成功地学习了600个连续的任务,最小化了灾难性遗忘。 持续学习的推进

脸书也在行动

在怀俄明大学的实验室里,克伦和他的同事还扩展了OML模型,这是玛莎·怀特和库拉姆·贾韦德在2019年NeurIPS大会上引入的一种模型,能够完成多达200项任务而不会触发灾难性的遗忘。

https://arxiv.org/abs/1905.12588但克伦表示,ANML与OML不同,因为他的团队意识到调节神经元的激活也是必要的。克伦在加入OpenAI之前写的另一篇论文中指出,通过改进元学习算法架构、算法本身以及自动生成训练环境,可以实现更快的AGI路径。除此之外,Alphabet旗下的DeepMind发表的研究表明,灾难性遗忘对神经网络来说并非不可克服的挑战。脸书正在推进一系列持续学习的技术和基准,包括一种它声称能有效防止特定任务技能遗忘的模型。尽管在过去几年里,对这一问题的研究有所复苏,但灾难性遗忘在很大程度上仍未得到解决,ContinualAI的联合创始人兼加州大学欧文分校的神经科学研究助理库伯谈道。“持续学习的潜力胜过了灾难性遗忘,并开始触及AI中认知学习等更有趣的问题。迁移学习就是一个例子,对于人类或动物来说,过往知识可以应用于一个新的环境或支持其他领域的学习…更诱人的是,持续学习试图推动人工智能走向更广泛、更普遍的大道。”库伯指出,即使持续学习不会产生AGI描绘的科幻小说场景,但它在一系列领域都有直接的优势。为了获得更好的性能,尖端模型在越来越大的数据集上进行训练,相应的,这种训练的代价是:训练时间往往需要几周,电力对环境的影响也不容忽视。库伯解释道:“假设你经营着一家人工智能公司,建立了一个自然语言模型,花费了数百万美元在45 TB字节的数据上训练了数周。如果你想教这个模型一些新的东西,除非你在模型中添加持续学习的内容,否则你很可能不得不从头开始,或者冒着覆盖它已经学过的东西的风险。此外,在某种程度上,存储数据的成本将非常高,甚至计算一下沉默成本后,这个方案是不可能的。除此之外,在很多情况下再培训甚至也不算一个选择。”尽管持续学习AI系统的蓝图仍然并不明朗,但ContinualAI的目标是连接研究人员和对该领域感兴趣的相关者,并为项目和研究提供支持和平台,自成立以来的三年中,它的成员迅速增长超过了1000人。库伯说:”就我个人而言,虽然人们对不断学习人工智能研究重新产生了兴趣,但人类和动物如何完成这些神经科学的壮举仍未知。”“我希望看到更多人工智能研究人员、认知科学家和神经科学家合作交流。像ContinualAI这样的组织允许思想分享,而不受学术、行业壁垒、竖井领域或地理位置的限制是让人激动的。”除了传播持续学习的信息,ContinualAI也有潜力成为更具包容性和合作性的人工智能研究的参考点。“名校和私人实验室仍然以闭门实验为主,比起有选择性的精英,我们更相信包容性和多样性,正如比起保护性的知识产权,我们更支持开源和透明度。我们确保每个人都能获得所需要的学习资源,发挥潜力。”From: venturebeat; 编译:Shelly

Illustrastion by Clip from Icons8

- The End -

将门是一家以专注于发掘、加速及投资技术驱动型创业公司的新型创投机构,旗下涵盖将门创新服务、将门技术社群以及将门创投基金。将门成立于2015年底,创始团队由微软创投在中国的创始团队原班人马构建而成,曾为微软优选和深度孵化了126家创新的技术型创业公司。如果您是技术领域的初创企业,不仅想获得投资,还希望获得一系列持续性、有价值的投后服务,欢迎发送或者推荐项目给我“门”: