字节跳动荣获ACL 2021最佳论文!曾被ICLR拒稿,网友:同行评审就像抽彩票?

作者 | 陈彩娴、青暮

昨天,ACL 2021 公布了最佳论文、最佳主题论文和杰出论文等3个奖项,共8篇论文入选,其中,字节跳动AI Lab获得今年的最佳论文,堪称华人之光!

这篇论文的题目为“Vocabulary Learning via Optimal Transport for Neural Machine Translation”,是字节跳动与威斯康星-麦迪逊大学、南京大学联合研究的成果,论文一作为北京大学校友许晶晶。

细心的网友发现,这篇论文曾是 ICLR 2021 的拒稿,当时在 ICLR 只得到4、4、3、3的评分(满分为10分),基本难逃被拒的命运。后来,字节团队放弃 rebuttal,从 ICLR 撤稿,转投 ACL 2021,没想到竟然被高分评为“ACL 2021 最佳论文”!

知乎讨论:

https://www.zhihu.com/question/470224094?s_r=0&utm_medium=social&utm_source=wechat_session

有网友的感想是:「无论什么工作peer review就是摸彩票」。

也有网友附议会议评审的随机性,比如当年AI2的Elmo工作也是从ICLR撤稿后、在NAACL上获得最佳论文:

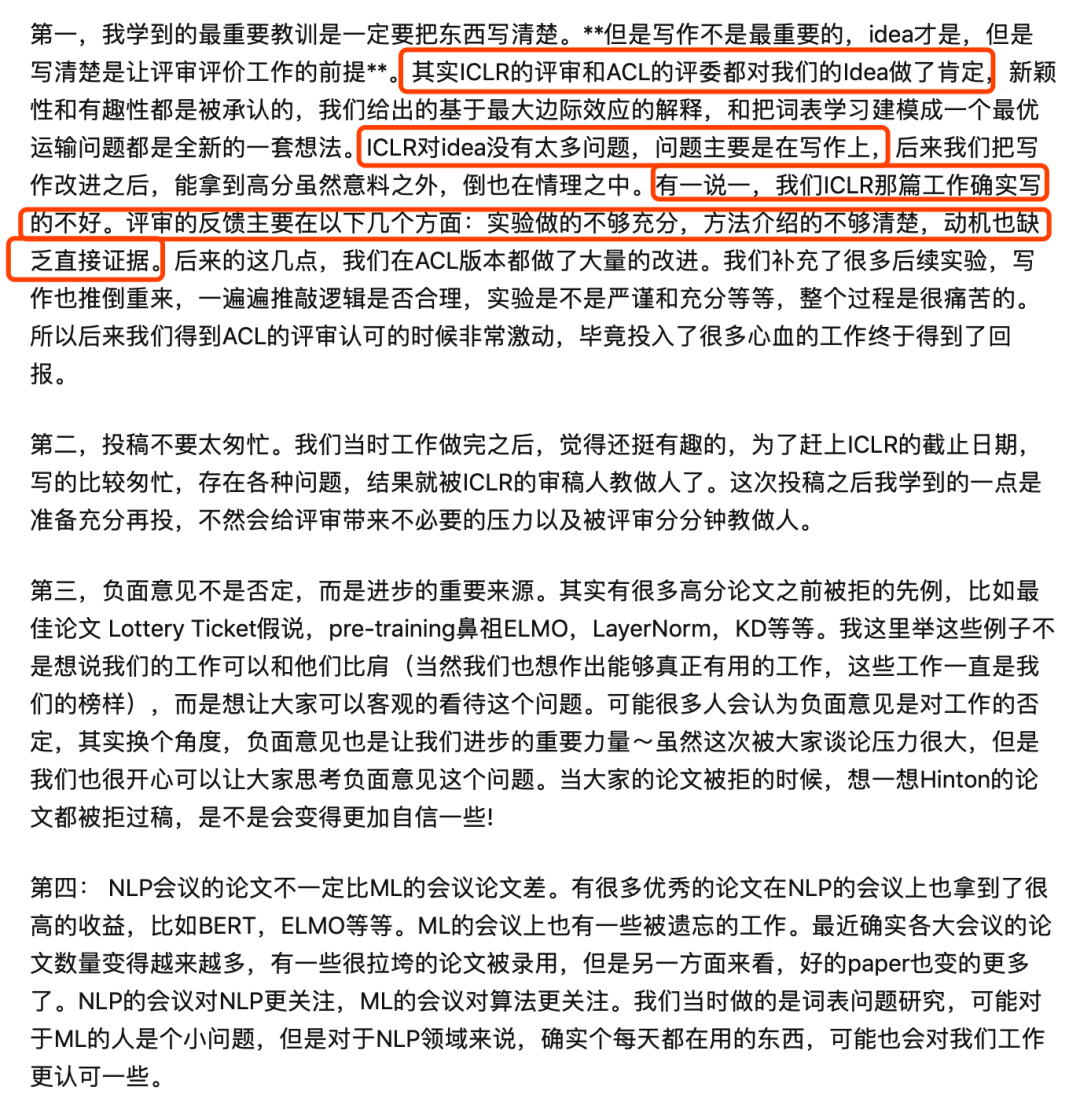

不过,根据该论文的合作者@WAZWY介绍,从ICLR转投到ACL的过程是这样的:「我们在投ICLR的时候,花了太多时间在实验上,在writing上花的时间很不够,整个paper显地平铺直叙,Intuition没有说出来,且有部分重要的实验没有补充。结果大家也看到了,我觉得这是一个重要的lesson,也欢迎大家对比我们两个版本的论文。」

一作@许晶晶也现身解释,这篇工作的idea在ICLR与ACL上都获得了评审的肯定,但相比ACL的投稿来说,ICLR的投稿在写作上比较粗糙,论证不够严谨,所以 ACL 投稿版本修改后再次投稿,中了也不奇怪!

以下是ACL 2021 获奖工作的介绍:

最佳论文

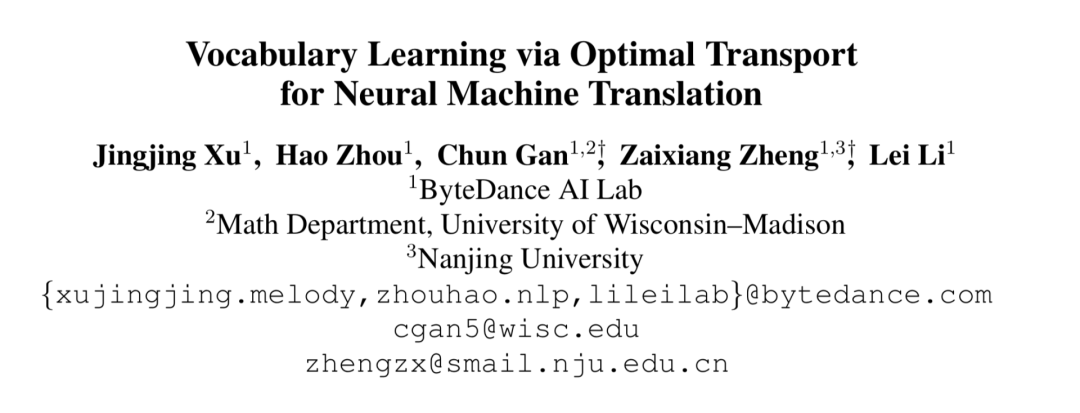

题目:Vocabulary Learning via Optimal Transport for Neural Machine Translation

作者:许晶晶,Hao Zhou,Chun Gan,Zaixiang Zheng,李磊

单位:字节跳动人工智能实验室;威斯康星-麦迪逊大学;南京大学

论文地址:https://arxiv.org/pdf/2012.15671.pdf

代码地址:https://github.com/Jingjing-NLP/VOLT

标记词汇的选择会影响机器翻译的性能。这篇论文旨在弄清楚什么是好的词汇,以及是否可以在没有试验训练的情况下找到最佳词汇。为了回答这些问题,作者首先从信息论的角度理解词汇的作用,然后在信息论的启发下,将词汇化的探索(即“找到大小适当的最佳标记词汇”)看作一个最优传输 (OT) 问题。他们提出了一种无需进行试验训练的解决方案,叫“VOLT”。

实验结果表明,VOLT 在多个场景下的性能都比目前广泛使用的词汇库出色,包括WMT-14 English-German与TED的52个翻译方向。比如,在英德翻译上,VOLT所使用的词汇量大小只有30%,并获得 0.5 BLEU。此外,与 BPE-search 相比,VOLT 的英德翻译搜索时间从 384 个 GPU 小时减少到了 30 个 GPU 小时。

最佳主题论文

题目:Including Signed Languages in Natural Language Processing

作者:Kayo Yin,Amit Moryossef,Julie Hochgesang,Yoav Goldberg,Malihe Alikhani

单位:卡内基梅隆大学LTI;以色列巴伊兰大学;加拉德特大学;艾伦人工智能研究所;匹兹堡大学

手语是许多聋哑人和听力障碍人士的主要交流方式。作者认为,手语展现了自然语言的所有基本语言特征,所以他们相信自然语言处理 (NLP) 的工具和理论对手语的建模至关重要。然而,现有的手语处理 (SLP) 研究很少尝试去探索和使用手语的语言组织。

这篇论文呼吁 NLP 社区将手语看作一个具有高度社会影响和科学影响的研究领域。文章首先讨论了在建模过程中要考虑的手语的语言特性,然后回顾了当前 SLP 模型的局限性,并提出将 NLP 扩展到手语的可能挑战。

最后,作者敦促了以下发展:1)采用有效的标记方法;2)开发语言知识模型;3)收集现实世界中的手语数据;4)将本地手语社区纳入主要的研究方向。

杰出论文

1、题目:All That’s ‘Human’ Is Not Gold: Evaluating Human Evaluation of Generated Text

作者:Elizabeh Clark,Tal August, Sofia Serrano,Nikita Haduong,Suchin Gururangan,Noah A. Smith

单位:华盛顿大学;艾伦人工智能研究所

人工评估通常被认为是评价自然语言生成表现的黄金标准,但随着模型流畅度的提高,人类评估者检测和判断机器生成的文本的能力如何呢?针对这个问题,作者开展了一项研究来评估普通人类(非专家)区分人类与机器(GPT2 和 GPT3)所创作的故事、新闻文章和食谱文本上的能力。

他们发现,在没有训练的情况下,评估者会随机区分 GPT3 和人工编写的文本。他们又用三种方法快速训练评估者的辨识能力,使他们能够更好地识别 GPT3 创作的文本(比如细节说明、带注释的示例和配对示例),并发现:虽然评估者的准确率提高了 55%,但在区分人类与机器编写的故事、新闻文章与食谱时仍然没有明显的提高。

鉴于跨文本域的结果不一致,以及评估者通常会给出相互矛盾的判断,他们研究了未经训练的人工评估在 NLG 评估中的作用,并向 NLG 研究人员提出了改进对最先进技术生成文本进行人工评估的模型的建议。

2、题目:Intrinsic Dimensionality Explains the Effectiveness of Language Model Fine-Tuning

作者:Armen Aghajanyan,Sonal Gupta,Luke Zettlemoyer

单位:Facebook

论文地址:https://arxiv.org/pdf/2012.13255.pdf

尽管预训练语言模型可以通过微调,使其在十分广泛的语言理解任务中获得最先进的结果,但这个过程的具体步骤并没有得到很好的理解,尤其是在少数据的情况下。为什么我们可以使用相对普通的梯度下降算法(如没有强正则化)在只有数百或数千个标记示例的数据集上调整具有数亿个参数的模型?

在这篇论文中,作者提出,通过本征维数(intrinsic dimension)分析微调,我们可以获得解释这个现象的经验和理论直觉。实验表明,常见的预训练模型具有非常低的本征维数;也就是说,存在一个低维重参数化,它对微调与完整参数空间一样有效。例如,仅优化随机投射回整个空间的 200 个可训练参数,我们可以调整 RoBERTa 模型,以在 MRPC 上实现 90% 的全参数性能水平。

此外,实验表明,预训练对本征维数进行了隐式最小化,而且,令人惊讶的是,在固定数量的预训练更新后,较大的模型往往具有较低的本征维数,这至少部分解释了它们的高效性。最后,作者将本征维数与低维任务表示和基于压缩的泛化边界联系起来,提供了基于内在维度的、独立于完整参数计数的泛化边界。

3、题目:Mind Your Outliers! Investigating the Negative Impact of Outliers on Active Learning for Visual Question Answering

作者:Siddharth Karamcheti,Ranjay Krishna,李飞飞,Christopher Manning

(论文详情检索无效)

4、题目:Neural Machine Translation with Monolingual Translation Memory

作者:蔡登,Yan Wang,Huayang Li,Wai Lam,Lemao Liu

单位:香港中文大学;腾讯人工智能实验室

先前的工作已经证明翻译记忆 (TM) 可以提高神经机器翻译 (NMT) 的性能。与使用双语语料库作为 TM 并采用源端相似性搜索进行记忆检索的现有工作相比,作者提出了一种新框架,该框架使用单语记忆并以跨语言方式执行可学习的记忆检索。

他们的框架具有独特的优势。首先,跨语言记忆检索器允许大量的单语数据作为 TM。其次,记忆检索器和 NMT 模型可以联合优化以达到最终的翻译目标。实验表明,所提出的方法获得了实质性的改进。值得注意的是,它甚至优于使用双语 TM 的强大的 TM 增强 NMT 基线。由于能够利用单语数据,他们的模型还证明了在低资源和领域适应场景中的有效性。

5、题目:Scientific Credibility of Machine Translation Research: A Meta-Evaluation of 769 Papers

作者:Benjamin Marie,Atsushi Fujita,Raphael Rubino

单位:日本情报通信研究机构(NICT)

论文地址:https://arxiv.org/pdf/2106.15195.pdf

本文进行了机器翻译 (MT) 的首次大规模元评估。作者对 2010 年至 2020 年发表的 769 篇研究论文中进行的 MT 评估进行了标注。研究表明,自动 MT 评估的实践在过去十年中发生了巨大变化,并遵循某种趋势。越来越多的 MT 评估完全依赖于 BLEU 分数之间的差异来得出结论,而不进行任何类型的统计显著性测试或人工评估,同时至少提出了 108 个声称比 BLEU 更好的指标。

近期论文中的 MT 评估倾向于复制和比较之前工作中的自动度量分数,以声称一种方法或算法的优越性,但并未确认是否使用了完全相同的训练、验证和测试数据,也未确认度量分数是否具有可比性。此外,用于报告标准化度量分数的工具仍远未被 MT 社区广泛采用。在展示了这些陷阱的积累如何导致可疑的评估之后,作者提出了一个指导方针,以鼓励更好的自动 MT 评估以及一个简单的元评估.

6、题目:UnNatural Language Inference

作者:Koustuv Sinha,Prasanna Parthasarathi,Joelle Pineau,Adina Williams

单位:麦吉尔大学;Mila实验室;FAIR

论文地址:https://arxiv.org/pdf/2101.00010.pdf

对最先进的大规模预训练基于 Transformer 的自然语言理解 (NLU) 模型内部工作原理的调查表明,它们似乎至少在某种程度上了解人类的语法。作者在本文中提出了稍微不同的观点:他们发现最先进的自然语言推理 (NLI) 模型为置换示例分配的标签,与为原始示例分配的标签是相同的,即它们在很大程度上对随机词序排列保持不变。这种行为与人类的行为明显不同,并且明显不符合语法。

为了衡量这个问题的严重性,作者提出了一套指标,并研究了到底是特定排列的哪些属性导致了模型是词序不变的。例如,在 MNLI 数据集中,他们发现几乎所有 (98.7%) 示例都包含至少一种引起黄金标签的排列。模型有时甚至能够为它们最初未能正确预测的排列分配黄金标签。

他们对这种现象进行了全面的实证评估,并进一步表明这个问题存在于多种语言(英语和普通话)的基于 Transformer 和 pre-Transformer RNN / ConvNet 的编码器。

参考链接:

https://2021.aclweb.org/program/accept/

https://www.zhihu.com/question/470224094?s_r=0&utm_medium=social&utm_source=wechat_session