UCSD+UCB发布挑战赛 | 3D视觉的下一个前沿:让机器人学会通用物体操作

对物体进行观察、理解和操作是我们人类每天重复无数次的事情,但是对于机器人来说却是一件十分困难的任务。近年来,三维相机的发展与普及使得机器人能够随处“观察”环境并获取场景的几何信息。三维深度学习的研究和应用,让机器人可以更好地“理解”三维数据。机器人学的发展使得我们具备准确“操作”机械臂的能力。三种能力的融合将为智能机器人技术的研究带来巨大的突破,而物理仿真技术的日益成熟令我们可以在虚拟环境中安全、低成本地进行强化训练,促进三种能力的融合。在此背景下,UC San Diego Hao Su's Lab和UC Berkeley Sergey Levine's Lab推出了本次智能机器人物体操作挑战赛,希望能够综合以上进展,探索人工智能技术的新边界。

ManiSkill开源挑战赛概述

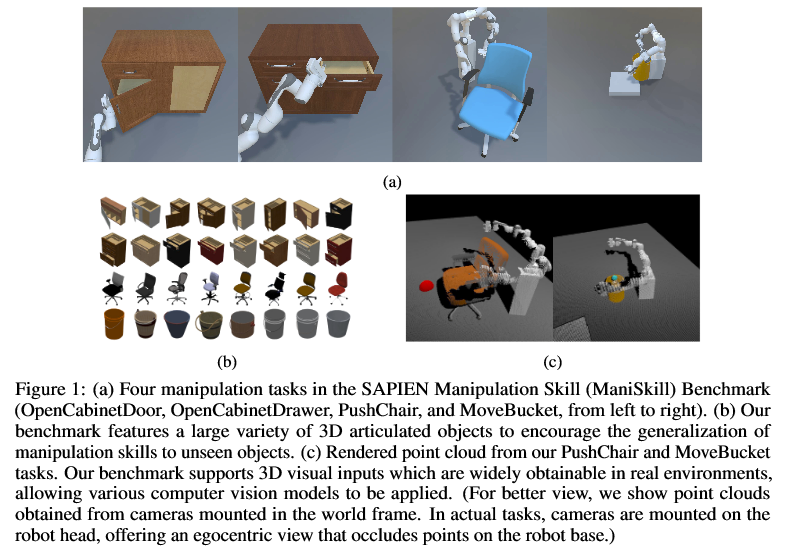

智能机器人物体操作技术的核心难点在于如何对未曾见过的场景进行理解和处理。人类能够根据所见到的全新场景对既往经验进行调整,因此我们希望机器人同样能够将训练时所学到的物体操作技能应用于包含新物体的场景中。这种迁移能力被称为机器人的泛化性能。泛化性能的训练需要一个更为复杂的环境,但是目前机器人学习领域使用的训练环境里普遍缺少大量的、丰富多样的三维物体,尤其缺少我们生活中非常广泛的复杂多关节物体(articulated object)(例如柜子和转椅)。因此,我们研发了SAPIEN,一个包含大量多关节物体的可交互仿真环境。在此基础上,我们推出了SAPIEN ManiSkill Benchmark(ManiSkill 基准测试),以及SAPIEN开源物体操作技能挑战赛(SAPIEN Open-Source Manipulation Skill Challenge),简称 ManiSkill开源挑战赛。

在ManiSkill开源挑战赛中,我们利用新版SAPIEN模拟器和丰富多样的可操作物体构建了四个不同的物体操作任务(打开橱柜门、打开抽屉、推办公椅、移动水桶)。为了方便大家更快上手,我们开源了通用的基线算法(baseline algorithms)和训练好的模型,例如通过监督学习模仿演示数据以及强化学习。除此以外,我们还为这四个任务提供了可用于演示学习的大量高质量的演示数据(demonstration data)。

此次挑战赛与以往在真实机器人上进行评判的挑战赛的最大不同之处在于我们通过使用高质量的物理仿真环境实现了公平、准确、并可复现地对每位参赛者的算法进行测试与排名。同时,参赛者无需花费精力维护一台真实机器人,仅需一台电脑就可以对其算法的表现进行测试与调试。这大大降低了机器人学习研究的门槛。此外,为了推动智能机器人社区在通用物体操作技能学习方向研究的整体进步,本次挑战赛要求所有获奖团队必须公开其训练代码、评估代码和训练好的模型。

竞赛细节介绍

注册

重要日期

07/29/2021:注册开放

08/09/2021:提交开始

08/20/2021:评估开始

12/10/2021:挑战结束

12/17/2021:代码提交截止

挑战赛道

无交互:要求解决方案仅使用此挑战中提供的演示数据,不允许与环境交互(即额外的数据收集、使用在线强化学习训练等)。这个赛道适合计算机视觉研究者探索不同的三维神经网络结构来直接模仿演示数据。

无外部标注:允许参赛者在第一个赛道的结果上进行在线模型微调(比如使用在线强化学习方法),但是不得包含新的标注数据(例如来自其他数据集的新物体)。这个赛道更适合强化学习等领域的研究者。

无限制:允许参赛者做任何他们想做的事情,包括标注新数据、创建新环境等。参赛者也被允许硬编码手动设计的规则,以便使用传统机器人技术来解决这些问题。

开源和可复现性规定

我们确认您的注册后,您可以使用ManiSkill开源挑战赛主页右上角的登录按钮并注册一个SULab Auth帐户(我们的内部认证系统)让您登录。然后您可以在提交系统上线后提交模型。

相关链接

https://sapien.ucsd.edu/challenges/maniskill2021/

· 注册参赛表格:https://docs.google.com/forms/d/e/1FAIpQLSeMzLHaTGTPCTYeIbo3TgWkjEtwJ21DEC-Bnr0JpR873pzeag/viewform?usp=sf_link

https://github.com/haosulab/ManiSkill-Learn

https://arxiv.org/abs/2107.14483

· 关注@HaoSuLabUCSD:获取挑战赛相关的最新信息。

https://twitter.com/HaoSuLabUCSD?s=20

“AI技术流”原创投稿计划

TechBeat是由将门创投建立的AI学习社区(www.techbeat.net)。社区上线330+期talk视频,900+篇技术干货文章,方向覆盖CV/NLP/ML/Robotis等;每月定期举办顶会及其他线上交流活动,不定期举办技术人线下聚会交流活动。我们正在努力成为AI人才喜爱的高质量、知识型交流平台,希望为AI人才打造更专业的服务和体验,加速并陪伴其成长。

投稿内容

// 最新技术解读/系统性知识分享 //

// 前沿资讯解说/心得经历讲述 //

投稿须知

稿件需要为原创文章,并标明作者信息。

我们会选择部分在深度技术解析及科研心得方向,对用户启发更大的文章,做原创性内容奖励。

投稿方式

发送邮件到

chenhongyuan@thejiangmen.com

或添加工作人员微信(chemn493)投稿,沟通投稿详情;还可以关注“将门创投”公众号,后台回复“投稿”二字,获得投稿说明。

>>> 投稿请添加工作人员微信!

本周上新!

扫码观看!

关于我“门”