佐思汽车研究佐思汽研致力于汽车、TMT、新能源(特别是新能源汽车、智能汽车、车联网)领域的行业研究、专项调研、战略规划、投资咨询、数据分析以及推广传播。

650篇原创内容

公众号

图片来源:互联网

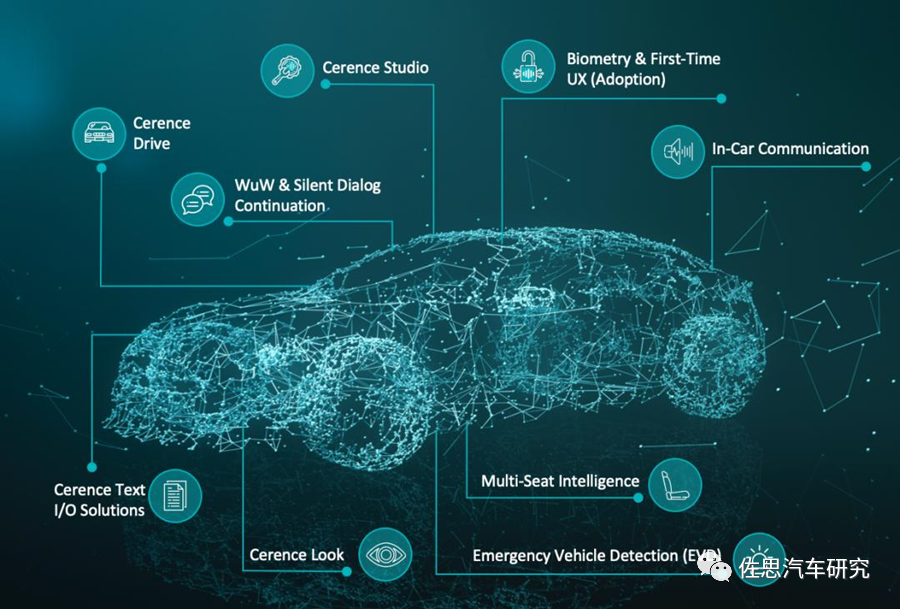

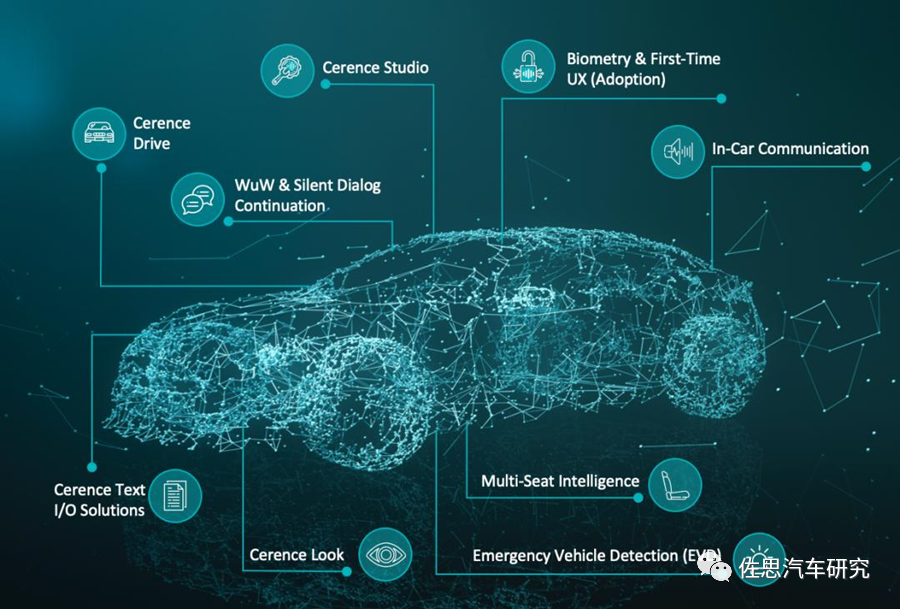

无人驾驶时代还将加入紧急车辆如救护车、消防车声音识别,多座位智能识别。未来还将识别车主的情绪,如喜悦、愤怒等,并根据情绪调整灯光或音乐音量,语音交互是最自然的交互。此外还有声纹识别。中美两国是自然语音识别与语音助手的最主要市场,根据车载语音识别专业调查公司VOICEBOT的2021年8月的调查报告,美国的车载语音助手使用高达1.27亿人次,月度活跃使用为8380万人次。德国是2700万人次,英国是1900万人次。

图片来源:互联网

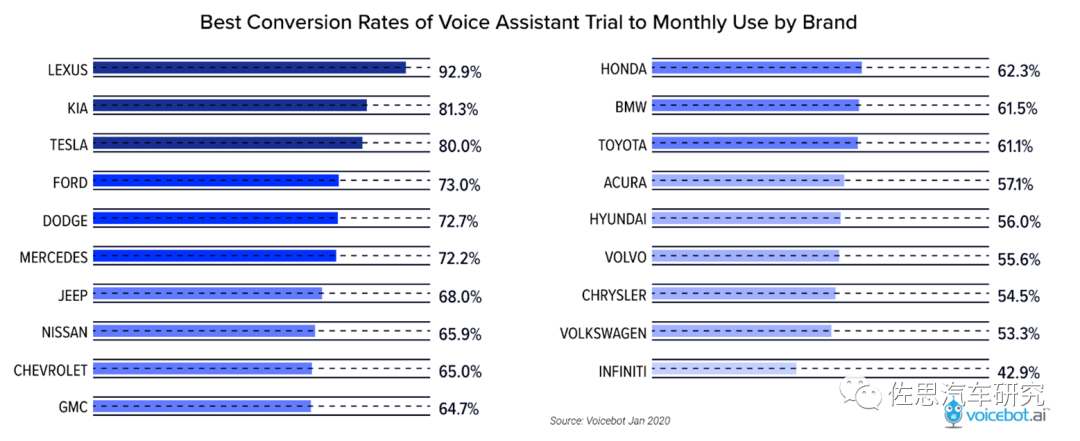

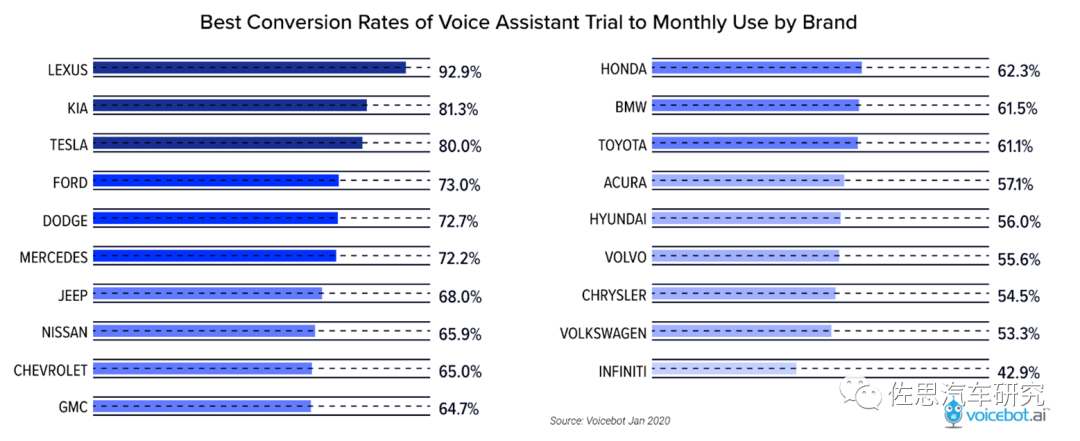

上图是美国市场汽车品牌月度语音助手使用率,从中可以看出并非只有豪华车才有高的使用率,起亚、福特、Dodge都是平价车型为主,强调操控的豪华品牌如宝马和讴歌,使用率很低。实际上就是语音助手做得好,用户立刻就会养成使用习惯,也就是说即使廉价车型也很有必要装语音助手。

图片来源:互联网

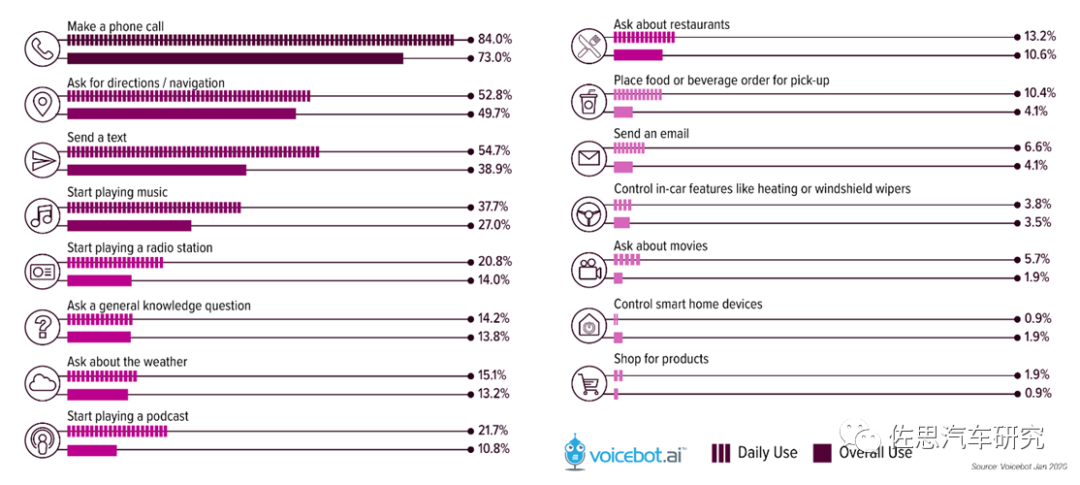

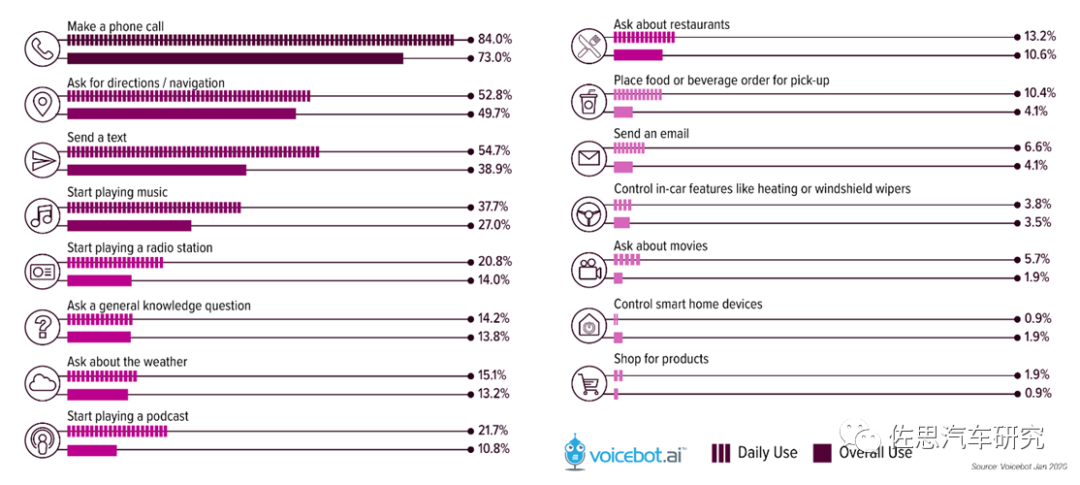

这是美国市场车载语音助手的主要应用场景,其中打电话、问路、发送短信、播放音乐、找电台、询问天气、播客是高频应用。在中国,新兴造车厂家无一例外都对语音助手非常重视,这是科技感的主要来源,典型如蔚来的NOMI。

图片来源:互联网

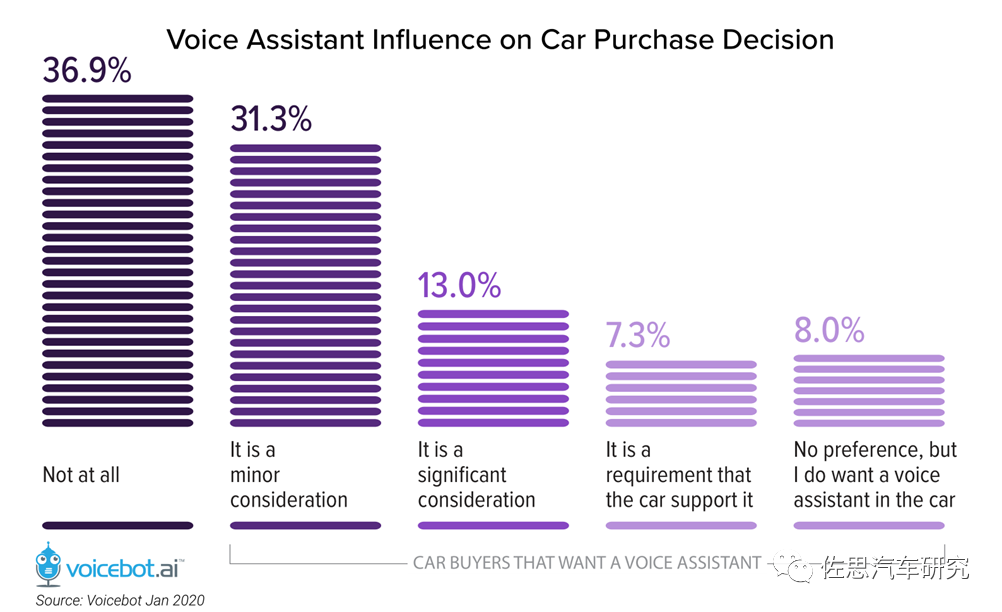

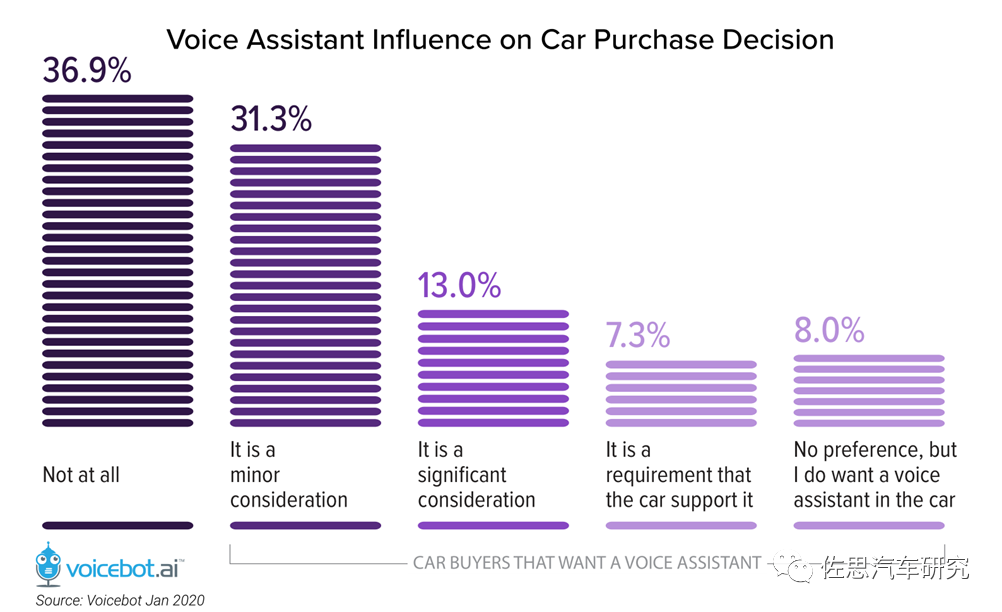

美国消费者购车时对语音助手的需求度如图所示,某些消费者还是语音助手的铁杆粉丝。

图片来源:互联网

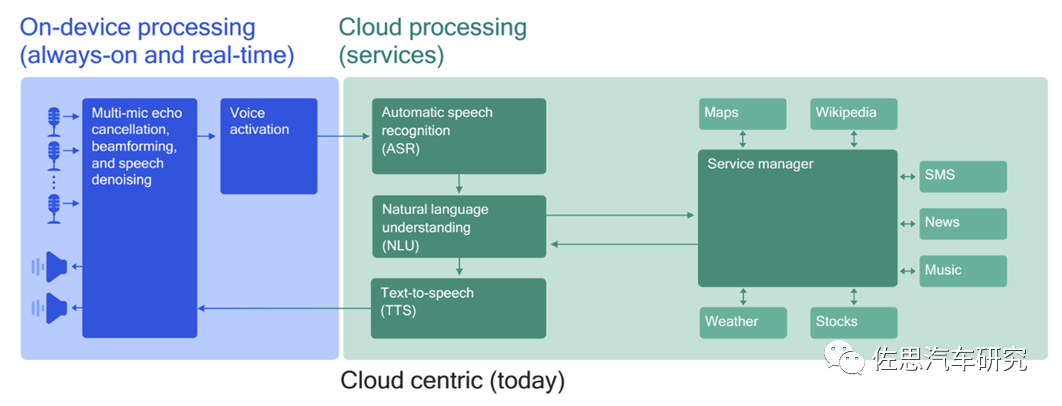

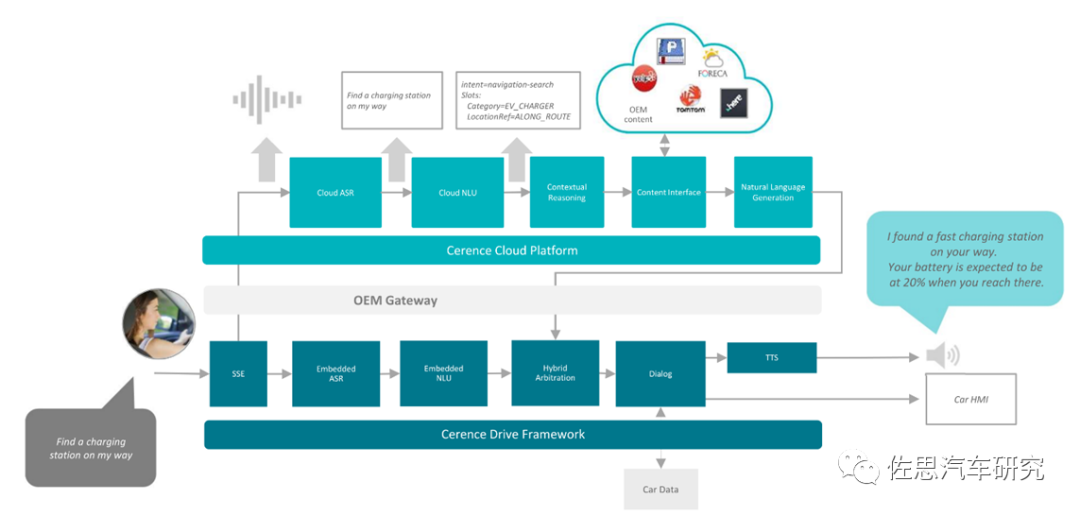

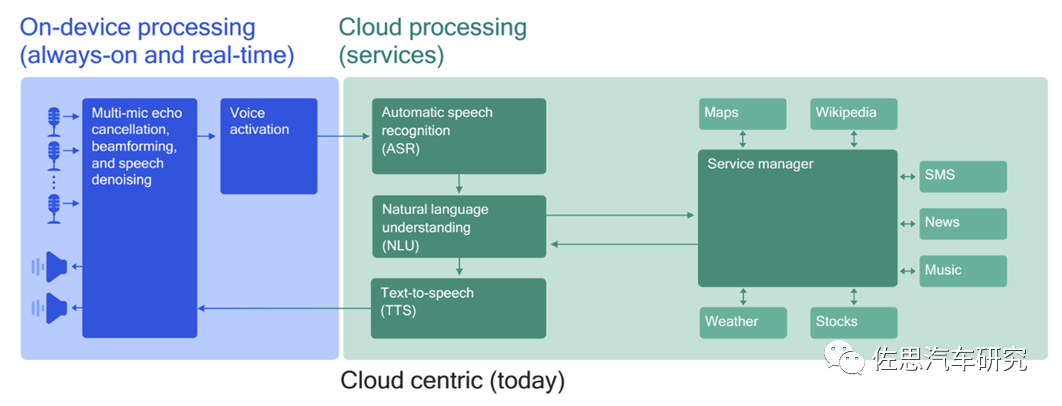

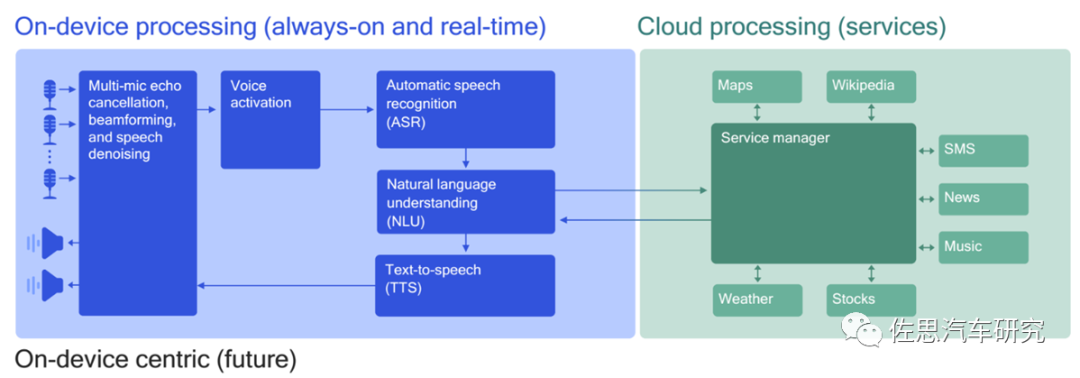

由于车机硬件性能远低于手机和PC,所以车载语音助手大部分都是采用在线方式,也有少部分豪华车采用离线与在线相结合的方式,如奔驰的MBUX。由麦克风阵列拾取人声,对人声进行ADC模拟数字转换,然后过滤掉噪音和背景声以及远离拾音区的信号,再将过滤后的信号上传至云端,云端服务器主要进行ASR和NLU,识别后返回原通道再转换为命令或规划给汽车MCU。

图片来源:互联网

离线与在线结合的方式,将ASR和NLU也加入车机,联网情况下用云端服务器,不联网也可以本土离线使用。离线使用也可最大限度保留隐私和保证数据安全,其他优点还有延迟时间短,表现稳定。奔驰的第二代MBUX主SoC为英伟达Xavier NX,拥有高达21TOPS的AI算力,语音助手功能更强,支持27种自然理解(NLU)的语言,除了可以进行更多对话外,即使没有激活关键字也可以执行某些操作;同时,语音助手内含完整的用户手册,你可以咨询车内是否具备某种功能或某个配置,方向盘按键的功能定义,仪表上某个标志的意义,如何连接手机,如何使用Carplay。此外支持声音识别,根据声音为驾驶者建立不同的用户账户,支持个性化配置。还支持前后排声源定位,车辆能精准识别指令由哪个座位的乘客发起,且该乘客区域的氛围灯会闪烁。语音助手在技术上有三大难点:一是准确拾音,消除噪音,即SSE(Speech Signal Enhancement);二是深度学习训练模型的语料问题;三是语音识别特征提取模型的并行计算。

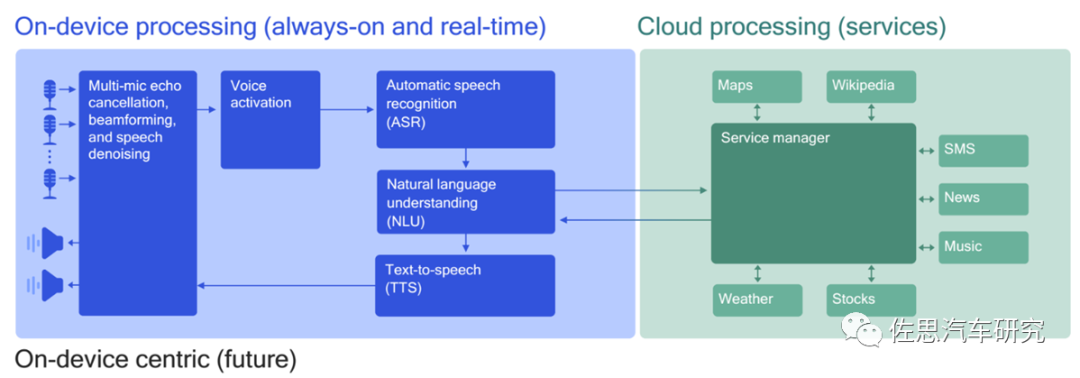

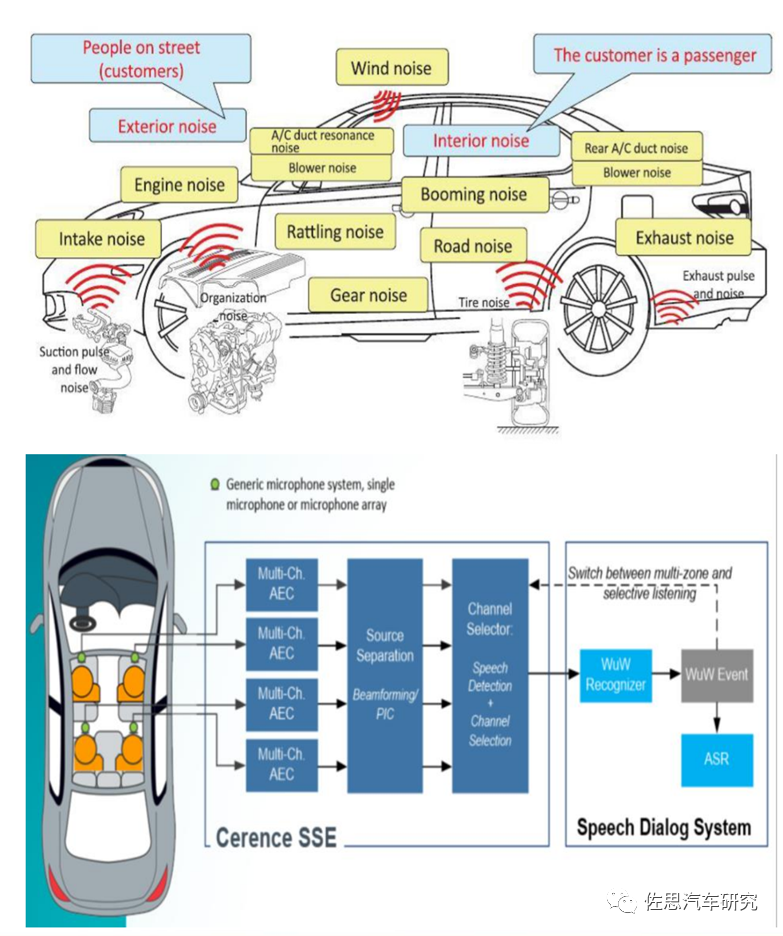

全球车载语音助手提供商Cerence的SSE

图片来源:互联网

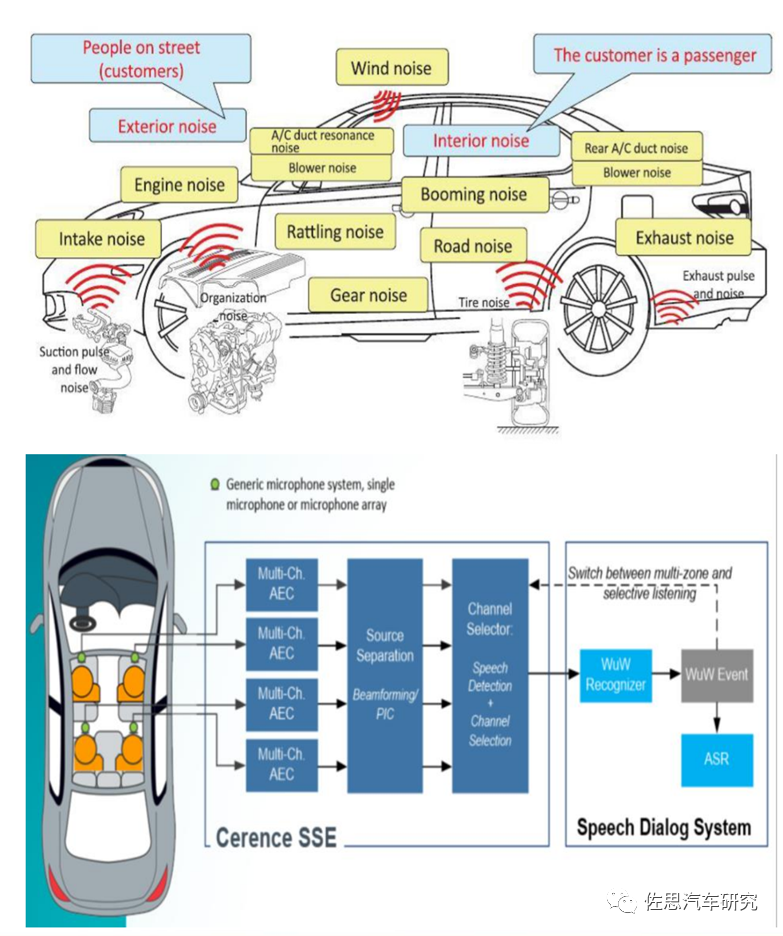

与家庭的语音音箱助手相比,车载语音助手最大的难点在于噪音和指向性。不过车载语音助手成本敏感度比家用语音音箱要低,噪音和指向性一般通过麦克风阵列加AI解决,上图是全球车载语音助手市场占有率超过70%的Cerence的SSE。包括回音消除、波束成型、盲源分离、AGC自动增益、噪音控制、解混响。考虑到未来有可能在车内开网络会议,Cerence能做到根据席位自动关闭或打开麦克风。语料即语音识别的训练数据,与家用不同,车载用途就要特别考虑车载环境,并且是不同的车型车载环境,比如电动车的车内噪音与燃油车差别就很大,柴油车与汽油车的车内噪音差别也不小。需要针对车型搜集相关数据,这导致开发成本高企和开发周期较长。

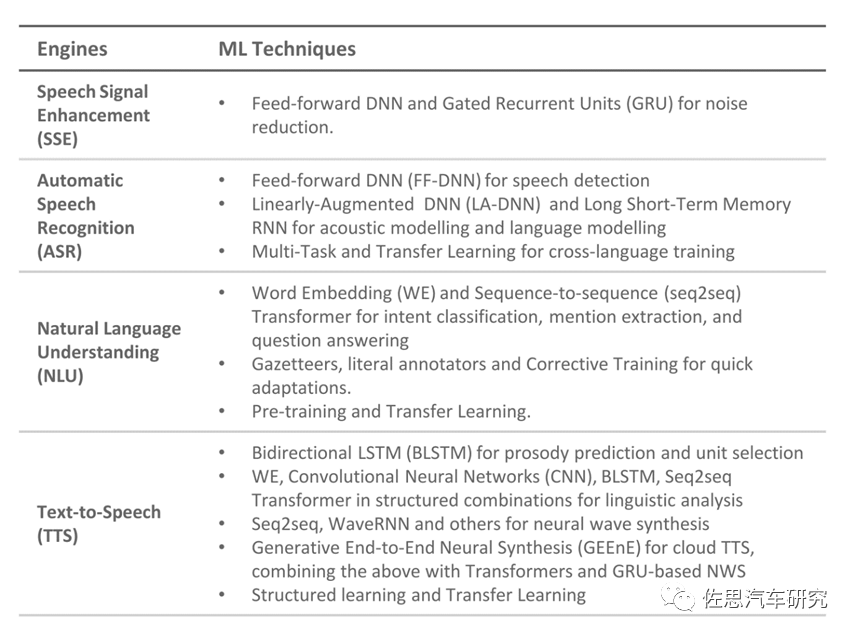

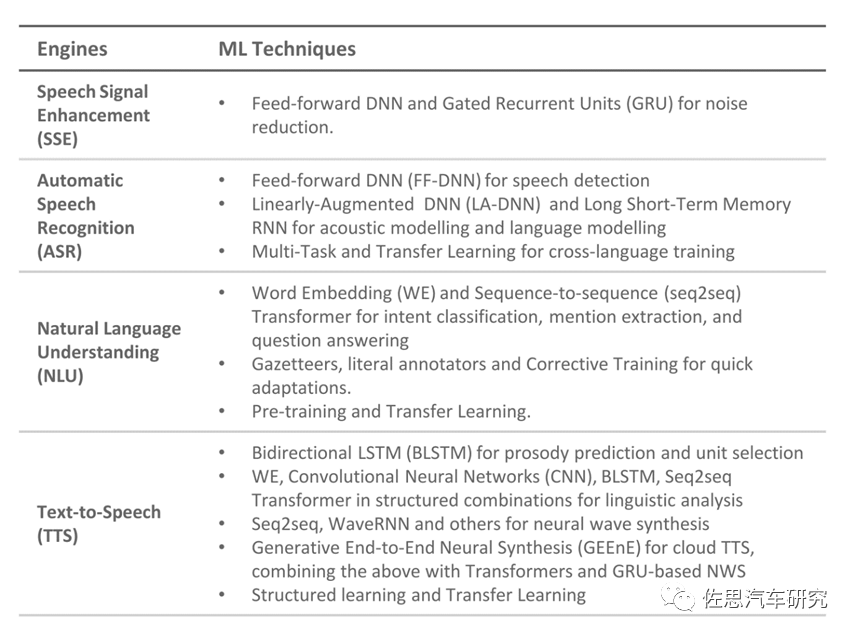

车载语音助手有4个环节需要用到深度学习,与图像类深度学习不同,运算量最大的是LSTM,也就是RNN,目前来说RNN是最成熟最主流的技术,因为其:1、适合解决线性序列问题;2、可以接纳不定长输入;3、LSTM三门的引入,捕获长距离依赖能力加强。但是RNN本身的序列依赖结构对于大规模并行计算来说相当之不友好。为什么并行差?因为s(t)的计算依赖于s(t-1),且不同step的隐层之间全连接。就是说T时刻某个隐层神经元与T-1时刻所有隐层神经元都有连接。而车载的运算资源主要就是并行运算资源,如GPU,串行计算一般由CPU或特制的NPU完成,强大的CPU意味着高昂的成本,大多数芯片里的NPU都是针对图像深度学习的,或者说是针对CNN的,这也是为什么大家都不愿意做离线方案的原因。 目前有两种思路,一是改造RNN,方法一 把隐层之间的神经元依赖由全连接改成了哈达马乘积,这样T时刻隐层单元本来对T-1时刻所有隐层单元的依赖,改成了只是对T-1时刻对应单元的依赖,于是可以在隐层单元之间进行并行计算,但是收集信息仍然是按照时间序列来进行的。所以其并行性是在隐层单元之间发生的,而不是在不同时间步之间发生的。方法二,为了能够在不同时间步输入之间进行并行计算,那么只有一种做法,那就是打断隐层之间的连接,但是又不能全打断,因为这样基本就无法捕获组合特征了,所以唯一能选的策略就是部分打断,比如每隔2个时间步打断一次,但是距离稍微远点的特征只能加层深,通过层深来建立远距离特征之间的联系。这意味着模型很大,典型模型比如上图展示的Sliced RNN。车载环境,有时信号比较弱,噪音大,此外存储空间也不大,因此不太适合特别复杂的大的模型。第二种思路是新兴的Transformer模型,Transformer是谷歌在2017年做机器翻译任务的“Attention isall you need”的论文中提出的,引起了相当大的反响。Transformer做法跟CNN是类似的,一般设定输入的最大长度,如果句子没那么长,则用Padding填充,这样整个模型输入起码看起来是定长的了。目前主要是科研领域,量产商业化产品恐怕还没有Transformer,车载领域应用就更晚了。

图片来源:互联网

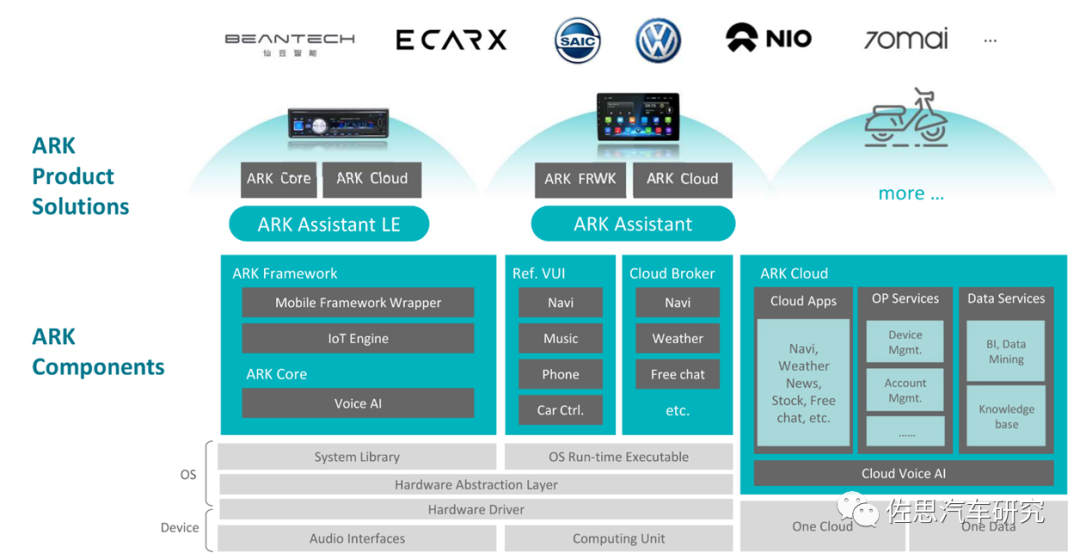

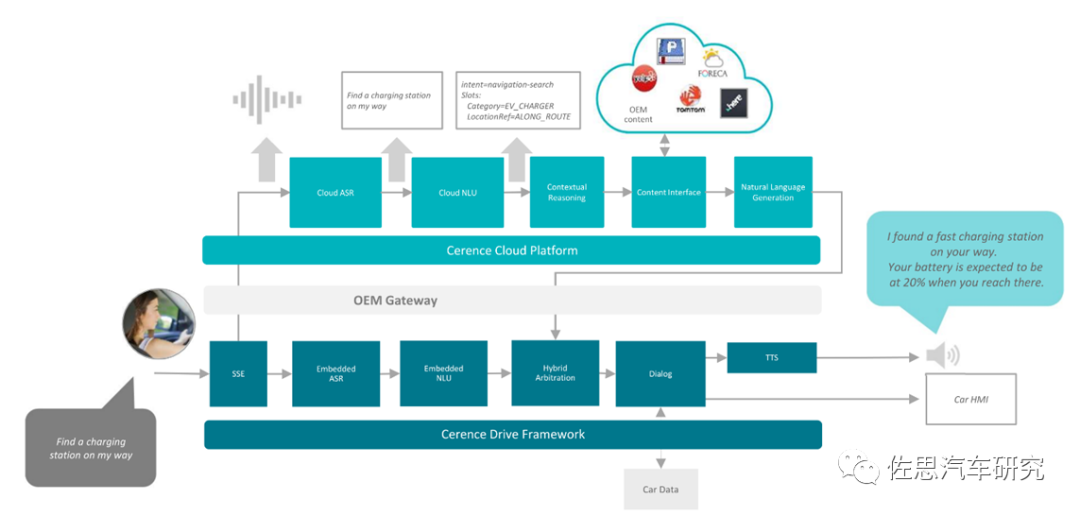

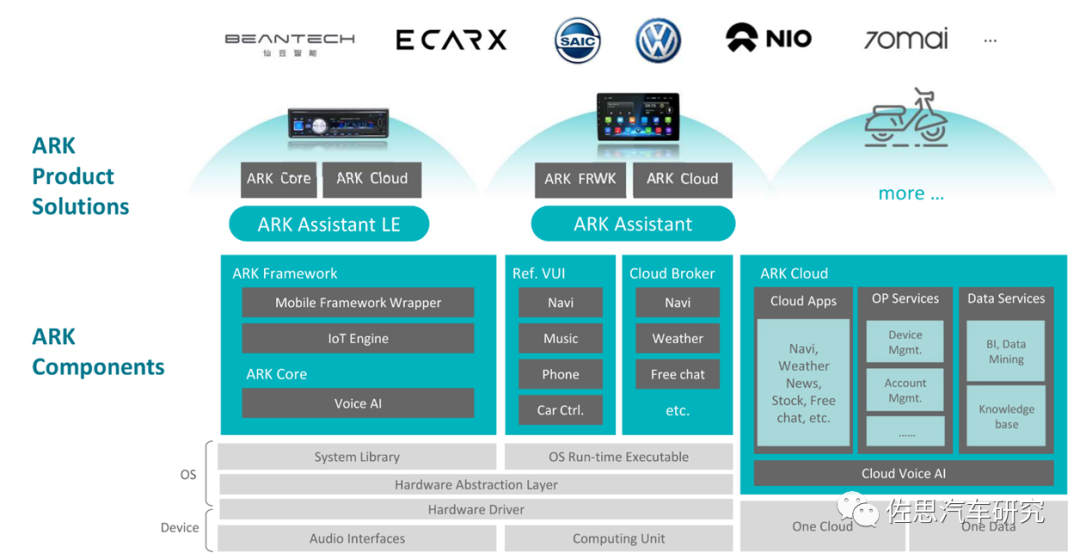

对语音助手公司来说,其产品就是一套软件协议栈,通常不会提供硬件。

图片来源:互联网

语音助手公司与车厂的合作有两种,一种是间接的,通过车机Tier1进行。一种是直接和整车厂合作,提供SDK。以Cerence为例,2020财年其56%的收入来自整车厂,44%来自车机Tier1。2020年最大客户为丰田,占了Cerence 23%的收入。而在2018财年来自整车厂的收入只有36%,来自Tier1的有60%,显然整车厂有意跳过Tier1自己来搞座舱软件。

图片来源:互联网

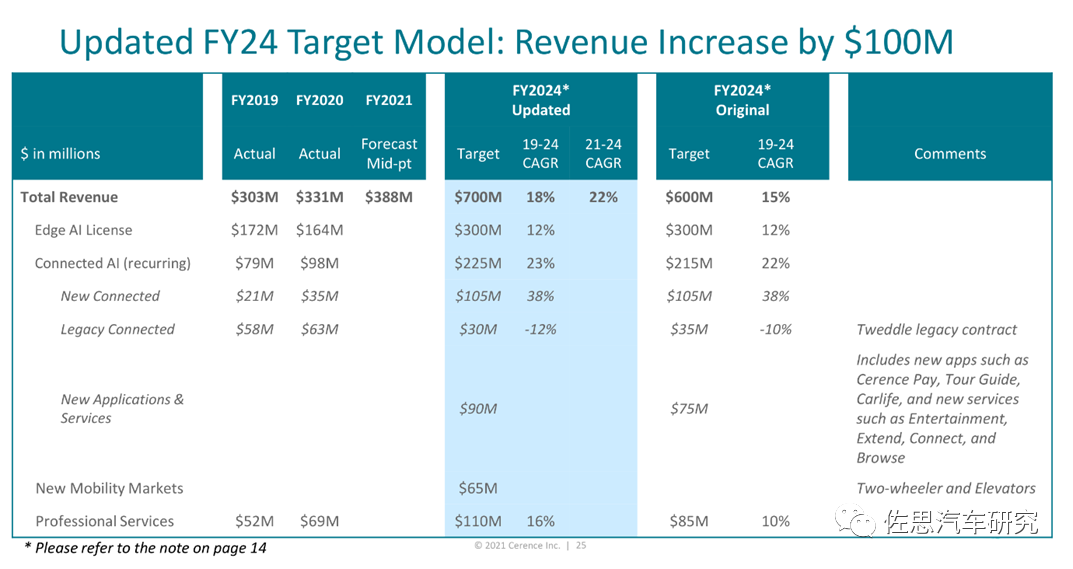

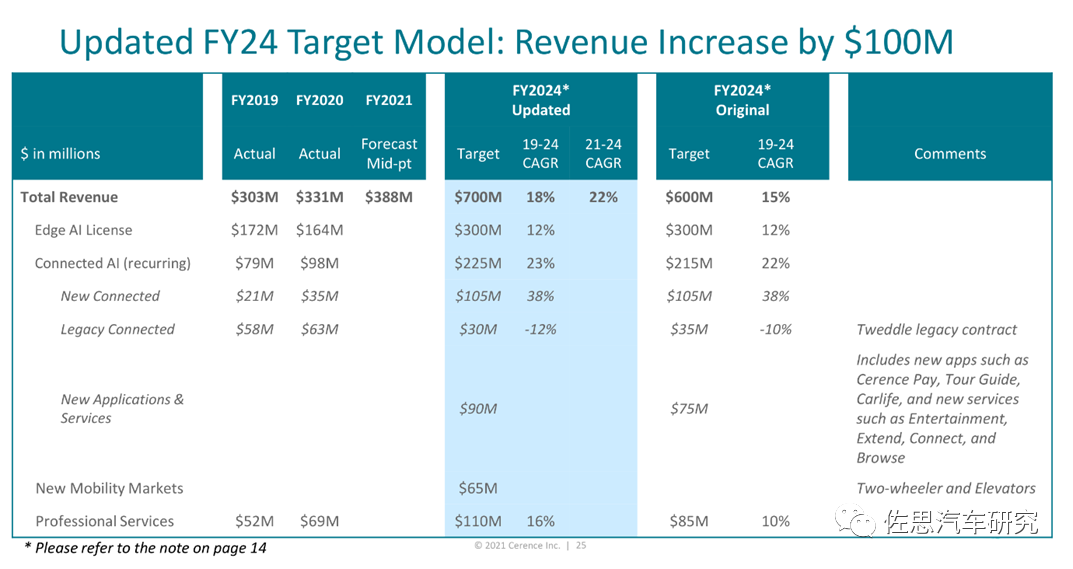

上图为Cerence在2021年8月做的收入预测,预计到2024财年收入将达7亿美元。除中国市场有科大讯飞,美国市场有SoundHound,其他市场,Cerence几乎垄断,全球市场占有率预计至少在70%以上。2021年前9个月,Cerence大约35%的收入来自美国,28%的收入来自德国,亚太地区则从去年的8%增长到12%。2020年科大讯飞的汽车业务仅为3.24亿人民币,跟Cerence比差距很大,且同比2019年下滑了13%。中国市场目前Cerence和科大讯飞处于领先地位。几大巨头如微软、亚马逊、百度虽然在云服务和NLU领域实力强大,但对这些巨头来说车载市场太小了,亚马逊于2018年推出过Alexa Auto SDK,完全免费,但也难与Cerence竞争,多年下来,收获寥寥。不过汽车行业尤其日本和欧洲最忌讳垄断,即便是做得不好,也会有第二名的生存空间。