你的 GNN,可能 99% 的参数都是冗余的

以下文章来源于夕小瑶的卖萌屋 ,作者iven

夕小瑶的卖萌屋 .

有妹子、有猛料的人工智能前沿算法故事会。关键词:自然语言处理、计算机视觉、深度学习、推荐系统、搜索、计算广告、机器学习

文 | iven

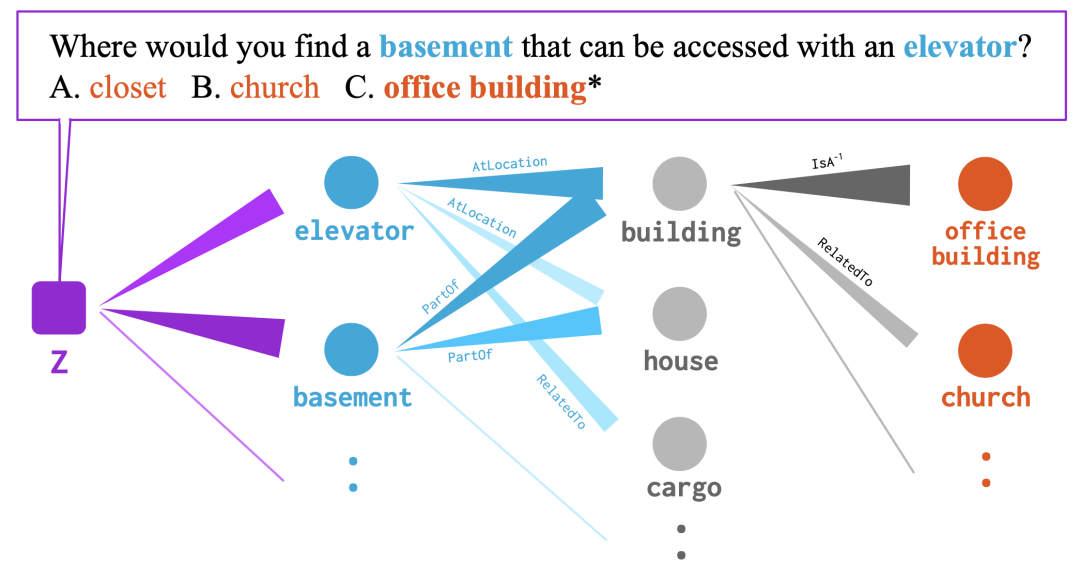

GNN 真的有用吗

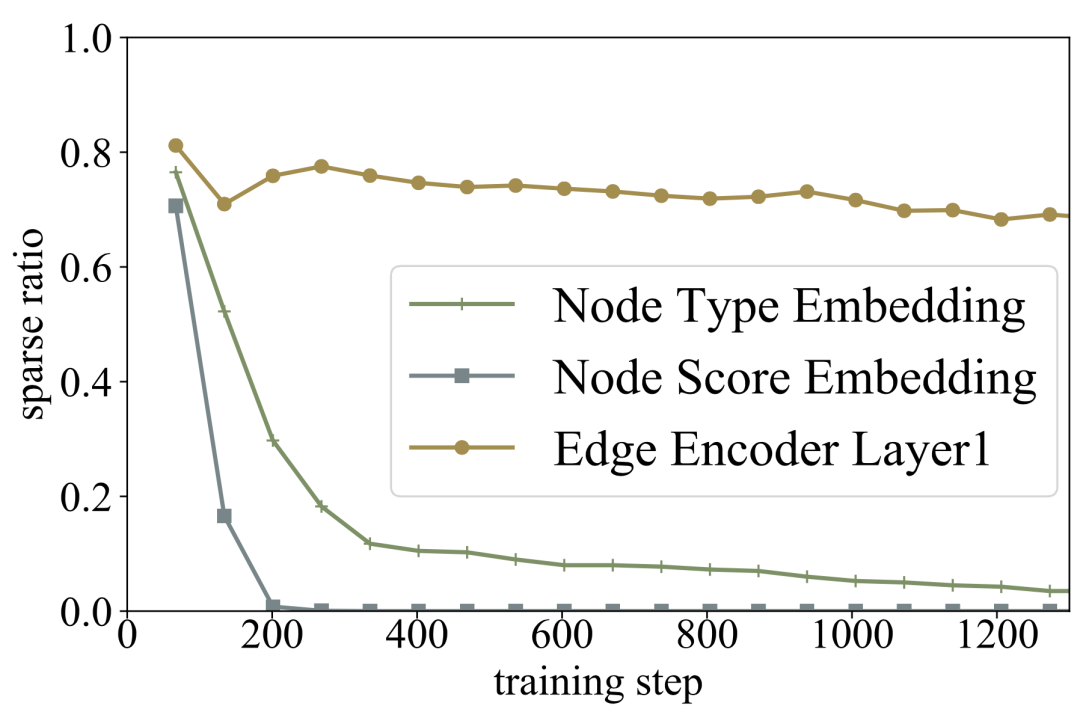

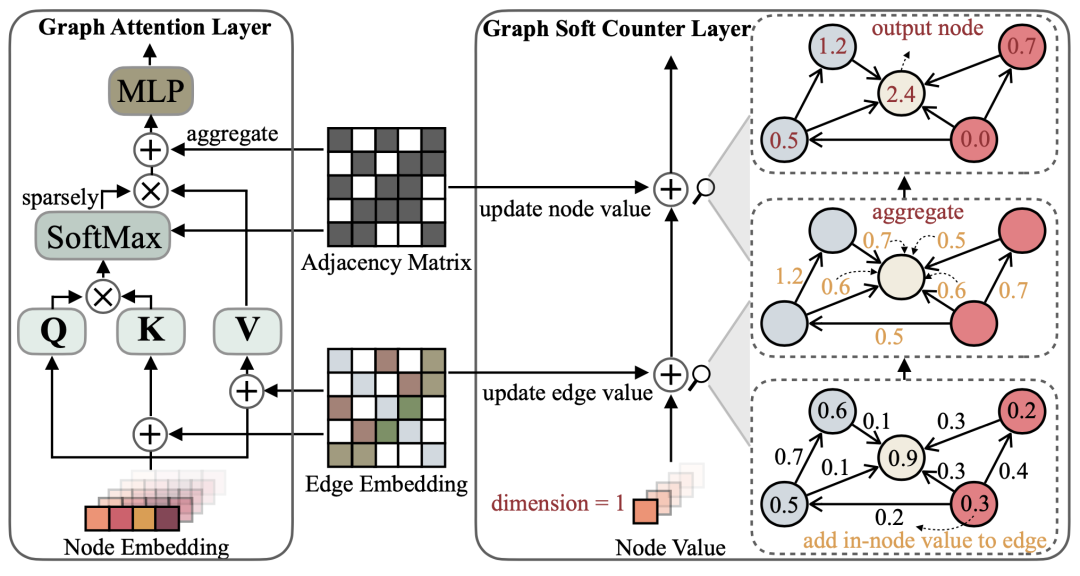

简单的 counter,一样有效

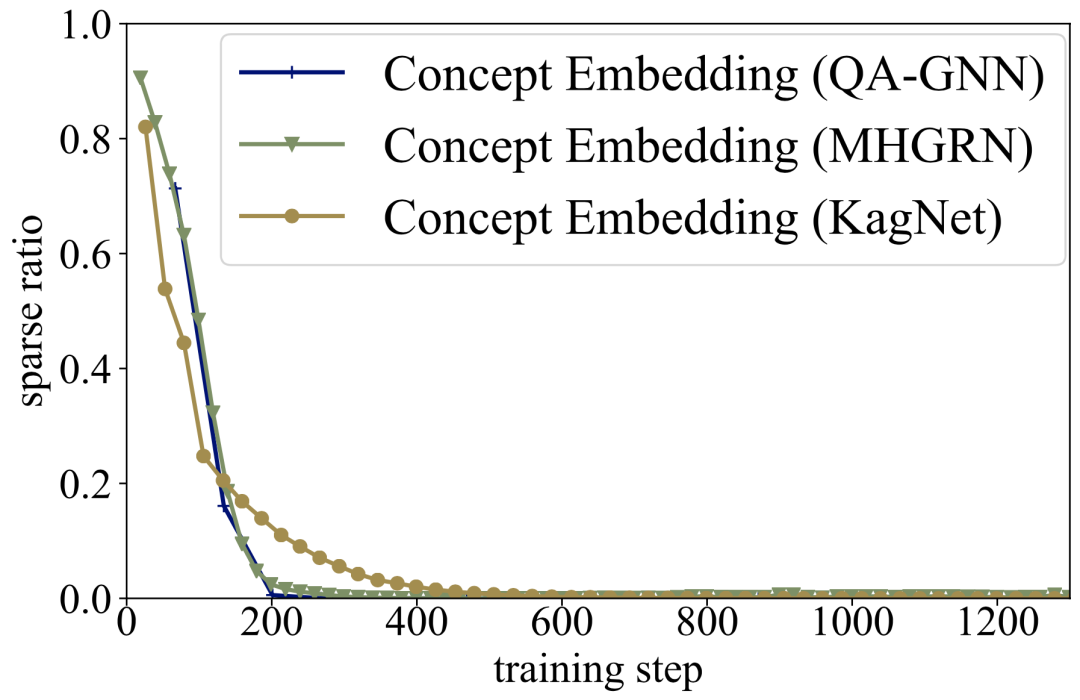

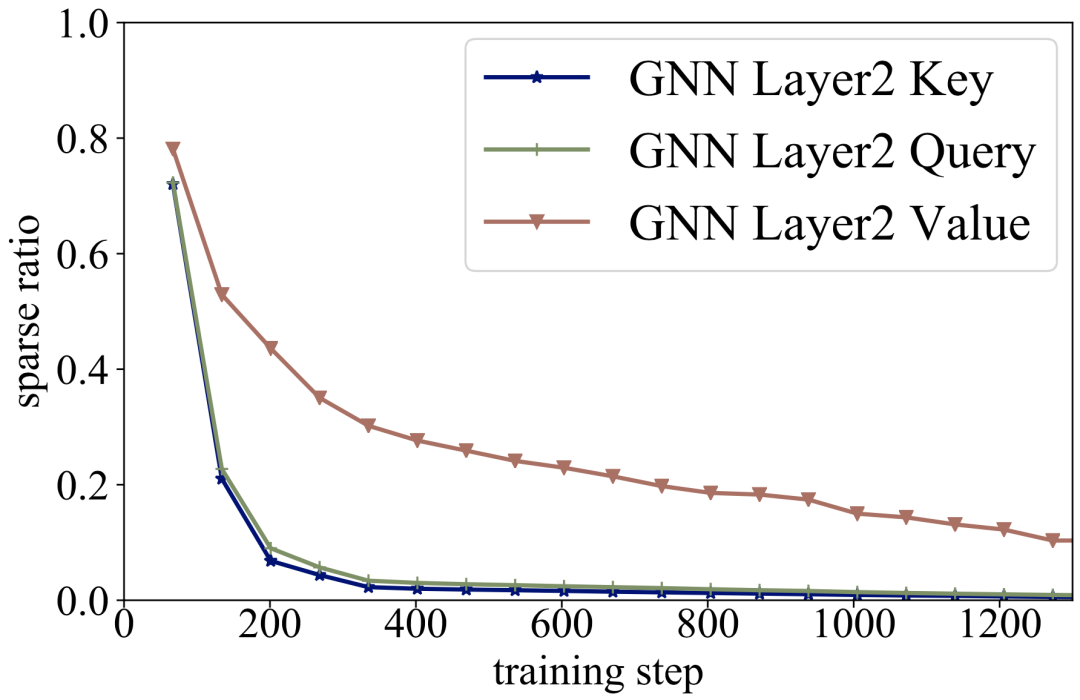

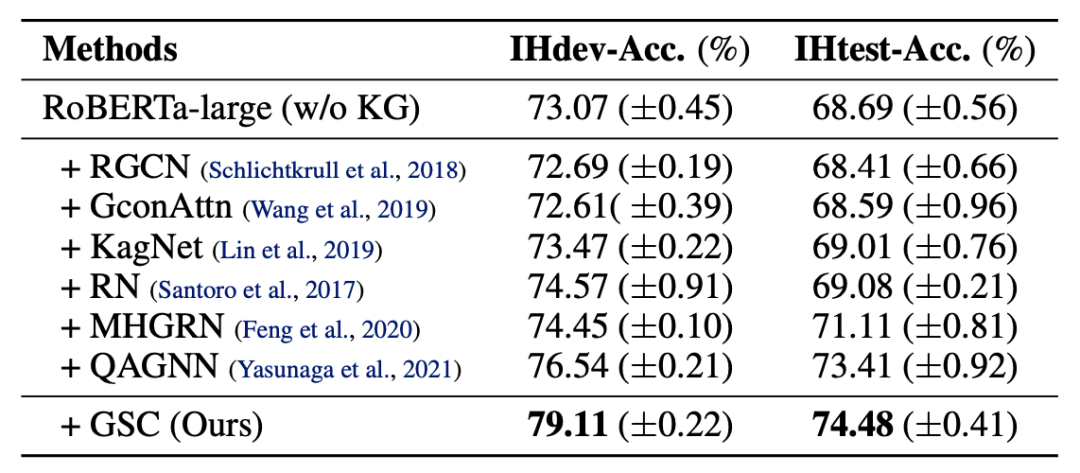

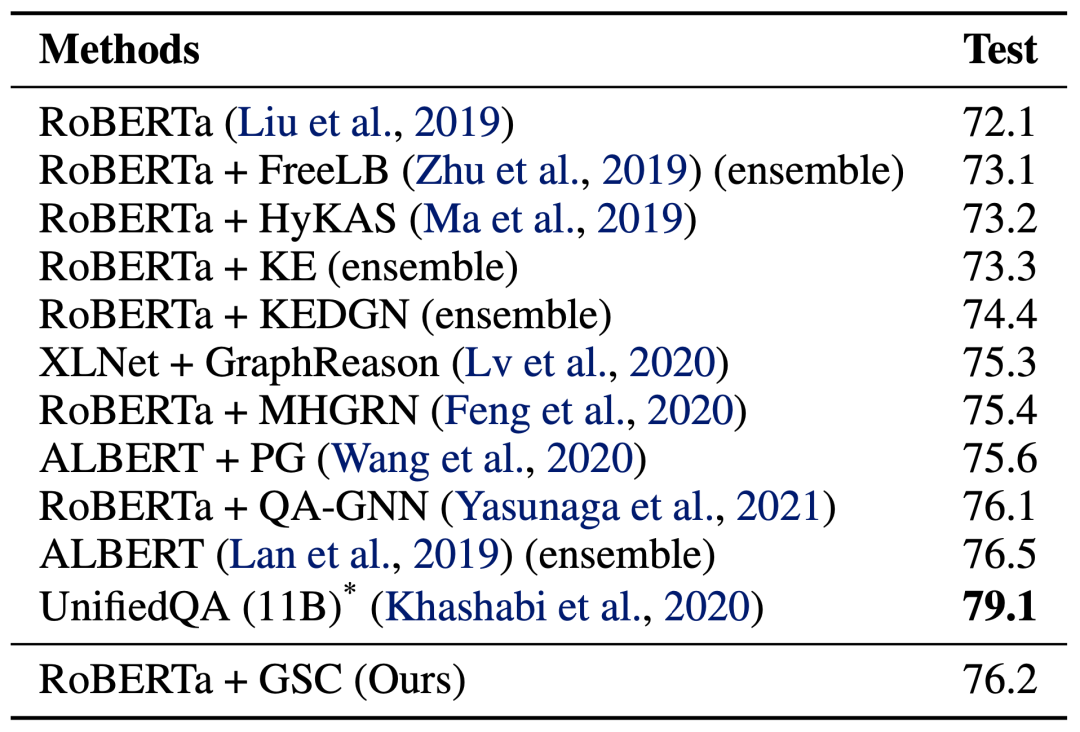

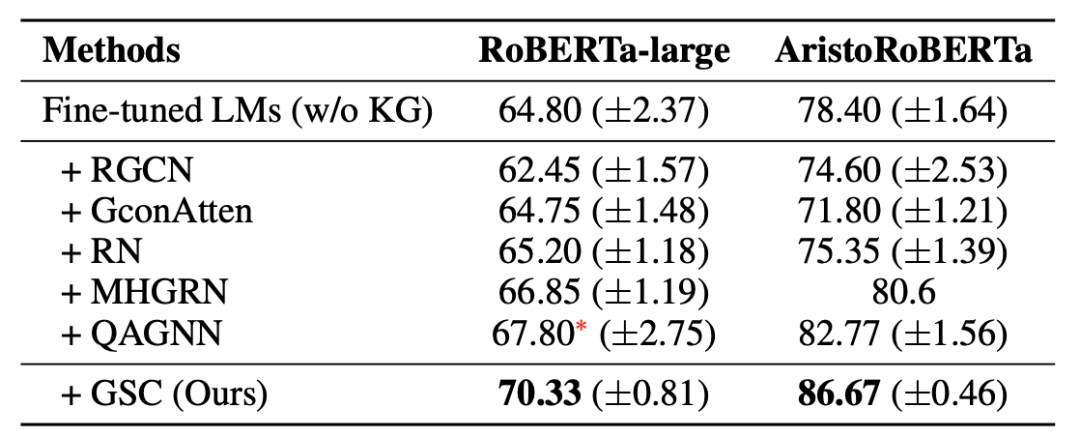

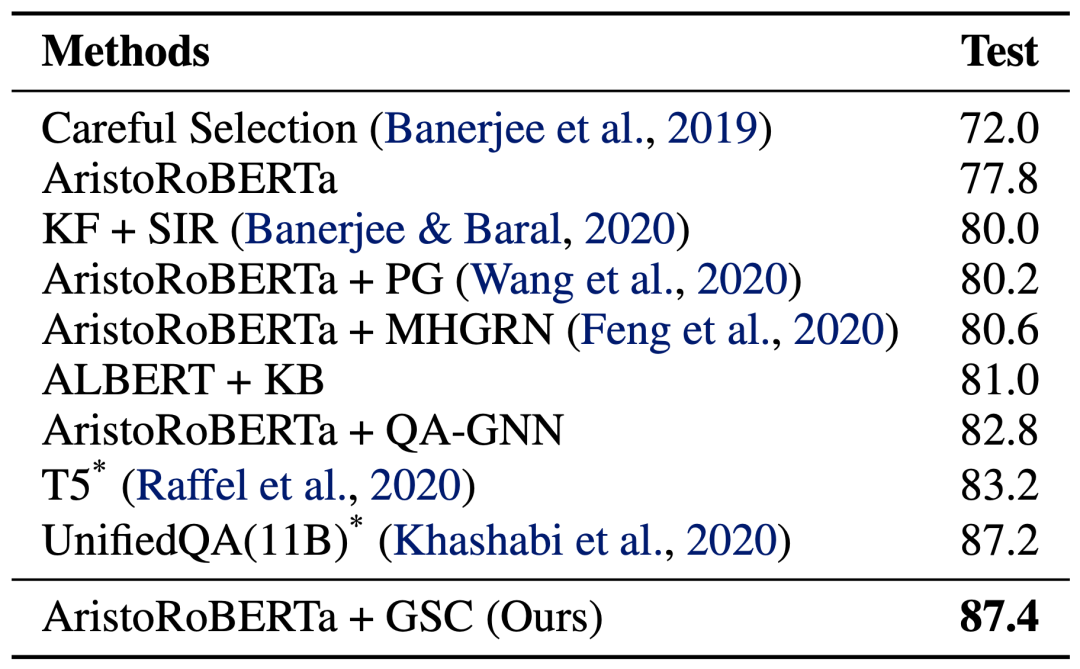

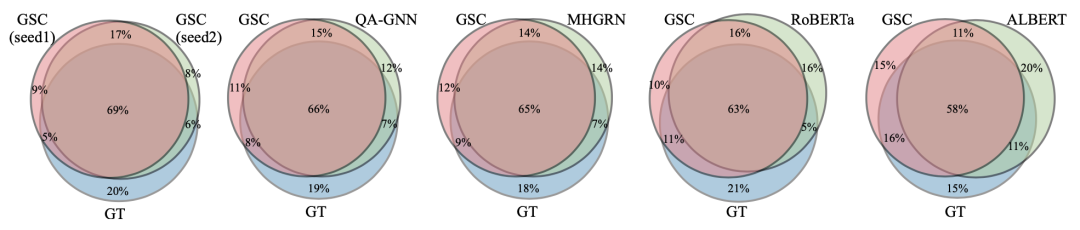

实验

思考和总结

参考文献

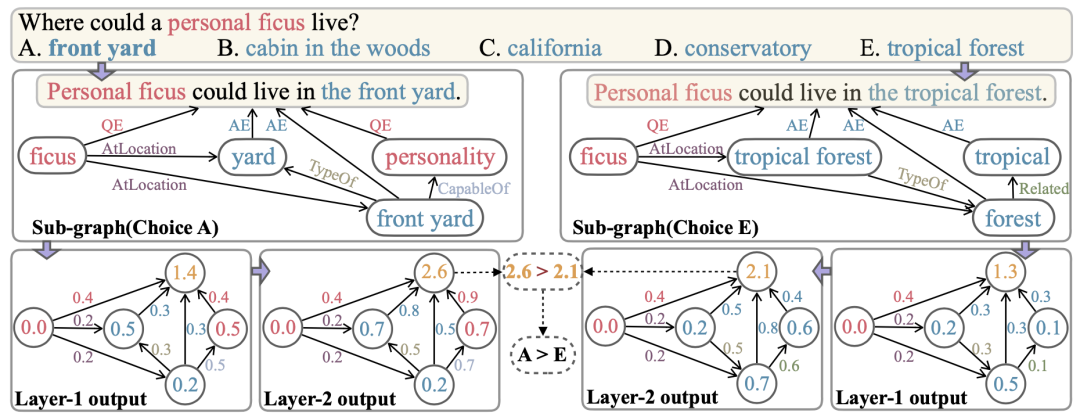

[1] Michihiro Yasunaga, et.al., "QA-GNN: Reasoning with Language Models and Knowledge Graphs for Question Answering", NAACL 2021, https://arxiv-download.xixiaoyao.cn/pdf/2104.06378.pdf

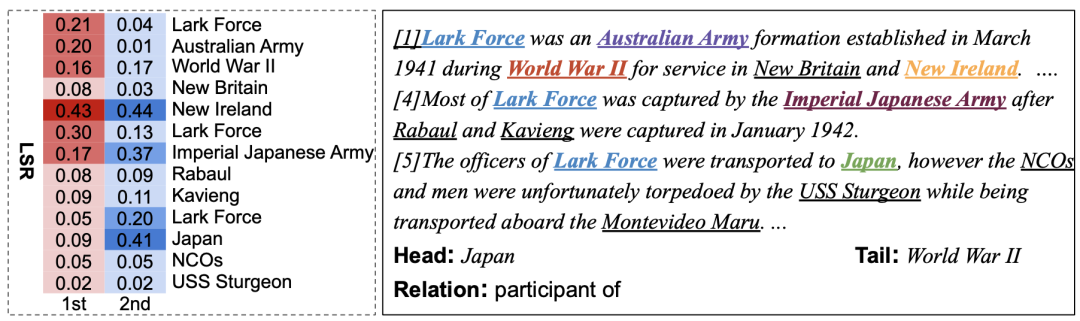

[2] Guoshun Nan, et.al., "Reasoning with Latent Structure Refinement for Document-Level Relation Extraction", ACL 2020, https://arxiv-download.xixiaoyao.cn/pdf/2005.06312.pdf

由于微信公众号试行乱序推送,您可能不再能准时收到AI科技评论的推送。为了第一时间收到AI科技评论的报道, 请将“AI科技评论”设为星标账号,以及常点文末右下角的“在看”。

由于微信公众号试行乱序推送,您可能不再能准时收到AI科技评论的推送。为了第一时间收到AI科技评论的报道, 请将“AI科技评论”设为星标账号,以及常点文末右下角的“在看”。