ICLR 2022 Spotlight | Anomaly Transformer:基于关联差异的时序异常检测方法

以下文章来源于THUML ,作者徐介晖

清华大学软件学院机器学习实验室,专注于迁移学习、深度学习、知识学习等基础理论方法及在人工智能和工业数据软件中的应用研究,负责人为王建民教授和龙明盛副教授,顾问为Michael I. Jordan院士。

本文介绍本组时间异常检测方向的最新工作:ANOMALY TRANSFORMER: TIME SERIES ANOMALY DETECTION WITH ASSOCIATION DISCREPANCY,该论文是ICLR 2022会议的Spotlight(亮点)论文。本篇文章探索了通过基于不同时间点之间的关联差异来进行时序异常检测的方法。

作者:徐介晖*,吴海旭*,王建民,龙明盛 链接:https://openreview.net/pdf?id=LzQQ89U1qm_

现实世界的系统会有大量的连续数据,这些时序数据的异常检测对于保障系统安全、避免经济损失有着重要意义,例如服务器、地空设备的监测等。本文关注无监督时序异常检测问题。

这一问题已经受到了广泛关注。但是经典异常检测方法(例如LOF、OC-SVM)很少考虑时间信息,这使得他们在时序场景中应用受限。基于深度网络方法,往往是通过循环网络(RNN)学习时序数据点级别的表征,进而依靠重建或预测误差进行判定,然而,此类方法所学习的点级别表征的信息量较小,并且可能被正常模式主导,使得异常点难以区分。

因此,如何获取更具信息含量的表征,进而定义更加具有区分性的判据对于时序异常检测尤为关键。

二、动机

不同于点级别表征,我们注意到在时间序列中每一个点都可以由其与整个序列的关联来表示,可以表示为其在时间维度上的关联权重分布。同时,相比于正常点来说,异常点很难与序列的所有点都构建很强的关联,且由于连续性往往更加关注邻近区域。这种整个序列和邻近先验之间的关联差异为时序异常检测提供了天然的、强区分度的判据。

基于上述观察,我们提出了Anomaly Transformer模型用于建模时序关联,同时利用极大极小(Minimax)策略突出正常、异常点之间差别,实现了基于关联差异(Association Discrepancy)的时序异常检测。Anomaly Transformer在不同领域的5个数据集上都取得了SOTA的效果。

三、方法

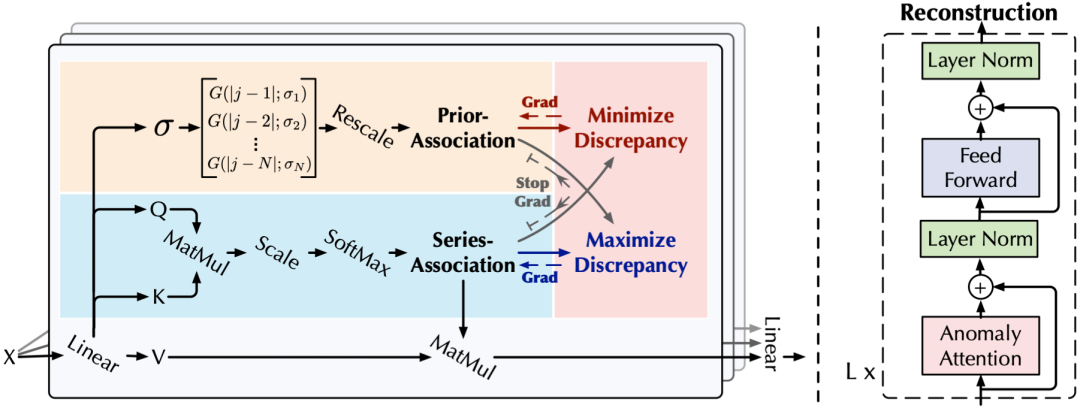

Anomaly transformer模型包含用于建模时序关联的Anomaly-Attention,其整体结构是Anomaly-Attention和前馈层的交替堆叠,从而有利于模型从多层次特征中学习潜在的时序关联。

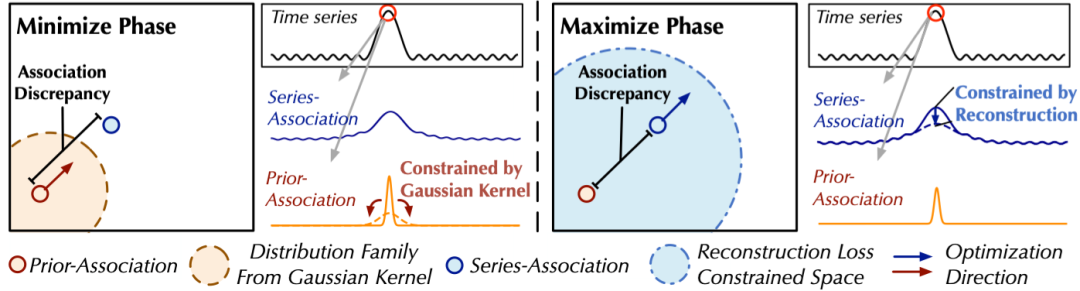

如下图所示,Anomaly-Attention(左)同时建模了数据的先验关联(Prior-Association)和序列关联(Series-Association)。除了重建误差之外,我们的模型还采用了极大极小策略(Minimax)用于进一步增大异常点和正常点所具有的关联差异的差距。

整体架构

3.1.1 Anomaly-Attention

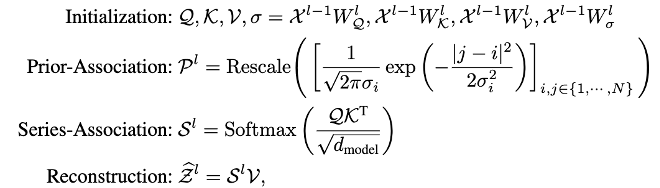

我们提出的一种新的注意力机制Anomaly-Attention,用于统一建模先验关联和序列关联,进而方便关联差异的计算。

· 对于先验关联 ,我们采用了可学习的高斯分布,其高斯分布的中心在对应序列的索引上。这种设计可以利用单峰分布的特点,使模型更加关注临近的点。同时,为了使得先验关联能够适应不同的时序模式,高斯先验包含可学习的参数 。

· 对于序列关联 ,它是由标准Transformer中注意力计算获得,一个点的序列关联即是该点在注意力矩阵中对应行的注意力分布。该分支是为了学习原始序列中的关联,从而自适应地学习最有效果的关联。

与逐点表征相比,我们的两种关联都很好地维持了每个点在时间维度上的依赖从而使得表征具有了更丰富的信息。它们也分别反映了邻近先验和习得的真实关联。这两者之间的差异,即为关联差异(Association Discrepancy),可以天然的将正常点和异常点区分开来。

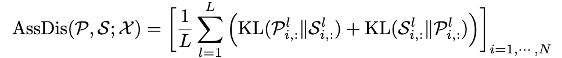

3.1.2 关联差异(Association Discrepancy)

3.2 极大极小关联学习

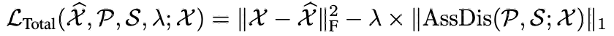

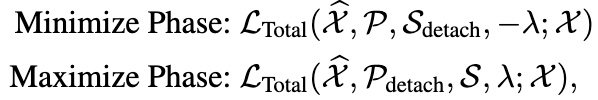

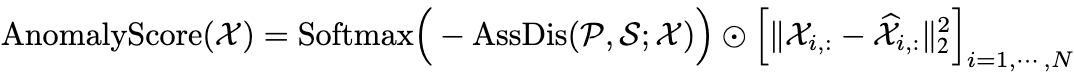

我们将标准化后的关联差异与重建误差结合起来制定了新的异常检测判据:

四、实验

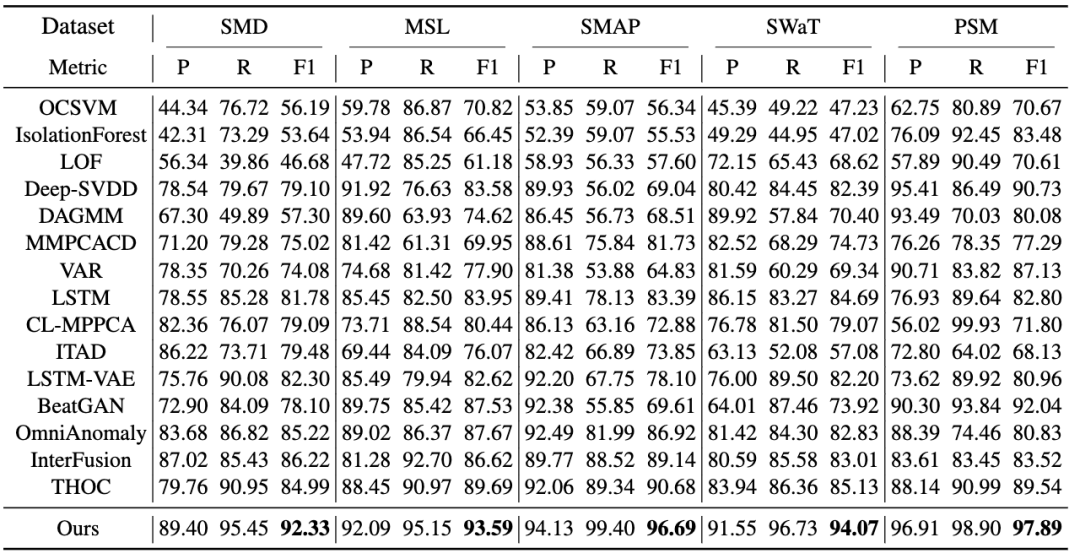

我们在不同领域的5个数据集上进行了模型验证,涵盖服务检测、地空探索等多个应用。Anomaly Transformer在5个基准中均实现了SOTA的效果。更多基准模型及数据说明请见论文。

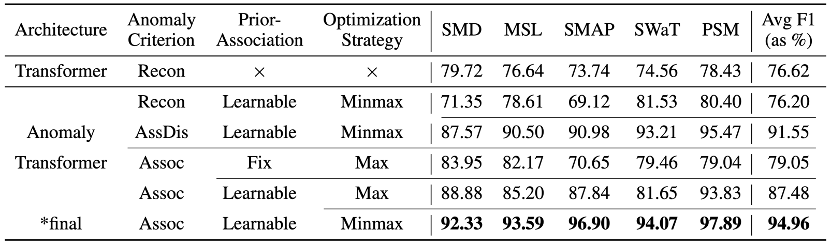

4.1 消融实验

为了进一步验证我们所提出模块的有效性,我们设计消融实验验证了提出的训练策略、先验关联、新的异常判据的有效性。

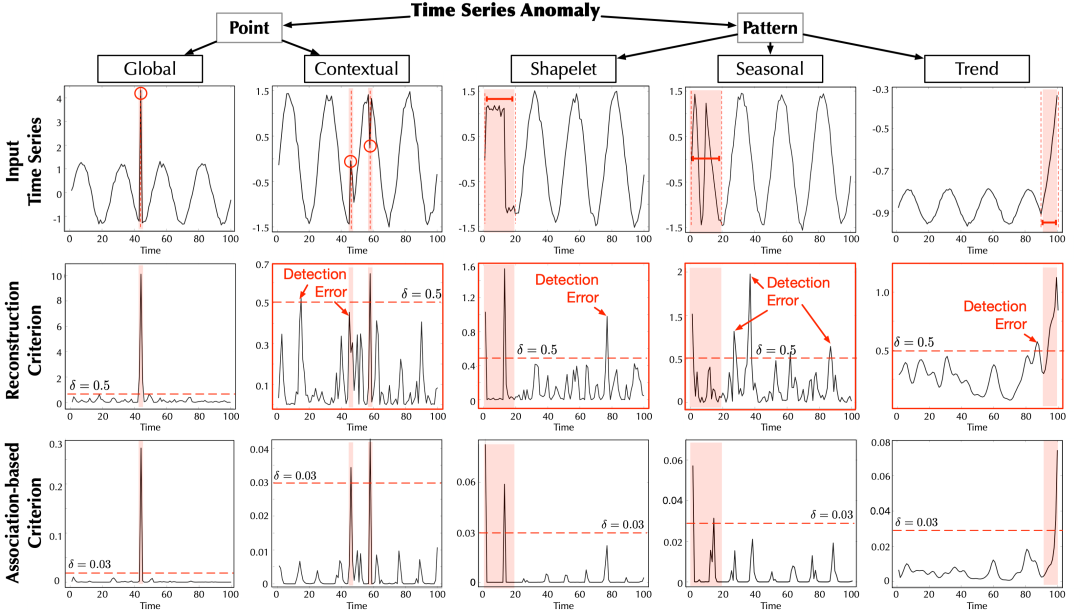

4.2 可视化分析

针对5类不同的异常类别,我们可视化了其在不同异常判据下的区分性。数值越高意味着该点异常的概率越大。不难发现基于关联的异常评判曲线有着更加准确的可区分性。

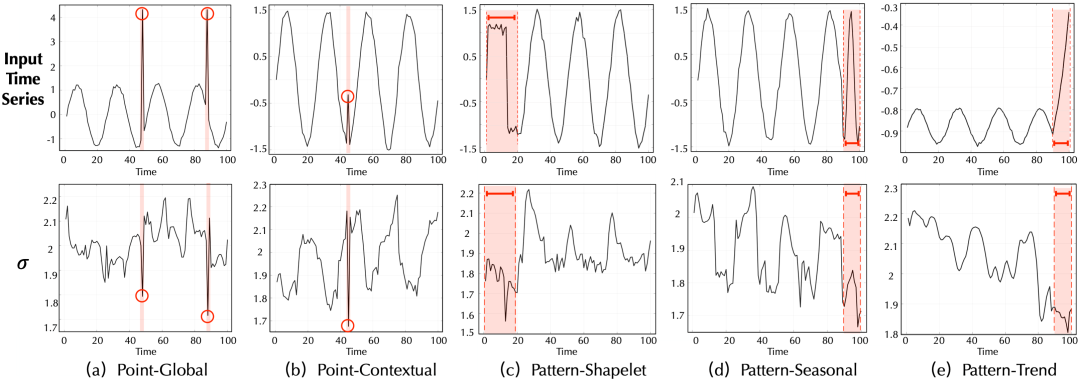

针对5类不同的异常类别,我们可视化了其在先验关联中最终学得的 的大小。不难发现,在异常点处的 在整个序列中都比较小,这代表了它与非临接部分的关联非常弱,这也符合我们认为异常点与整个序列构建强关联的假设。

4.3 优化策略

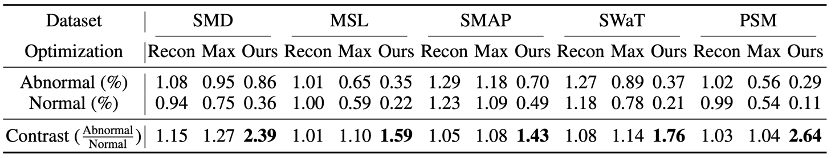

为了验证优化策略对于关联学习的影响,我们对比了直接使用重建误差训练、直接最大化关联差异、极大极小关联差异的影响。

如表所示,直接最大化关联差异将会引起高斯先验的优化问题,从而使得效果退化。而最大最小化策略使先验关联对序列关联增加了一个很强的限制,最终可以达到一个更加有辨别能力的结果。

五、总结

本文关注无监督时序异常检测问题,提出了基于关联差异的异常检测模型Anomaly transformer,并通过一个最大最小化学习策略大幅提高了模型的异常检测能力。

Anomaly transformer在服务监测、地空探索、水流观测等应用中均展现出了优秀的异常检测结果,模型具有良好的效果鲁棒性,具有很强的应用落地价值。

本文来自:公众号【THUML】 作者:徐介晖

扫码观看!

本周上新!

关于我“门”

▼

点击右上角,把文章分享到朋友圈

点击“阅读原文”按钮,查看社区原文

⤵一键送你进入TechBeat快乐星球