2022 机器人学习前沿与落地进展到哪了

机器人学习Robot Learning一直是我们关注的一个主题,在之前也写过了很多相关文章,比如下文:

最前沿:机械臂抓取的落地进展与思考: https://www.techbeat.net/article-info?id=877

又过去了1年半,现在的机器人学习的前沿及落地进展到哪里了?

这篇blog,我们梳理一些学术界及工业界相关的工作,仅包括和深度学习,深度强化学习,sim2real相关工作,必有疏落,还请批评指正

来源:知乎 作者:Flood Sung 链接:https://zhuanlan.zhihu.com/p/468252311

1.1 ANYmal: 四足机器人能够在野外随便走了

Learning robust perceptive locomotion for quadrupedal robots in the wild

https://leggedrobotics.github.io/rl-perceptiveloco/

ETH ANYmal团队以每年一篇Science Robotic的速度在不断提升基于神经网络的四足机器人的能力。在这篇最新的工作中,通过视觉得到的地形信息被充分利用,完美的深度强化学习训练及sim2real,使得ANYmal可以适应各种复杂地形。这个成果进一步的说明了深度强化学习及Sim2Real在机器人控制上的优越性甚至不可替代性,四足机器人的行走能力得到了极大的提升,目前并没有公开的实验来对比AnyMal和波士顿动力的Spot之间的行走能力差别,但我确信ANYmal肯定会更强。这个成果也进一步让大家看到了四足被广泛应用的前景。

1.2 Agility Robot: Cassie 两足机器人能走5公里路了

OSU Bipedal Robot First to Run 5K

https://www.youtube.com/watch?v=a_YGPbWJO5g

CSL seminar: Alan Fern

https://www.youtube.com/watch?v=nXR3zI_ae7A

方法论和ANYmal的四足基本一样,就是深度强化学习+Sim2Real,只是两足显然要比四足更难,因此目前两足的效果看起来比四足要差一些,但能够在平坦地面连续走5km也很强了。这成果是波士顿动力用传统控制方法很难达到的效果。可以预期这一两年两足机器人应该也能达到四足的水平,在不平坦的野外行走。

1.3 Nvidia:Isaac Gym

Isaac Gym - Preview Release

https://developer.nvidia.com/isaac-gym

Isaac Gym 经过Nvidia相关团队3年的研发,终于是越来越成熟,Isaac Gym的数据直接在GPU上通过Pytorch Tensor API处理,绕过了CPU的过程,使得Isaac Gym的仿真速度超级快,一个好的GPU就可以等价原来要几百上千CPU集群的训练效果。当然,现在的Isaac Gym对视觉输入输出的支持还不够好,但对于四足,机械手等非视觉控制任务已经是一个非常好的训练环境了。

Google也推出了brax 支持类似Isaac Gym的效果,但底层原理和实现手段不一样,主要是基于Jax,对渲染支持不足。

https://github.com/google/brax

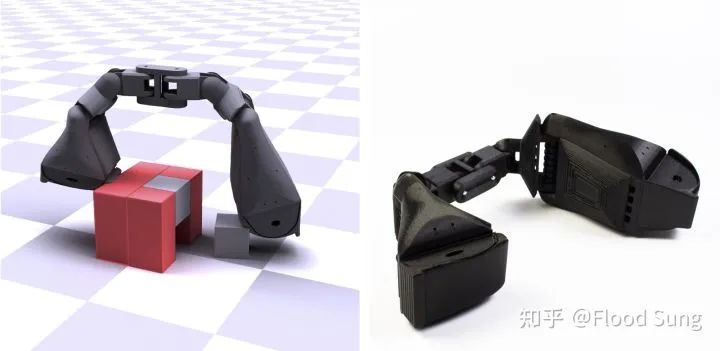

1.4 机械手: CoRL 2021 best paper:A System for General In-Hand Object Re-Orientation

A System for General In-Hand Object Re-Orientation

https://taochenshh.github.io/projects/in-hand-reorientation

以前OpenAI只能转小方块,现在MIT的工作拓展到能转任意物体,算是一个不错的突破。方法上就是深度强化学习,这个工作因为疫情并没有在真实机械手上实现。对于未来的VR/AR应用,这个工作也具有潜在的应用价值,可以更好的去模拟抓取的动作。

1.5 负向进展:OpenAI 关闭其机器人研究小组,停止了机器人研究

这可能是去年非常重磅的新闻了,原因是相比于NLP,机器人学习的数据太难获取了。所以OpenAI 机器人小组的leader Wojciech Zaremba 改去做GPT相关工作了。

这确实也是事实,机器人学习太需要环境和可用于模仿的数据,但两者目前都比较难以获取。但正因为难,我们更应该去做它。去造环境也好,或者造数据也好。

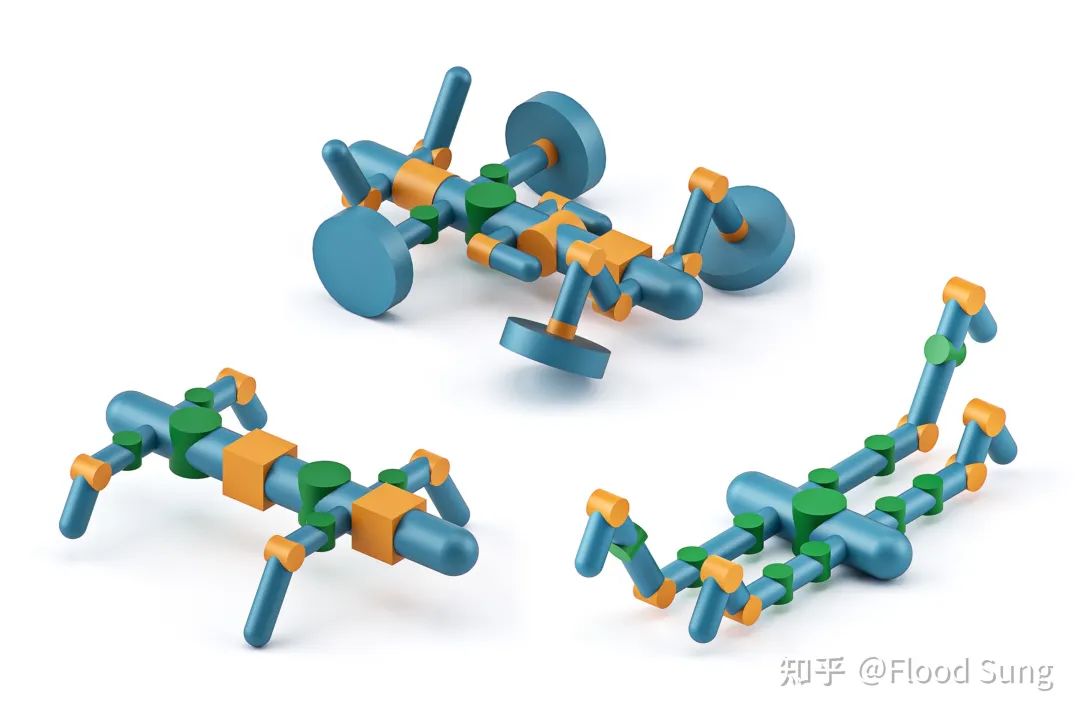

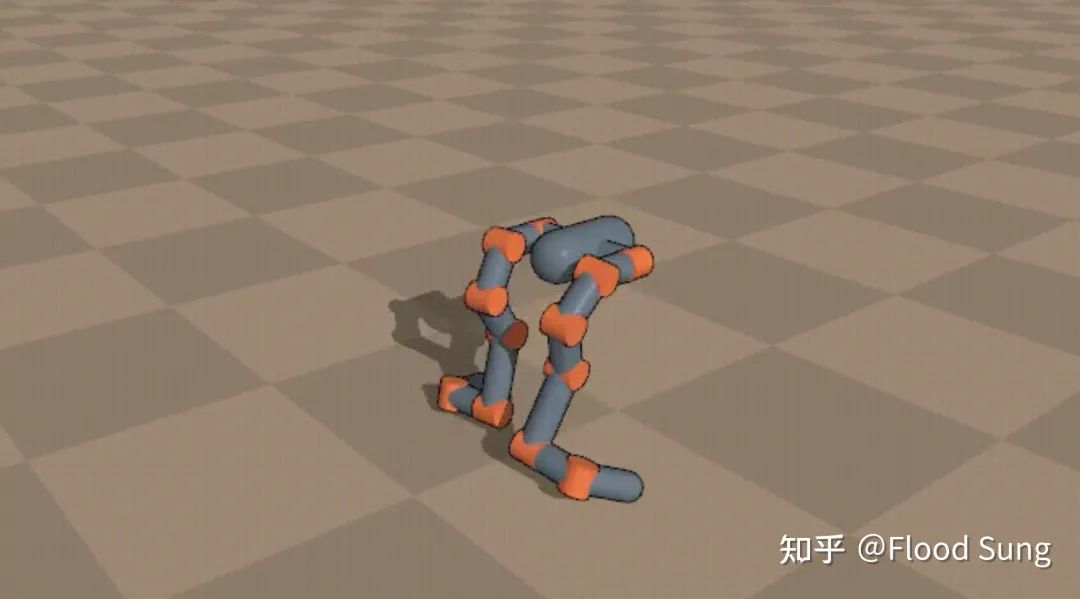

1.6 Robot Design with AI

通过AI来设计机器人的形态是一个非常有意思的方向,当然目前还处于比较早期的阶段。有一些有意思的工作,比如:

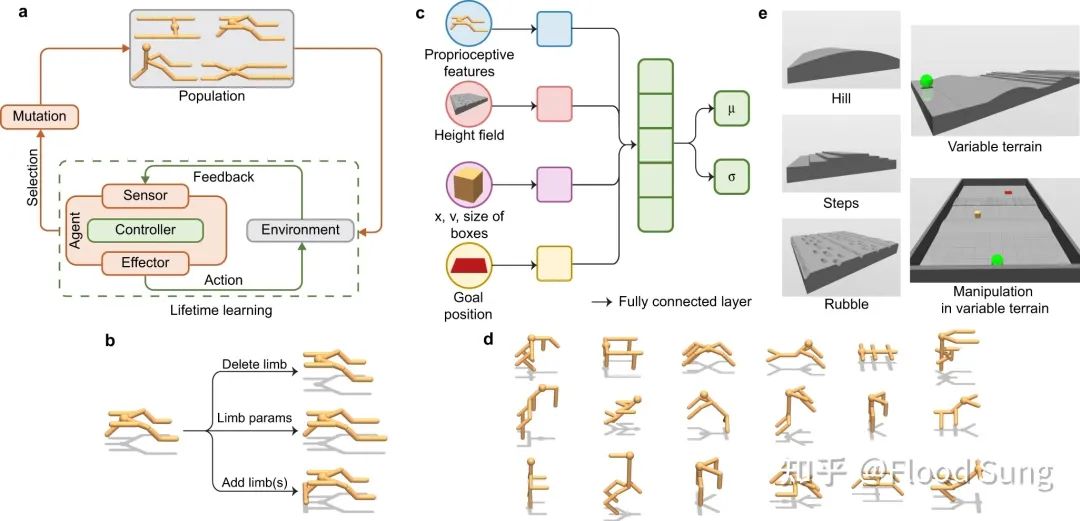

1.6.1 Embodied Intelligence via Learning and Evolution

1.6.2 Jie Xu (MIT CSAIL) 做了很多相关的工作

到最近的这一篇,已经到了sim2real的阶段,很强。机器人结构通过AI来探索和Automl探索网络结构有点类似,对于未来机器人的结构设计将会产生重要的影响。

1.7 机械臂相关:没有令人惊喜的研究出现

不管是DeepMind,还是Google brain,Nvidia及四大,机械臂相关的研究都中规中矩,没有惊喜,没有太多可以认为突破的研究,当然简单的机械臂抓取问题已经在工业界基本解决了,并处于落地状态。

1.8 Physics-based Animation:Daniel Holden: SuperTrack

https://montreal.ubisoft.com/en/supertrack-motion-tracking-for-physically-simulated-characters-using-supervised-learning/

这一两年来physics-based animation倒是涌现了挺多有趣的研究,Daniel Holden的SuperTrack算是其中的一个。physics-based animation和机器人相关性非常大,因为其实就是做virtual robot,只有sim,没有2real的阶段而已。

2 minutes papers - https://www.youtube.com/watch?v=szOMIn0YyUM&t=252s 也有相关的介绍。

在我看来,机器人学习要有突破,首先就要在physics-based animation上突破,然后再考虑sim2real。前面的ANYmal和Cassie都是在虚拟环境中训练突破。

1.9 Differential Physics for Robot Learning

Daniel Holden的SuperTrack就是基于可微分物理来实现的,可以算是一个蛮大的突破。因为这个要训练好很难。

前面提到的 Google Brax - https://github.com/google/brax 就是可微分的。SuperTrack是学出来的model,brax则是环境自带可微分属性。

model-based learning 在RL领域本来就是能极大提升训练效率的方法,现在应用到机器人学习中能够成功也就可以极大的提升机器人学习的训练效率。

当然现在这个方向也才刚起步,接下来要看像SuperTrack能否更进一步的处理更复杂的碰撞问题,同时不再只是简单的模仿一段mocap,而是真正学会某个技能。

1.10 Language Model and Decision Making

Language Models as Zero-Shot Planners:

https://wenlong.page/language-planner/

vh-language

https://shuangli-project.github.io/Pre-Trained-Language-Models-for-Interactive-Decision-Making/

语言模型和决策最终要走到一起,毕竟从人类的角度看,语言和行为是无缝连接的。但怎么做好也还在早期。个人比较看好的是预训练模型结合RL做finetuning,或许我们就可以看到更智能的能说话还能行为的机器人or游戏里的NPC。

1.11 小结

从上面的一些学术前沿进展看,这一年半来机器人学习在Locomotion行走上取得了较大的突破,同时出现了一些全新的研究方向具有较大的潜力,但距离我们想要看到的General Purpose Robot通用机器人还是有很远的距离。我们需要更好的机器人模拟器,还有更好的获取有效数据的方式,这样或许可以离General Purpose robot更近一点。

当然,Tesla 在去年8月份提出了Tesla bot,目标就是通用机器人:

虽然作为机器人学习领域有所了解的人感觉tesla bot很扯,但马斯克也没说马上要实现呀。梦想还是要有的,10年后实现也是巨大变革。

个人认为Tesla如果收购agility robotics应该会大幅度加快他们的进度。

二、机器人学习落地情况

2.1 机械臂抓取

AnyGrasp令人印象深刻,GraspNet 可以抓取各种物品了。主要的几家机械臂抓取初创公司都在落地,包括xyz robotic,covariant 等等(之前的blog有讲)

这些落地更多的还是依赖计算机视觉,控制还是传统控制,深度强化学习在里面的作用相对来说没有那么大,根本的原因还是在于对控制的要求没有那么高。而像四足行走这样的控制,要用传统控制来做的话会麻烦很多,而用深度强化学习却可以很快训练出一个控制器。

由于目前的机械臂抓取的落地方式和深度强化学习及sim2real关系不大,所以我不太认为按照这个方式落地未来能迁移到通用机器人。

2.2 Google EveryDayRobots and Intrinsic

everydayrobots

https://everydayrobots.com/

Intrinsic – Home

https://www.intrinsic.ai/

Google 绝对是深度强化学习和Sim2Real的深度信仰者,所以Google X长期在孵化相关的机器人项目,去年都作为独立子公司运营了。虽然Google已经做了一些突破,但现在离很好的落地还是有一定距离的。

我非常期待Google能够做出落地的产品,但是因为Google 非垂直整合的关系,类似Waymo,最终说不准Tesla做的更好。

三、小结

总结一下,这一年半来机器人学习还是取得了挺多的进展,有的是突破性的,有的则是开了新坑,工业界则在继续推进落地,Google和Tesla 或许最有希望。当然作为这个方向的坚定信仰者,我们也需要行动起来,或许会有新的机会出现。

本文来自:知乎【Flood Sung】 作者: Flood Sung

扫码观看!

本周上新!

关于我“门”

▼

点击右上角,把文章分享到朋友圈

点击“阅读原文”按钮,查看社区原文

⤵一键送你进入TechBeat快乐星球